Google verankert Gemini als Kern von Android XR und plant KI-Brillen

Kurz & Knapp

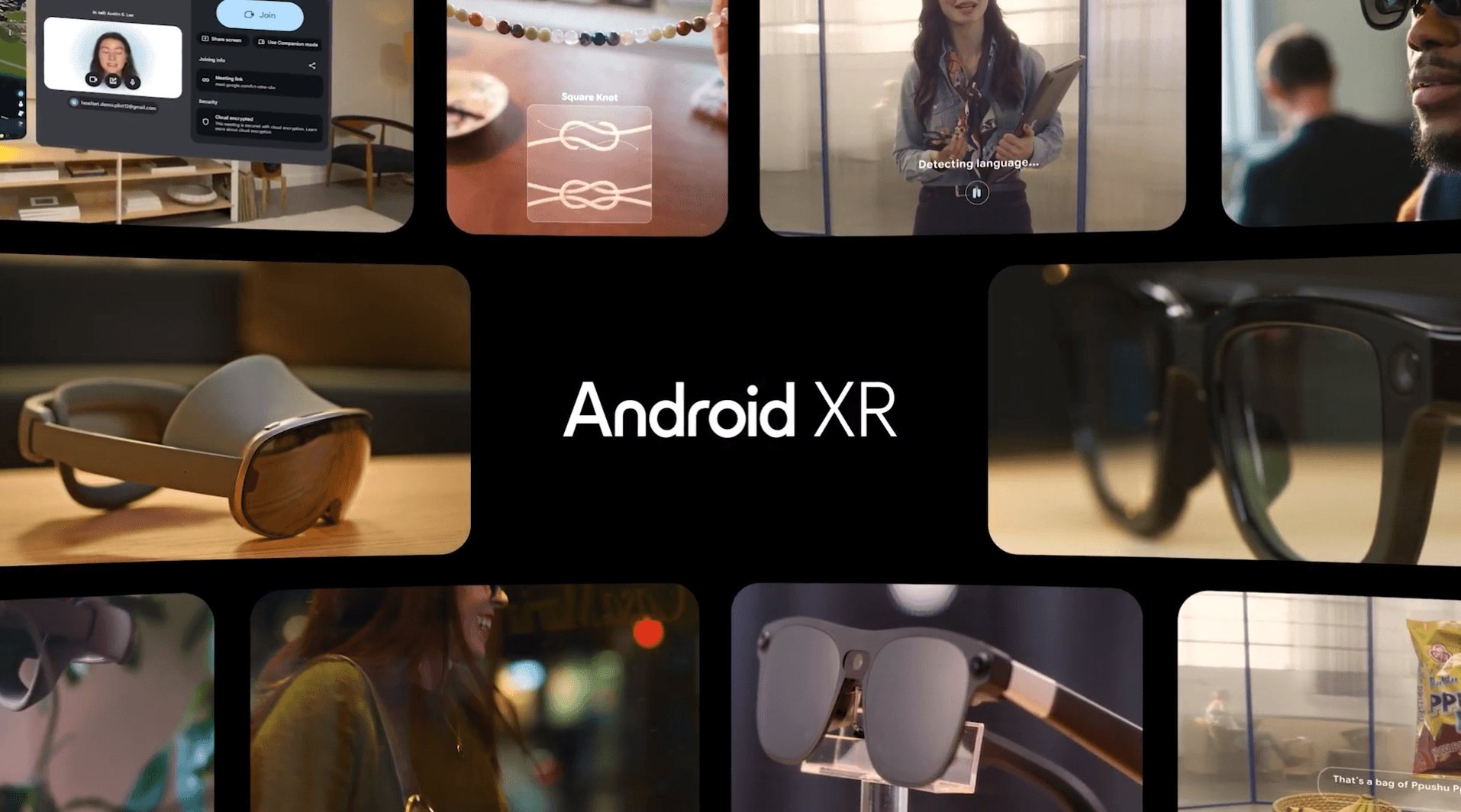

- Google verankert sein Sprachmodell Gemini als zentrale Schnittstelle im Android-XR-Ökosystem und integriert generative KI-Funktionen in Headsets wie das Samsung Galaxy XR.

- Mit Partnern wie Samsung, Gentle Monster und Warby Parker entwickelt Google Smart Glasses als Plattform für multimodale KI-Assistenten, die Objekte erkennen, übersetzen und kontextbezogene Informationen anzeigen.

- Über die neue Gemini Live API im Android XR SDK können Entwickler Anwendungen erstellen, die visuelle und auditive Umgebungsdaten der Brillen für orts- und situationsabhängige Aktionen nutzen.

Google baut sein XR-Ökosystem aus und positioniert das Sprachmodell Gemini als zentrale Schnittstelle. Neben generativen KI-Funktionen für Headsets kündigt das Unternehmen Partnerschaften für Brillen an, die primär als Hardware-Träger für multimodale KI-Assistenten dienen sollen.

Im Rahmen der „Android Show: XR Edition“ hat Google die strategische Ausrichtung seiner Extended-Reality-Plattform Android XR präzisiert. Während neue Hardware-Formfaktoren vorgestellt wurden, liegt der technologische Fokus deutlich auf der tiefen Integration von Künstlicher Intelligenz. Google beschreibt Gemini als den "Klebstoff", der das Ökosystem zusammenhält und eine kontextbezogene Interaktion über verschiedene Gerätetypen hinweg ermöglichen soll.

Für das bereits verfügbare Samsung Galaxy XR Headset rollt Google ab sofort KI-gestützte Features aus. Technisch anspruchsvoll ist dabei die neue Funktion "Likeness", die laut Google-Blog in die Beta-Phase startet. Dabei wird ein realistisches digitales Abbild des Nutzers erstellt, das Mimik und Handgesten in Echtzeit spiegelt. Dies soll die Authentizität in Videoanrufen erhöhen und setzt auf Computer-Vision-Algorithmen zur Erfassung der Nutzerdaten.

Ein weiteres KI-Feature, das für das kommende Jahr angekündigt wurde, ist die systemweite "Auto-Spatialization". Hierbei soll eine On-Device-KI herkömmliche 2D-Inhalte – etwa YouTube-Videos oder Spiele – analysieren und automatisch in stereoskopische 3D-Darstellungen umwandeln.

Die Brille als multimodales Eingabegerät

Den deutlichsten Vorstoß in Richtung allgegenwärtiger KI-Assistenz plant Google jedoch im Segment der Smart Glasses. In Kooperation mit Samsung sowie den Brillenmarken Gentle Monster und Warby Parker entwickelt der Konzern sogenannte "AI Glasses", die in direkte Konkurrenz zu Metas Angeboten gehen sollen.

Auch Google teilt Smart Glasses auf in Audio-KI-Brillen und Display-KI-Brillen, die unterschiedliche Interaktionsformen ermöglichen sollen. Alle haben jedoch Kameras und Mikrofone, die Gemini Zugriff auf die reale Umgebung des Nutzers zu geben. In einer Demo zeigte Google, wie die Brille Objekte identifiziert oder Texte in Echtzeit übersetzt - soweit bekannt. Die KI soll auch proaktiv Informationen liefern. Beispielsweise kann die Brille dem Nutzer bei Erreichen eines Bahnhofs automatisch die Abfahrtszeiten der nächsten Züge anzeigen.

Entwickler erhalten Zugriff auf Gemini Live API

Um das Ökosystem mit entsprechenden Anwendungen zu füllen, veröffentlicht Google die Developer Preview 3 des Android XR SDK. Relevant für KI-Entwickler ist hierbei die Integration der Gemini Live API für Brillen.

Dies ermöglicht die Entwicklung von Anwendungen, die visuelle und auditive Daten der Brille nutzen, um kontextbezogene Aktionen auszulösen. Als Beispiel zeigte Google eine Integration mit Uber: Die KI-Brille erkennt den Standort am Flughafen und führt den Nutzer visuell zum Abholort, identifiziert das Nummernschild des Fahrers und blendet Statusinformationen ein.

Zusätzlich zu den Brillen stellte Google mit „Project Aura“ von XREAL eine kabelgebundene XR-Brille vor, die als externer Monitor und AR-Interface dient. Auch hier ist Gemini integriert, um Bildschirminhalte zu analysieren und Hilfestellungen in Overlay-Form zu geben.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren