Künstliche Intelligenz: Google hilft Gehörlosen und bekämpft Vorurteile

Neben Googles neuer Assistant-Version kündigte Google-Chef Sundar Pichai kürzlich weitere KI-Innovationen an: Überall-Untertitel mit integrierter Übersetzungsfunktion sowie vorurteilsfreie KIs.

Googles Live Captions rollen mit Androids nächster Version Q aus. Wer schon einmal auf YouTube Untertitel genutzt hat, kennt die Idee: Eine Spracherkennungs-KI generiert automatisch passende Untertitel, bei Bedarf inklusive Übersetzung.

Neu ist, dass es diese Live-Untertitel jetzt außerhalb von YouTube gibt: Egal, was ihr auf eurem Smartphone abspielt, über den Android-Lautstärkeregler können ab Android Q jederzeit Untertitel aktiviert werden.

Google sei es gelungen, diesen vorher zwei Gigabyte großen Algorithmus auf 80 Megabyte zu schrumpfen, sagt Googles Stephanie Cuthbertson. Wie der neue Assistant läuft Live Captions daher lokal auf dem Smartphone. Eine Datenverbindung ist nicht nötig. Das schont Datenverbrauch und Privatsphäre.

Live Caption, Live Relay, Live Alles?

Live Caption funktioniert mit jeder Audioquelle, egal ob Anruf, Instagram, YouTube, Skype oder Podcast. Das ist nicht nur für Menschen praktisch, die gerne in Meetings heimlich Videos schauen.

Googles Untertitel-KI richtet sich gezielt an die 466 Millionen tauben und schwerhörigen Menschen. Man habe eng mit der Gehörlosengemeinschaft zusammengearbeitet, um Live Caption zu entwickeln, heißt es in einem Blog Beitrag von Google.

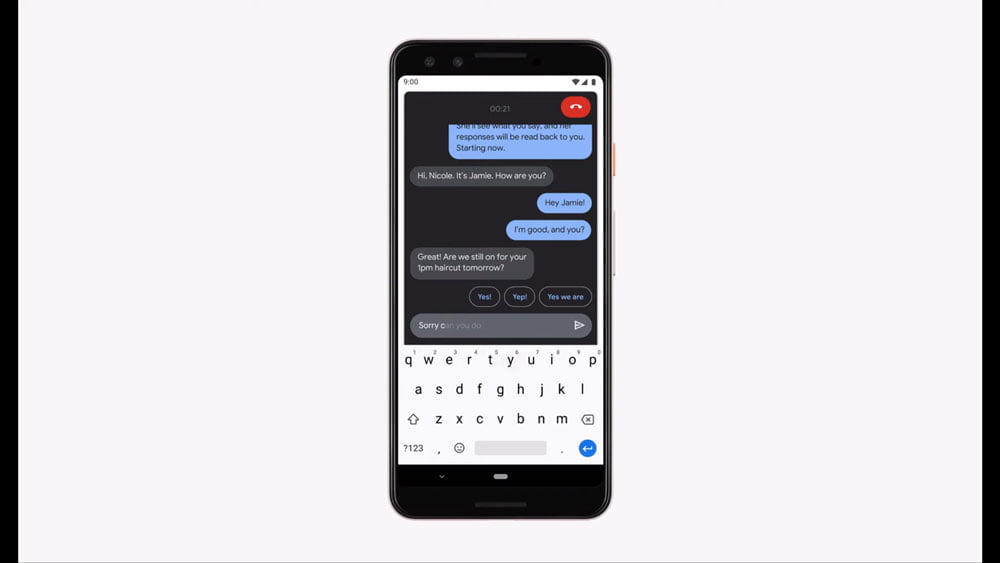

Ein weiteres Ergebnis dieser Zusammenarbeit: Ein "Live Relay" genanntes Feature nutzt die Untertitel, um gehörlosen Menschen Telefonate zu ermöglichen. In einem Interface wird die Sprache des Gegenübers in Text verwandelt. Bei Bedarf kann per Text geantwortet werden – der Google Assistant übernimmt das Sprechen.

Google will die Spracherkennung außerdem für Menschen mit Sprachfehlern verbessern. Im Euphonia genannten Projekt können etwa Opfer von Schlaganfällen mit ihrer Stimme Googles Sprach-KI auf ihre Aussprache trainieren.

Googles neue Technologie deckt KI-Vorurteile auf

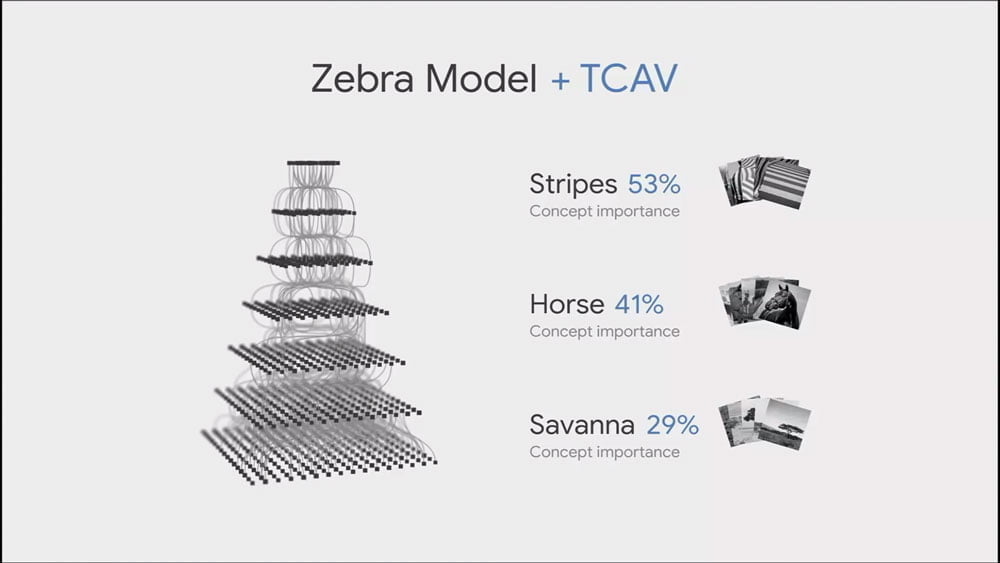

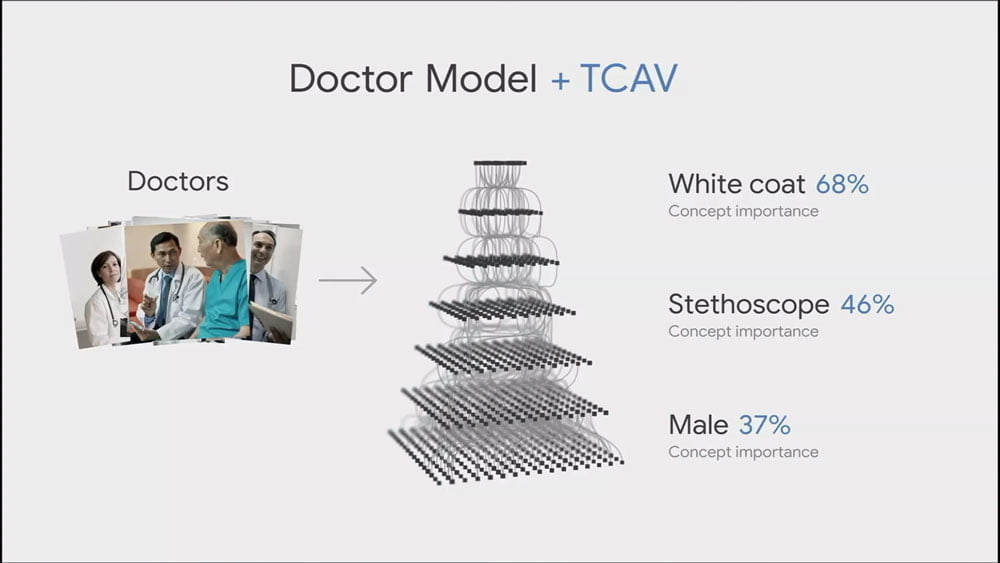

Google macht laut eigenen Angaben außerdem Fortschritte im Kampf gegen KI-Vorurteile. Eine Technologie mit dem Namen "Testing with Concept Activation Vectors" (TCAV) soll zeigen, wie eine KI zu ihren Entscheidungen kommt.

Ein Beispiel: Eine KI lernt, Ärzte auf Fotos zu erkennen. Im Training sind diese immer männlich und mit weißem Kittel und Stethoskop bekleidet. Fällt diese Diskrepanz im Training nicht auf, wird die KI in Zukunft keine oder nur sehr wenige Ärztinnen erkennen.

Hier setzt Googles neue Technologie an: Sie soll die für die Entscheidung der KI wesentlichen Merkmale identifizieren wie Geschlecht oder Hautfarbe.

Das Besondere: Diese Merkmale sind oft gar nicht Teil des Trainings, sie schleichen sich durch unausgeglichene Datensätze ein. Googles TCAV führt die KI durch mehrere Test-Durchläufe und deckt diese versteckten Missverhältnisse auf und macht sie für Laien verständlich.

Googles TCAV trägt so in zweifacher Hinsicht zur KI-Zukunft bei: Die Technologie hilft gegen KI-Vorurteile und gibt einen Einblick in die Entscheidungen der KI-Blackbox.

Quelle: Google, Venture Beat

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.