Google stellt neuen Deep-Research-Agenten und neue KI-API vor

Kurz & Knapp

- Google stellt eine verbesserte Version seines Deep-Research-Agenten vor und macht ihn erstmals über eine neue API für Entwickler zugänglich.

- Der Agent kann eigenständig Suchanfragen formulieren, Ergebnisse analysieren und iterativ nach relevanten Informationen suchen.

- Die ebenfalls neue Interactions-API soll die Entwicklung von KI-Agenten vereinfachen und bietet Funktionen wie serverseitige Zustandsverwaltung und Unterstützung für das Model Context Protocol.

Google veröffentlicht eine leistungsfähigere Version seines Deep-Research-Agenten und macht ihn erstmals über eine neue API für Entwickler zugänglich. Dazu gibt es einen neuen Open-Source-Benchmark für komplexe Webrecherche.

Google öffnet seinen Deep-Research-Agenten für Entwickler. Diese können damit erstmals Googles derzeit beste autonome Recherchefähigkeiten direkt in ihre eigenen Anwendungen einbetten. Google Deep Research erschien erstmals Ende 2024 in der Gemini-App.

Der Agent plant seine Untersuchungen iterativ: Er formuliert Suchanfragen, liest Ergebnisse, identifiziert Wissenslücken und sucht erneut, bis ein aus seiner Sicht zufriedenstellendes Ergebnis vorliegt. Die jetzt erschienene Version soll leistungsfähiger sein als das bisherige DR-Modell und auch die Websuche des kürzlich erschienenen Gemini 3 Pro leicht übertreffen.

Der Reasoning-Kern des Agenten basiert laut Google auf eben jenem Gemini 3 Pro, das darauf trainiert worden sei, Halluzinationen zu reduzieren und die Qualität von Berichten bei komplexen Aufgaben zu maximieren. KI-Fehler bleiben eine Schwäche aller gängigen Deep-Research-Systeme; obwohl man sich nicht auf die Ergebnisse verlassen kann, kann Deep Research dennoch etwa für explorative Quellensuche nützlich sein.

Benchmarks: Wie leistungsfähig ist Googles Deep-Research-Agent?

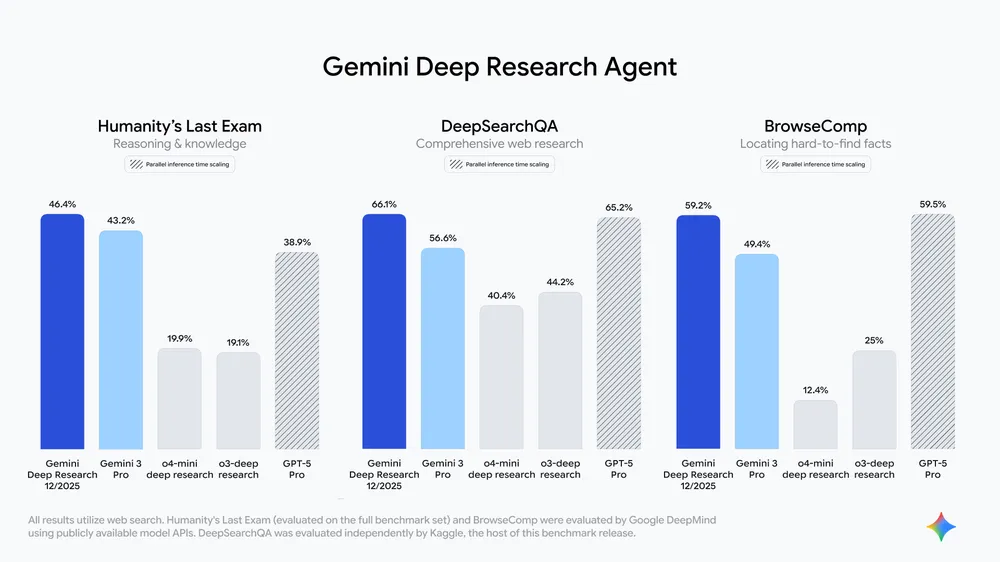

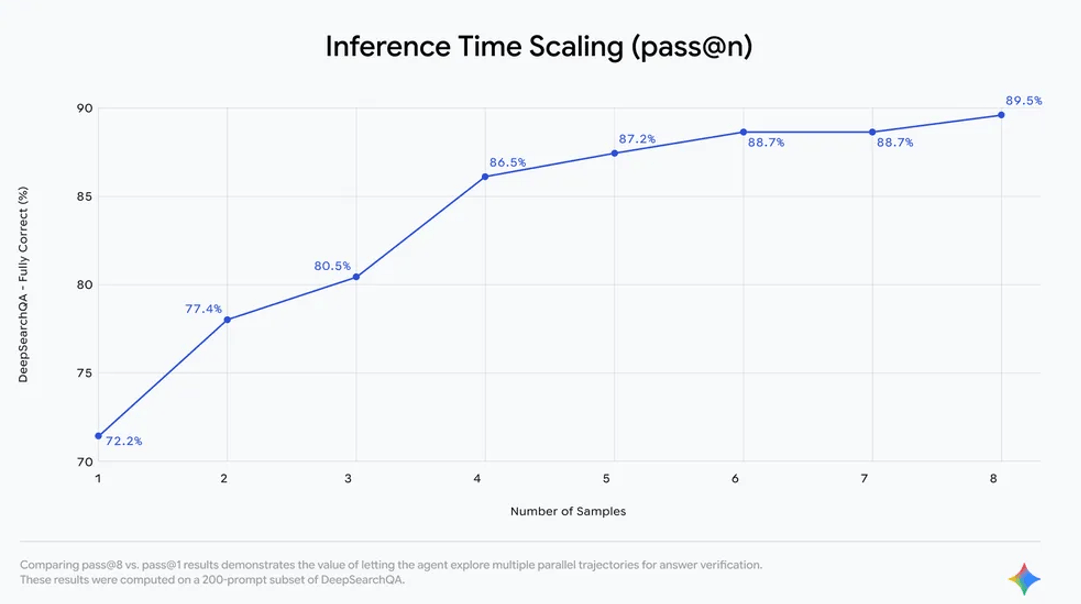

Google zufolge erreicht der neue Deep-Research-Agent State-of-the-Art-Ergebnisse auf mehreren Benchmarks: 46,4 Prozent auf dem vollständigen Humanity's Last Exam (HLE), 66,1 Prozent auf dem neuen DeepSearchQA und 59,2 Prozent auf BrowseComp. Der Agent sei zudem darauf optimiert, gut recherchierte Berichte zu niedrigeren Kosten zu generieren.

Parallel veröffentlicht Google den neuen Open-Source-Benchmark DeepSearchQA. Bestehende Benchmarks erfassten oft nicht die Komplexität realer, mehrstufiger Webrecherche, so die Begründung. DeepSearchQA umfasst 900 handgefertigte Kausalkettenaufgaben in 17 Fachgebieten, bei denen jeder Schritt von der vorherigen Analyse abhängt.

Anders als traditionelle faktenbasierte Tests misst DeepSearchQA die Vollständigkeit der Antworten. Der Benchmark bewertet sowohl Recherchepräzision als auch Retrieval-Recall und dient als Diagnosewerkzeug für die Vorteile verlängerter Denkzeit. Google stellt Dataset und Leaderboard sowie einen technischen Bericht zur Verfügung.

Der Agent bietet Entwicklern Funktionen wie die Analyse von PDFs, CSVs und Dokumenten, steuerbare Berichtsstrukturen, granulare Quellenangaben und JSON-Schema-Outputs. Künftige Updates sollen native Chart-Generierung und erweiterte MCP-Unterstützung für benutzerdefinierte Datenquellen bringen.

Das neue Deep Research soll bald auch in Google Search, NotebookLM und Google Finance verfügbar sein.

Neue API soll Entwicklung von Agenten-Apps vereinfachen

Zeitgleich zum Deep-Research-Update stellt Google mit der Interactions-API eine einheitliche Schnittstelle für die Interaktion mit Modellen wie Gemini 3 Pro und Agenten wie Deep Research vor. Die API ist als Public Beta über Google AI Studio mit einem Gemini-API-Key zugänglich. KI-Entwickler "freuen" sich über einen weiteren Schnittstellen-Standard in der ohnehin schon komplexen KI-Modell-Welt.

Google begründet die neue API damit, dass die bisherige generateContent-Schnittstelle für einfache Request-Response-Textgenerierung konzipiert gewesen sei. Neue Modellfähigkeiten wie "Thinking" und fortgeschrittene Tool-Nutzung erforderten eine native Schnittstelle. Die generateContent-API bleibe aber für Standard-Produktionsworkloads erhalten.

Die neue Schnittstelle bietet laut Google mehrere Funktionen für komplexe Agenten-Anwendungen: optionale serverseitige Zustandsverwaltung, ein interpretierbares Datenmodell für verschachtelte Nachrichten, Hintergrundausführung für lang laufende Inferenzschleifen und Unterstützung für das Model Context Protocol (MCP). Zuvor hatte Google angekündigt, dass MCP ein fester Bestandteil der eigenen Cloud-Infrastruktur wird.

Die Interactions-API befindet sich noch in der Beta-Phase und kann sich laut Google noch ändern.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren