Offener Google-Standard soll KI-Agenten schnell Nutzeroberflächen generieren lassen

Kurz & Knapp

- Google stellt mit A2UI einen offenen Standard vor, der es KI-Agenten ermöglicht, direkt grafische Oberflächen wie Formulare oder Buttons zu erzeugen.

- A2UI überträgt nur strukturierte Daten statt Code, was die Sicherheit erhöht und das Design an die jeweilige App anpasst.

- Der Standard ist plattformunabhängig, wird bereits produktiv genutzt und von mehreren Partnern unterstützt.

Google stellt mit A2UI einen offenen Standard vor, der KI-Agenten das Erstellen grafischer Oberflächen erlaubt. Statt nur Textnachrichten zu senden, können KIs dynamisch Formulare oder Buttons generieren, die sich optisch nahtlos in die jeweilige App einfügen.

Das Open-Source-Projekt A2UI (Agent-to-User Interface) soll die Art und Weise standardisieren , wie KI-Agenten visuelle Antworten generieren. Der unter der Apache-2.0-Lizenz veröffentlichte Standard zielt darauf ab, die Lücke zwischen generativen KI-Modellen und grafischen Benutzeroberflächen (GUI) zu schließen.

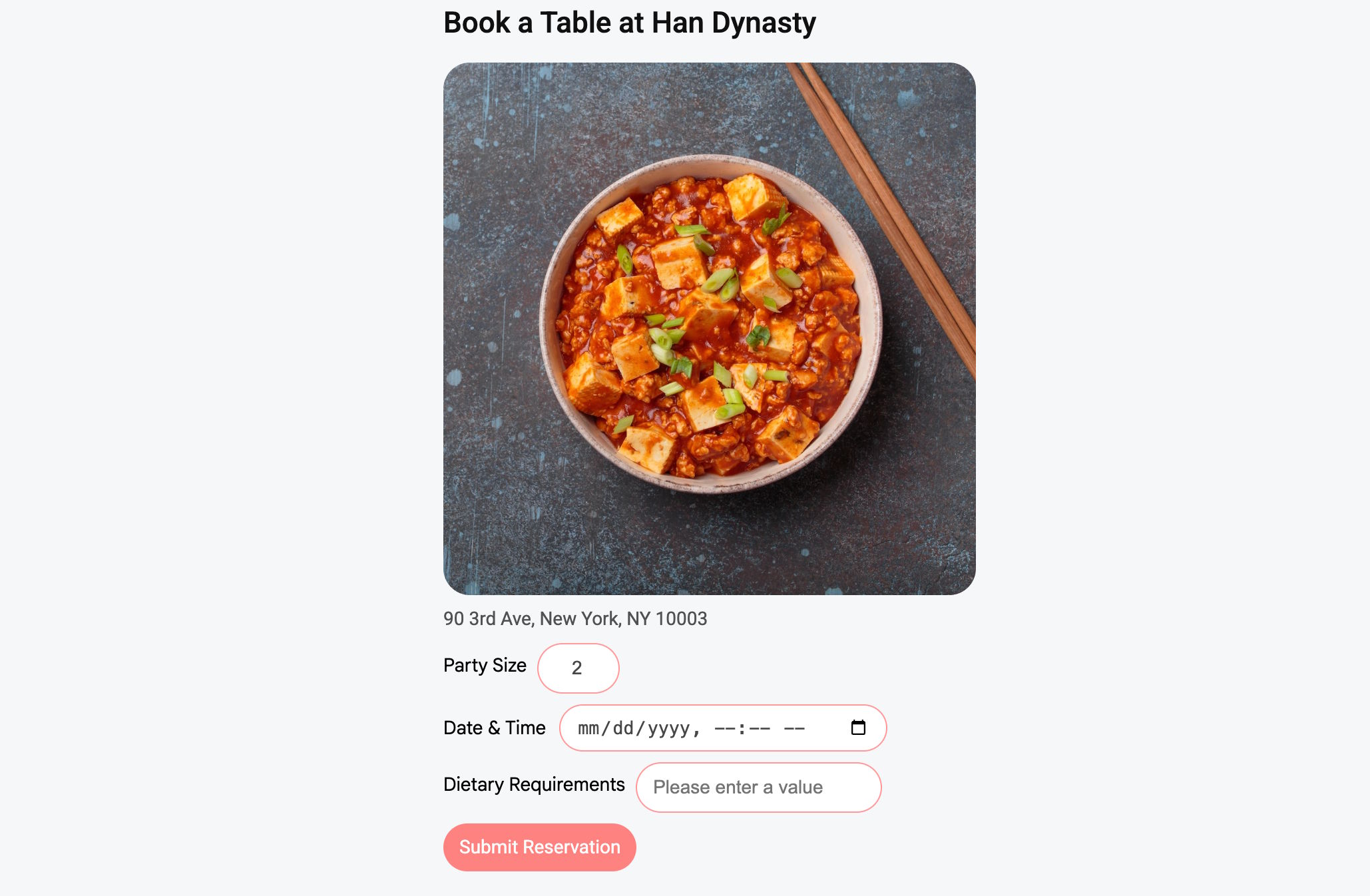

Die Grundannahme der Entwickler ist, dass reine Text- oder Code-Ausgaben für komplexe Aufgaben oft unzureichend seien. Google illustriert dies am Beispiel einer Tischreservierung, bei der ein rein textbasierter Dialog oft ineffizient und langwierig verlaufen könne.

Ein A2UI-fähiger Agent soll in einem solchen Szenario stattdessen in der Lage sein, direkt ein passendes Formular mit Datumsauswahl und verfügbaren Zeitslots zu generieren. Das Ziel sei eine "kontextbezogene Schnittstelle", die dynamisch auf den Gesprächsverlauf reagiert.

Abkehr von Iframes und ausgeführtem Code

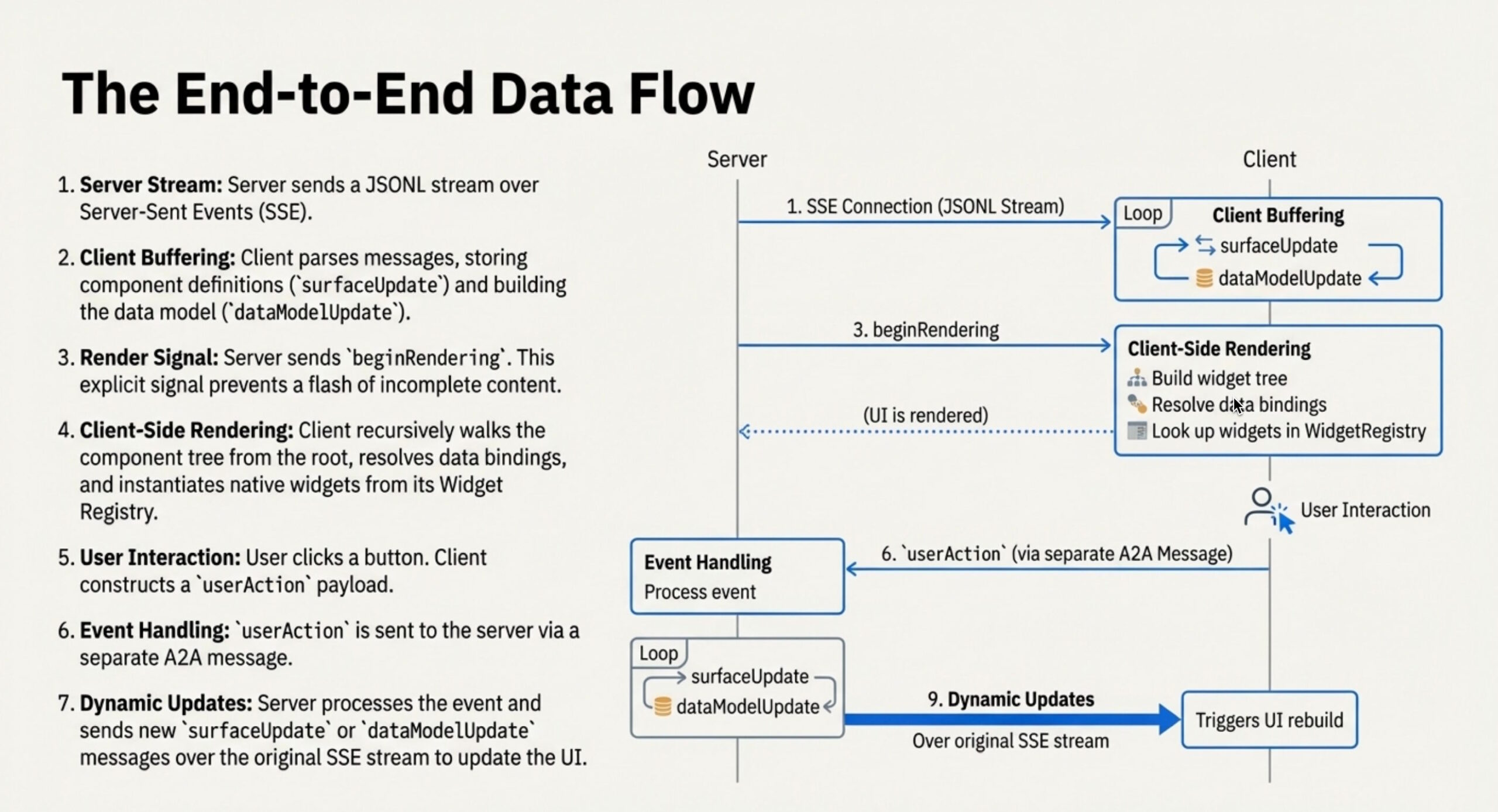

Technisch bricht A2UI mit der bisher oft üblichen Praxis, bei der Agenten HTML- oder JavaScript-Code erzeugen, der anschließend in isolierten Umgebungen wie Sandboxes oder Iframes ausgeführt wird. Laut dem Forschungsteam sei dieser herkömmliche Ansatz sicherheitstechnisch riskant und führe visuell oft zu Brüchen, da das Design selten nahtlos zur Host-Anwendung passe.

Stattdessen setzt A2UI auf einen deklarativen Ansatz, bei dem Daten statt Code übertragen werden. Der Agent sendet keine ausführbare Logik, sondern eine JSON-Datenstruktur, die die gewünschte Oberfläche beschreibt.

Die empfangende Anwendung interpretiert diese Daten und rendert sie mithilfe ihrer eigenen, nativen UI-Komponenten. Dieses Sicherheitsmodell beschränkt den Agenten auf einen vorab definierten Katalog an Komponenten wie Schaltflächen oder Textfeldern.

Dieser Mechanismus soll das Risiko von Code-Injections minimieren. Gleichzeitig behalte die Client-Anwendung die volle Kontrolle über das visuelle Styling, da der Agent lediglich die Struktur, nicht aber das pixelgenaue Design vorgibt.

Positionierung gegen Anthropics MCP und OpenAIs ChatKit

Google platziert A2UI in einem zunehmend fragmentierten Markt für sogenannte Agentic UI. Das Team grenzt seinen Ansatz explizit von anderen aktuellen Standards ab. So verfolgt das von Anthropic initiierte Model Context Protocol (MCP) laut Google eher den Ansatz, UI als Ressource zu betrachten, die oft als vorgefertigtes HTML in einer Sandbox geladen wird. A2UI hingegen verfolge einen Native-First-Ansatz, der tiefere Integrationen in die Host-App erlauben soll.

Auch gegenüber OpenAIs ChatKit zieht Google eine Grenze. Während ChatKit eine optimierte Erfahrung innerhalb des OpenAI-Ökosystems biete, sei A2UI als plattformunabhängiger Standard konzipiert. Er soll auch in komplexen Multi-Agenten-Netzwerken funktionieren, in denen ein Agent als Orchestrator fungiert und UI-Vorschläge von entfernten Sub-Agenten empfängt und sicher darstellt.

Erst vor wenigen Wochen hat Google mit der Einführung von "Generative UI" in der Gemini-App und der Suche bereits gezeigt, wie KI-Modelle interaktive Werkzeuge und Simulationen in Echtzeit erstellen können. Unter dem Namen "Dynamic View" erzeugt die KI dabei auf den Nutzer zugeschnittene grafische Oberflächen, um etwa komplexe Sachverhalte visuell greifbarer zu machen.

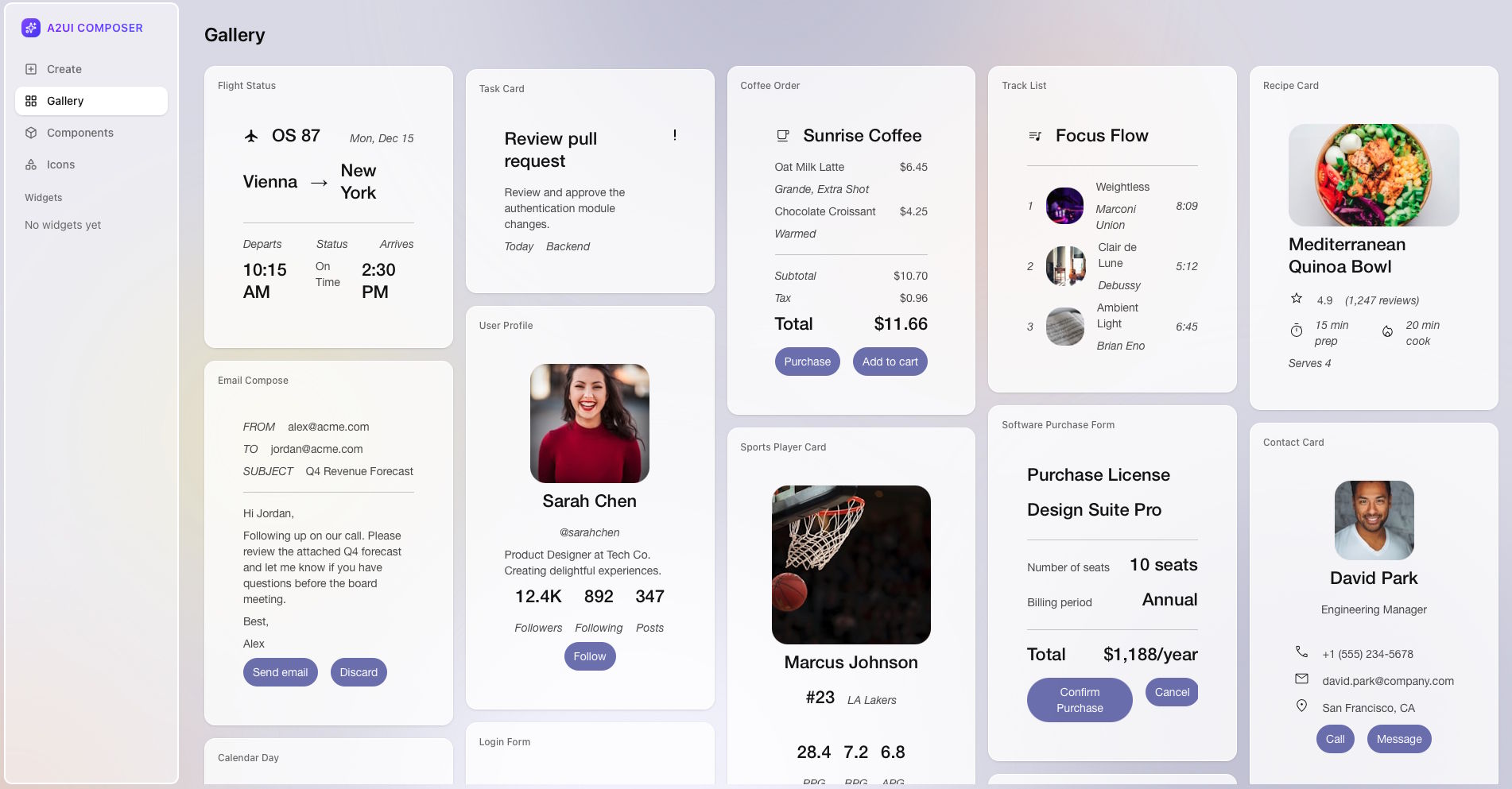

Der Standard liegt derzeit in Version 0.8 vor und wird laut Google bereits produktiv eingesetzt. So nutzt das GenUI SDK für das plattformübergreifende Toolkit Flutter A2UI, um die Kommunikation zwischen serverseitigen Agenten und mobilen Apps abzuwickeln. Auch Googles interne Mini-App-Plattform Opal sowie Gemini Enterprise greifen auf das Protokoll zurück.

Zudem kündigte Google Partnerschaften mit externen Frameworks an; das Team hinter AG UI und CopilotKit unterstützt das Protokoll vom ersten Tag an. Das Projekt stellt Client-Bibliotheken für Flutter, Web Components und Angular bereit und lädt die Entwickler-Community dazu ein, weitere Renderer und Integrationen beizusteuern. Angesichts der rasanten Verbreitung anderer KI-Standards wie MCP hat auch A2UI gute Voraussetzungen, schnell in der Breite adaptiert zu werden, nicht als Ersatz, sondern als Ergänzung.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren