GPT-5 löst angeblich offenes Mathe-Problem ohne menschliche Hilfe

Kurz & Knapp

- Der Mathematiker Johannes Schmitt berichtet, dass GPT-5 erstmals ein offenes mathematisches Problem eigenständig gelöst hat.

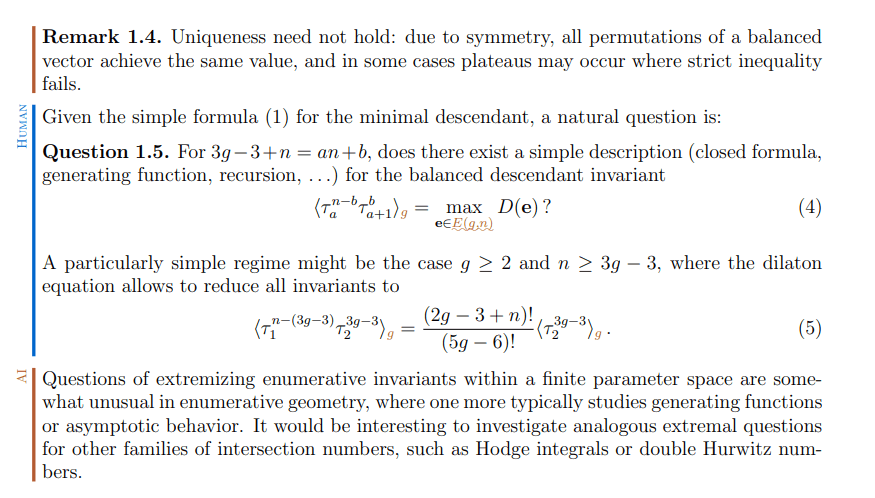

- Das daraus entstandene Paper dokumentiert transparent die Zusammenarbeit zwischen Mensch und KI: Jeder Absatz ist gekennzeichnet, ob er von einer KI oder einem Menschen stammt, inklusive Links zu Prompts und Gesprächsprotokollen.

- Schmitts Ansatz ermöglicht hohe Nachvollziehbarkeit, ist aber aufwendig und wirft Fragen nach der klaren Abgrenzung zwischen menschlichem und KI-Beitrag auf.

Es gibt in der Wissenschaft eine große Diskussion, wie KI transparent in Schreib- und Forschungsprozesse integriert werden kann. Der Schweizer Mathematiker Johannes Schmitt hat dazu jetzt einen Vorschlag gemacht.

Schmitt berichtet auf X, dass GPT-5 erstmals ein seinen Recherchen nach offenes mathematisches Problem selbstständig gelöst hat – ohne menschliche Hinweise oder Eingriffe. GPT-5 lieferte laut Schmitt eine elegante Lösung, die überraschenderweise Techniken aus einem anderen Bereich der algebraischen Geometrie nutzte, statt die üblichen Methoden anzuwenden. Das Peer-Review steht noch aus. Solche anekdotischen Berichte über den Nutzen von KI in der Mathematik gab es zuletzt unter anderem von Mathematik-Star Terence Tao.

Das daraus entstandene Paper zeigt verschiedene Formen der Mensch-KI-Zusammenarbeit: Beweise von GPT-5 (Basismodell, nicht Pro) und Gemini 3 Pro, Textpassagen von Claude sowie formale Lean-Beweise über Claude-Code und ChatGPT 5.2. Als Experiment für transparente KI-Zuordnung sind alle Absätze als menschlich oder KI-geschrieben gekennzeichnet, mit Links zu Prompts und Gesprächsprotokollen.

Transparenz ist wichtig, aber sie darf nicht zur Bürokratie werden

Schmitts Ansatz bietet hohe Transparenz und Nachvollziehbarkeit – jeder kann prüfen, welche Ideen von Menschen und welche von KI stammen. Allerdings hat das Vorgehen auch Nachteile: Die detaillierte Kennzeichnung jedes Absatzes ist aufwendig und könnte unpraktisch werden, wenn KI ohnehin zum alltäglichen Werkzeug wird. Transparenz ist wichtig, aber sie darf nicht zur Bürokratie werden.

Zudem lässt sich die Grenze zwischen menschlichem und KI-Beitrag nicht immer klar ziehen. Wer formuliert den Prompt, wer wählt aus, wer korrigiert? Für andere Wissenschaften dürfte dieses Modell kaum übertragbar sein.

Vielleicht sollte die Wissenschaft zunächst eine grundlegendere Frage klären: Warum ist es wichtig zu wissen, ob eine Leistung von einem Menschen allein, einem Menschen mit KI-Unterstützung oder ausschließlich von KI erbracht wurde – und ist Letzteres ohne menschliche Absicht überhaupt möglich?

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren