KI-Agenten könnten künftig in LLM-generierten Weltmodellen Erfahrung sammeln

Ein internationales Forscherteam hat systematisch untersucht, ob Large Language Models die Rolle von Weltmodellen übernehmen können. Die Ergebnisse deuten auf einen Weg hin, das Trainingsproblem bei KI-Agenten zu lösen.

KI-Agenten, die selbstständig Aufgaben erledigen sollen, stehen vor einem grundlegenden Problem: Sie benötigen Erfahrung, um zu lernen, und diese Erfahrung sollte aus der Interaktion mit Umgebungen stammen. Reale Umgebungen sind jedoch begrenzt, schwer skalierbar und oft nicht adaptiv genug.

Ein Forscherteam von Institutionen wie der Southern University of Science and Technology, Microsoft Research, Princeton University und der University of Edinburgh hat nun untersucht, ob Large Language Models dieses Problem lösen können, indem sie als Weltmodelle fungieren.

Ein Weltmodell ist im Kern ein interner Simulator: Es sagt vorher, was passiert, wenn ein Agent eine bestimmte Aktion ausführt. Statt in einer echten Umgebung zu agieren, könnte ein Agent in einem solchen Modell trainieren und durch simulierte Erfahrung effizienter lernen.

Die zentrale Idee der Studie: Das Paradigma der Sprachmodellierung kann umgedeutet werden. Statt das nächste Wort vorherzusagen, prognostiziert das Modell den nächsten Zustand einer Umgebung nach einer Aktion.

Fünf Testumgebungen von Haushalt bis E-Commerce

Die Forscher testeten ihren Ansatz an fünf textbasierten Umgebungen. In ALFWorld muss ein Agent Haushaltsaufgaben erledigen, etwa eine Tasse kühlen und in die Kaffeemaschine stellen. SciWorld simuliert ein Labor, in dem wissenschaftliche Experimente durchgeführt werden. TextWorld bietet narrative Aufgaben mit Erkundung und Rätseln. WebShop simuliert eine Shopping-Website, auf der Produkte nach bestimmten Kriterien gefunden werden müssen. StableToolBench testet die Nutzung von API-Werkzeugen.

Diese Auswahl deckt sowohl strukturierte Domänen mit klaren Regeln als auch offene Umgebungen mit hoher Variabilität ab. Die Forscher bewerteten die Weltmodelle auf drei Ebenen: Wie präzise und konsistent sagen sie Zustandsübergänge vorher, auch über längere Abläufe hinweg? Wie gut skalieren diese Fähigkeiten mit mehr Daten und größeren Modellen, und wie robust bleiben sie unter veränderten Bedingungen? Und wie nützlich sind die Weltmodelle tatsächlich für das Training von Agenten?

Fine-Tuning bringt deutliche Verbesserungen

Die Ergebnisse zeigen, dass vortrainierte Sprachmodelle bereits eine gewisse Fähigkeit zur Weltmodellierung besitzen. Claude-sonnet-4.5 erreichte mit nur drei Beispielen eine Genauigkeit von 77 Prozent bei der Vorhersage des nächsten Zustands in der Haushaltsumgebung. Diese Fähigkeit reichte laut den Forschern jedoch nicht für komplexere Szenarien.

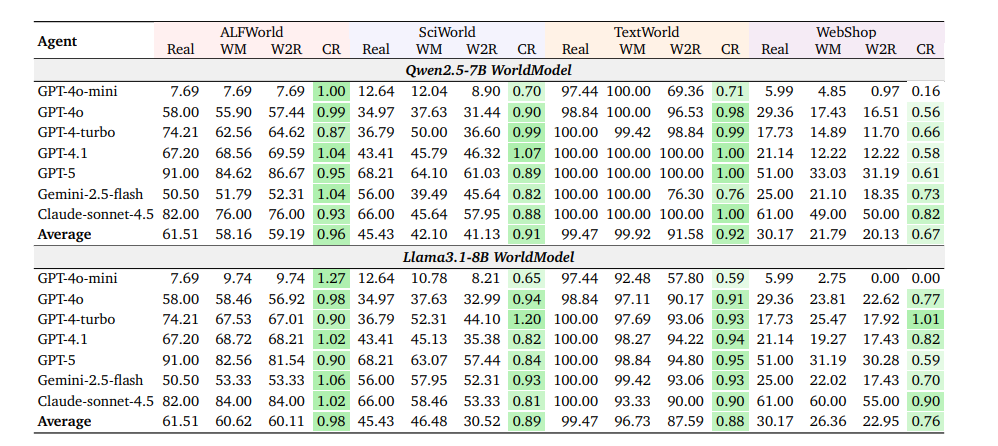

Erst das gezielte Training auf echten Interaktionsdaten brachte den Durchbruch: Die Modelle Qwen2.5-7B und Llama‑3.1‑8B erreichten nach dem Fine-Tuning bei ALFWorld über 99 Prozent Genauigkeit, bei SciWorld etwa 98,6 Prozent und bei TextWorld etwa 70 Prozent.

Auch über längere Abläufe hinweg blieben die Modelle meist verlässlich: In den strukturierten Domänen lag die sogenannte Consistency Ratio (CR) bei mehr als 90 Prozent. Sie misst, wie oft eine im Weltmodell "ausgedachte" Aktionsfolge, wenn man sie anschließend in der realen Umgebung ausführt, im Verhältnis zur normalen Erfolgsrate in der realen Umgebung ebenfalls zum Erfolg führt.

Die E-Commerce-Simulation stellte hingegen größere Herausforderungen dar. Die Konsistenzraten lagen hier im Durchschnitt bei etwa 70 Prozent, variierten jedoch stark je nach Agent. Schwächere Agenten zeigten deutlich niedrigere Werte. Die hohe Vielfalt möglicher Suchergebnisse machte eine akkurate Simulation schwieriger. Initialisierten die Forscher die simulierten Abläufe jedoch mit echten Beobachtungen, stieg die Konsistenz auf nahezu 100 Prozent, selbst bei einem GPT-4o-Agenten.

Das Weltmodell-LLM (Qwen2.5-7B oder Llama3.1-8B) fungiert als Umgebungssimulator und sagt vorher, was nach jeder Aktion passiert. Die in den Zeilen aufgeführten Agenten-LLMs (GPT-4o, GPT-4-turbo, Claude-sonnet-4.5 etc.) planen und führen Aktionen innerhalb dieser simulierten Umgebung aus.

Weltmodelle skalieren systematisch

Die Forscher identifizierten zudem klare Skalierungsmuster. Strukturierte Umgebungen wie die Haushalts- oder Laborsimulation erreichten ihre maximale Genauigkeit bereits bei etwa 20 000 Trainingstrajektorien, also vollständigen Handlungsabfolgen eines Agenten von Anfang bis Ende einer Aufgabe. Offene Umgebungen wie die Shopping-Website profitierten hingegen weiter von zusätzlichen Daten – bis zu 70 000 Trajektorien.

Bei der Modellgröße zeigte sich ein ähnliches Bild: Für strukturierte Umgebungen reichten bereits Modelle mit 1,5 Milliarden Parametern aus. Komplexere Szenarien erforderten jedoch größere Kapazitäten. Die Forscher folgern daraus, dass der Erfolg bei der Weltmodellierung sowohl von der Datenmenge als auch von der Modellgröße abhängt und beides mit der Umgebungskomplexität skaliert werden muss.

Von Wörtern zu Welten

Die Ergebnisse fügen sich in eine breitere Debatte über die Zukunft der KI-Entwicklung ein. Der Turing-Preisträger Richard Sutton hatte zuletzt kritisiert, die KI-Industrie habe "in gewissem Maße ihren Weg verloren". Heutige Systeme bekämen ihr Wissen zur Entwicklungszeit einprogrammiert, statt kontinuierlich aus Erfahrung zu lernen.

Gemeinsam mit dem Deepmind-KI-Forscher David Silver forderte er in seinem Aufsatz "Welcome to the Era of Experience" einen Paradigmenwechsel: KI-Agenten sollten aus eigener Erfahrung lernen, wobei Weltmodelle als interne Simulatoren eine zentrale Rolle spielen.

Die aktuelle Studie liefert empirische Belege für einen Teil dieser Vision: Sie zeigt, dass LLMs lernen können, Umgebungsdynamiken zu simulieren, und damit einen möglichen Baustein für ein erfahrungsbasiertes Trainingsparadigma von Agenten darstellen. Sie behandelt jedoch nicht Suttons Kernkritik: das fehlende kontinuierliche Lernen ohne Wissensverlust, das er als entscheidende Hürde auf dem Weg zu echter Intelligenz sieht.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.