NeurIPS-Analyse zeigt: Selbst Google-Autoren sind vor KI-Halluzinationen nicht sicher

Kurz & Knapp

- Das KI-Erkennungsunternehmen GPTZero fand in 51 von 4.841 analysierten Papers der KI-Konferenz NeurIPS 2025 mindestens 100 halluzinierte Zitate - obwohl die Arbeiten den Peer-Review-Prozess durchlaufen hatten.

- Die Einreichungen bei NeurIPS stiegen zwischen 2020 und 2025 um mehr als 220 Prozent von 9.467 auf 21.575, was das System überfordert. Zudem wächst das Misstrauen gegenüber Gutachtern, die teils KI-Tools nutzen statt Papers zu lesen.

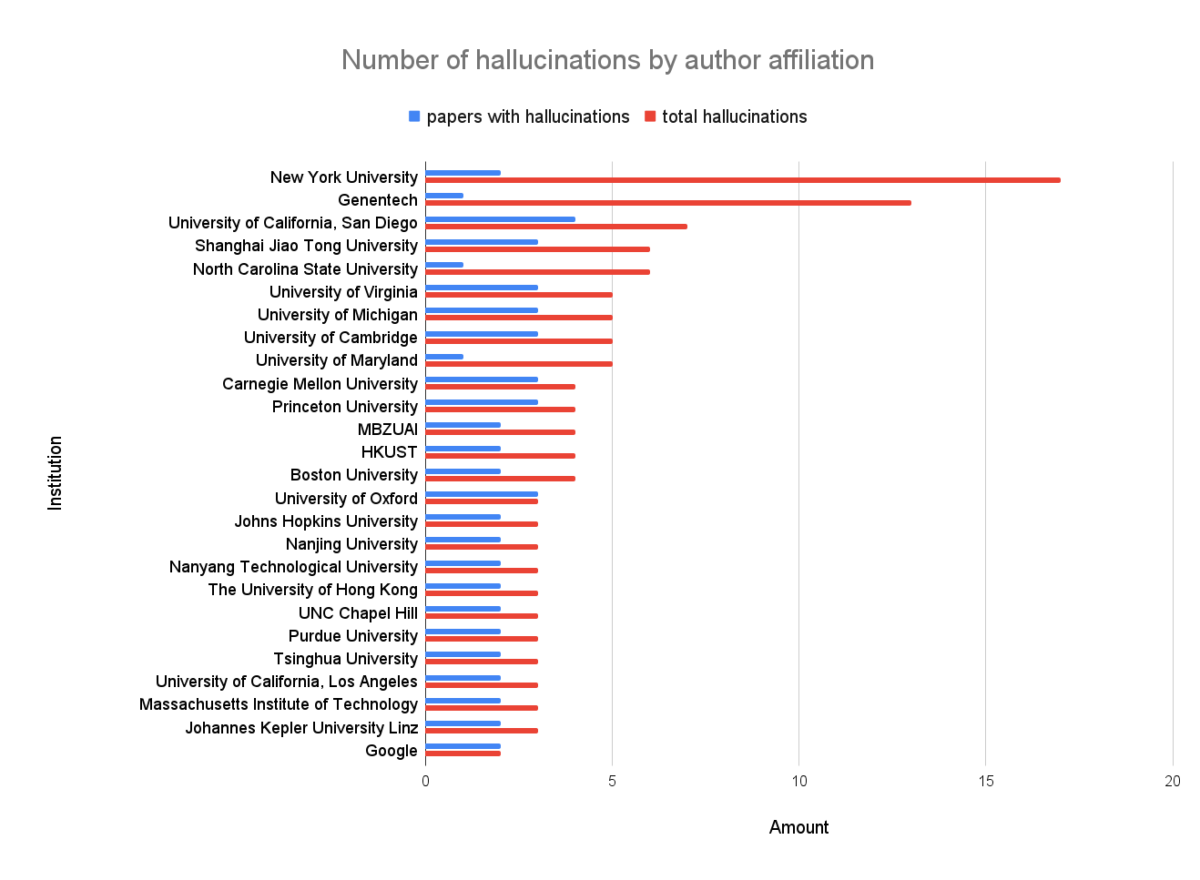

- Unter den Funden sind amerikanische Top-Universitäten und Anbieter wie Google.

Eine Analyse von knapp 5.000 akzeptierten Forschungsarbeiten der KI-Konferenz NeurIPS 2025 fördert über 100 erfundene Quellenangaben zutage - trotz Begutachtung durch mehrere Reviewer.

Die Conference on Neural Information Processing Systems (NeurIPS) zählt zu den renommiertesten KI-Konferenzen weltweit. Doch bei der Analyse von 4.841 der 5.290 akzeptierten Papers der Konferenz im November 2025 stieß das KI-Erkennungsunternehmen GPTZero auf mindestens 100 bestätigte halluzinierte Zitationen, verteilt auf 51 wissenschaftliche Arbeiten.

Diese Papers haben den vollständigen Peer-Review-Prozess durchlaufen, bei dem jede Einreichung von mindestens drei Gutachtern geprüft wird. Bei einer Akzeptanzrate von 24,52 Prozent setzten sich diese Arbeiten gegen rund 15.000 andere Einreichungen durch - obwohl sie erfundene Quellenangaben enthielten.

Von "John Doe" bis zu erfundenen DOIs

Die dokumentierten Fälle zeigen ein breites Spektrum an Fehlern. Im Paper "SimWorld" tauchen die offensichtlich fiktiven Autoren "John Doe and Jane Smith" auf. Bei "Unmasking Puppeteers" führen DOIs und URLs ins Leere. Ein Paper zur semantischen Unsicherheitsquantifizierung enthält gleich 15 halluzinierte Zitationen, darunter unvollständige arXiv-IDs wie "arXiv:2305.XXXX".

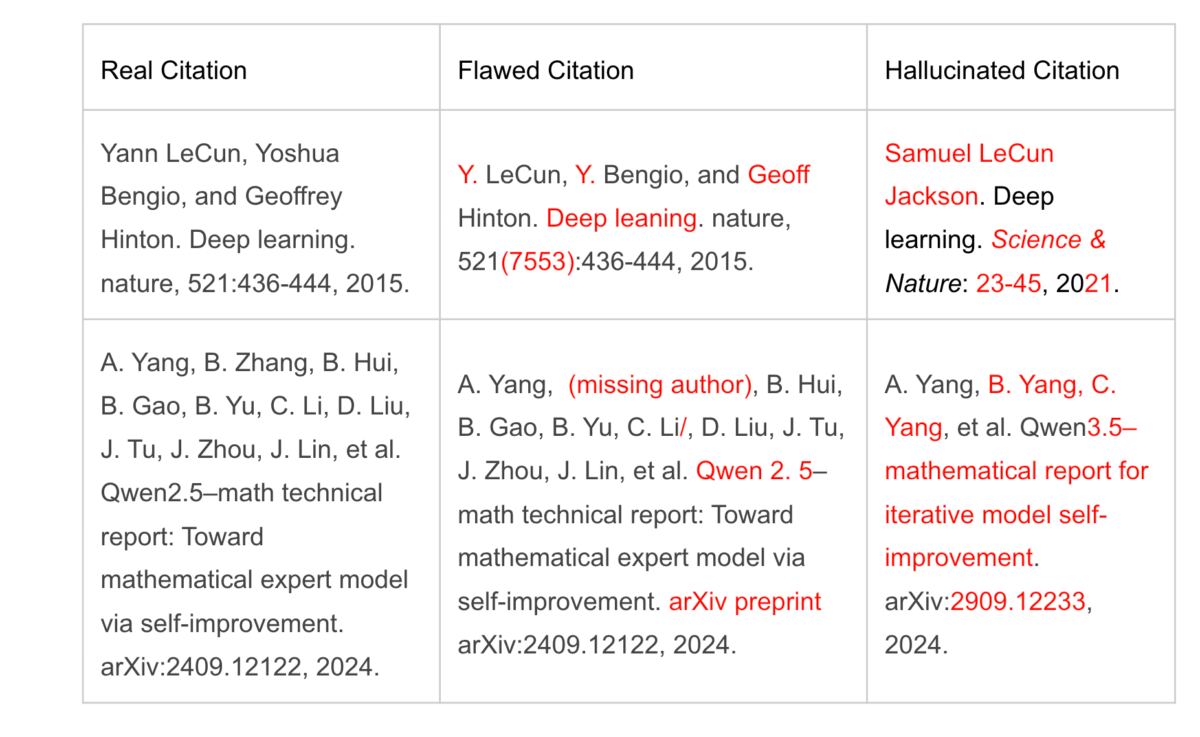

GPTZero prägte für dieses Phänomen den Begriff "Vibe Citing". Gemeint sind Zitationen, die auf den ersten Blick korrekt aussehen, bei genauerer Prüfung jedoch zerfallen. Typische Muster: Titel, Autoren oder Quellenangaben werden aus echten Publikationen kombiniert oder paraphrasiert. Autoren, URLs und DOIs werden schlicht erfunden. Manchmal werden Autorennamen aus Initialen extrapoliert oder Titel leicht abgewandelt.

Erfundene Quellenangaben und erfundene Fakten

Bereits im Dezember 2025 hatte GPTZero mehr als 50 halluzinierte Zitationen in Papers identifiziert, die bei der ICLR 2026 zur Begutachtung eingereicht wurden. Alex Cui von GPTZero betont, dass es zwar auch früher falsche Zitatioinen gegeben habe, aber die Anzahl durch KI höher sei. Konkrete Zahlen nennt er nicht. Sowohl NeurIPS als auch ICLR betrachten halluzinierte Zitationen als Grund für Ablehnung oder Rücknahme einer Arbeit.

Die Untersuchung beschränkt sich bewusst auf Zitationen. KI-generierten Text zuverlässig zu identifizieren bleibt schwierig, und GPTZero platziert mit der Analyse auch sein neues Produkt zur Überprüfung von Quellenangaben. Die eigentlich interessantere Frage - ob sich in den Papers auch inhaltliche Halluzinationen finden - bleibt unbeantwortet.

Laut Cui wolle man als nächstes die Anhänge der Papers untersuchen. Diese würden seiner Einschätzung nach seltener gelesen und enthielten daher wahrscheinlicher Halluzinationen. Solche inhaltlichen Fehler aufzuspüren wäre allerdings deutlich aufwendiger als das Flaggen erfundener Quellenangaben: Selbst eindeutig KI-generierter Text kann inhaltlich korrekt sein. Das Unternehmen müsste für eine solche Analyse echtes Factchecking betreiben statt nur statistische Muster zu erkennen.

Ein Tsunami an Einreichungen überfordert das System

Hinter dem Problem steht auch eine Frage der Kapazität. Zwischen 2020 und 2025 stiegen die Einreichungen bei NeurIPS um mehr als 220 Prozent - von 9.467 auf 21.575. Um diese Flut zu bewältigen, mussten die Organisatoren immer mehr Gutachter rekrutieren. Die Folge: Probleme bei Aufsicht, Expertise-Abstimmung und Sorgfalt.

Doch das Problem beschränkt sich nicht auf die Autorenseite. Wie ein Thread auf Reddit im Vorfeld der ICLR 2026 zeigte, wächst auch das Misstrauen gegenüber Gutachtern. Autoren des Papers "Efficient Fine-Tuning of Quantized Models" zogen ihre Einreichung unter Protest zurück. Ihr Vorwurf: Die Reviewer hätten das Paper nicht gelesen und stattdessen KI-Tools genutzt, um Kritikpunkte zu generieren. Bemängelt wurden angeblich fehlende Experimente, die laut den Autoren explizit im Text vorhanden waren.

"Wo das Wasser zu sauber ist, gibt es keine Fische"

Die Vorfälle sind Symptome tieferliegender struktureller Probleme. Eine 2024 im Journal Research Ethics veröffentlichte Studie der Forscher Xinqu Zhang und Peng Wang analysierte am Beispiel chinesischer Elite-Universitäten, wie staatliche Initiativen eine toxische Anreizstruktur schaffen.

Die Studie identifiziert den Mechanismus des "cengceng jiama" - eine stufenweise Erhöhung des Drucks innerhalb der bürokratischen Hierarchie. Während die Zentralregierung vage Ziele wie "Weltklasse-Status" vorgibt, interpretieren Universitätsleitungen dies als strikte Ranking-Vorgaben. Diese werden an Fakultäten weitergereicht, die aus Angst vor Versagen die Anforderungen noch verschärfen.

Der resultierende Druck führt laut der Studie zu einer "Entkopplung von Zielen und Mitteln". Um unrealistische Produktivitätsziele zu erreichen, lösen sich Forscher von ethischen Normen. Nachwuchswissenschaftler gaben offen zu, "keine Wahl" gehabt zu haben, als Daten zu fälschen oder Ghostwriting-Dienste zu nutzen. Heute kommt generative KI zum Einsatz, Frameworks wie Sakanas "AI Scientist" sind explizit für KI-generierte Forschung designt. Die Studie zitiert Daten des Verlags Hindawi, der 2023 mehr als 9.600 Papers zurückzog - etwa 8.200 davon hatten Co-Autoren aus China.

Laut dem Bericht tolerieren die Institutionen das Fehlverhalten stillschweigend, solange die Ergebnisse stimmen. Ein Dekan wird mit dem chinesischen Sprichwort zitiert: "Wo das Wasser zu sauber ist, gibt es keine Fische." Man dürfe bei der Bestrafung von Fehlverhalten nicht zu streng sein, da dies die Forschungseffizienz beeinträchtige.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren