Microsofts neuer KI-Beschleuniger Maia 200 soll Amazon- und Google-Chips übertreffen

Microsoft stellt seinen neuen KI-Inferenz-Chip Maia 200 vor. Der Chip ist speziell für die Inferenz entwickelt worden und soll 30 Prozent bessere Leistung pro Dollar bieten als die aktuelle Chip-Generation in Microsofts Rechenzentren. Er basiert auf TSMCs 3-Nanometer-Verfahren mit über 140 Milliarden Transistoren und verfügt über 216 GB Hochgeschwindigkeitsspeicher.

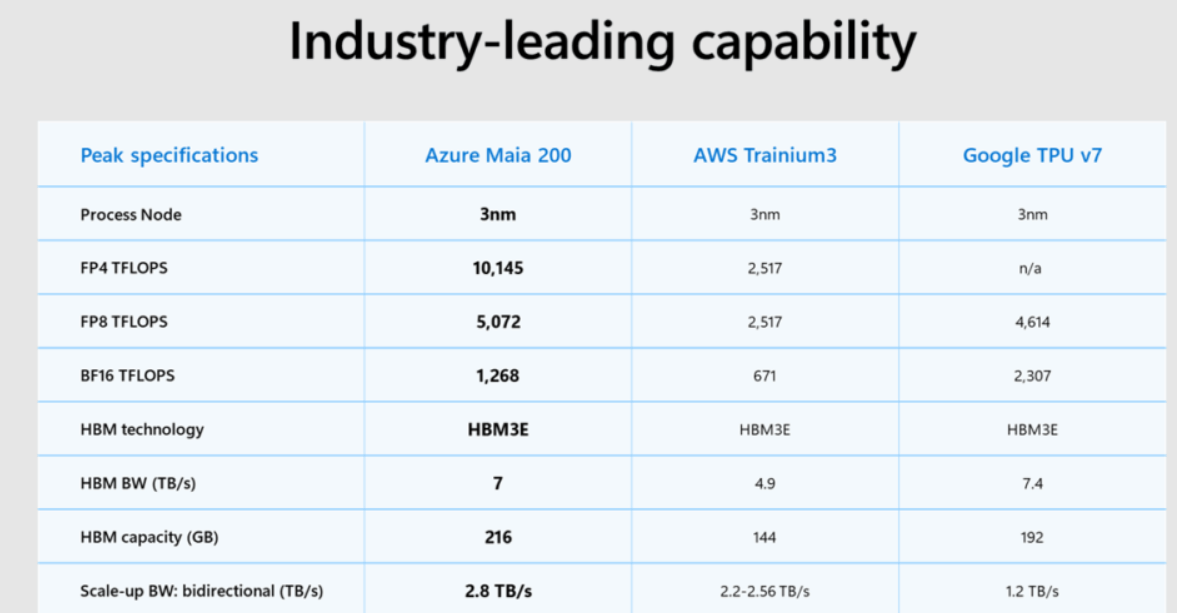

Laut Microsoft ist Maia 200 der leistungsstärkste hauseigene Chip aller großen Cloud-Anbieter. Er biete dreimal so viel FP4-Leistung wie Amazons Trainium 3 und übertreffe Googles TPU v7 bei FP8-Berechnungen. Eine unabhängige Bewertung steht noch aus.

Microsoft setzt den Chip laut eigenen Angaben für OpenAIs GPT-5.2-Modelle sowie für Microsoft 365 Copilot ein. Entwickler können sich für eine Vorschau des Maia SDK anmelden. Maia 200 ist zunächst im Rechenzentrum in Iowa verfügbar, Arizona folgt als Nächstes. Technische Details zum Chip stehen hier.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren