Nvidia-CEO Jensen Huang halluziniert, Sprachmodelle würden nicht mehr halluzinieren

Kurz & Knapp

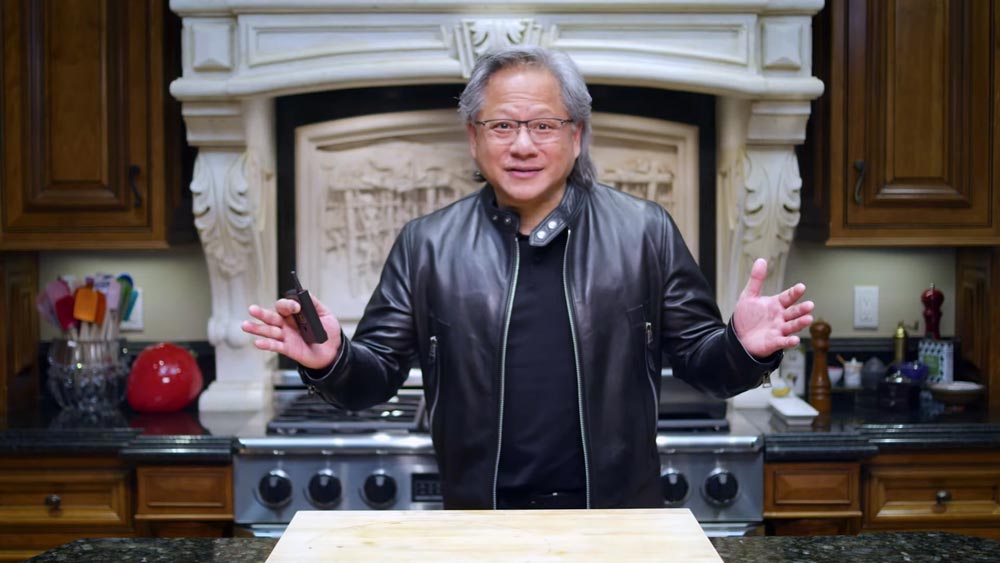

- Nvidia-CEO Jensen Huang behauptete in einem CNBC-Interview, generative KI "halluziniere nicht mehr".

- Eine Aussage, die faktisch falsch ist, da Halluzinationen ein strukturelles Problem der wahrscheinlichkeitsbasierten Architektur von Sprachmodellen bleiben. Deren Lösung würde die Branche grundlegend verändern.

- Das Interview erschien, nachdem Nvidias Großkunden Meta, Amazon und Google an der Börse unter Druck gerieten, weil sie trotz bereits hoher Budgets weitere Milliarden in KI-Infrastruktur investieren wollen.

Wer glaubt, dass sich KI in einer Blase befindet, könnte sich durch ein aktuelles CNBC‑Interview mit Nvidia‑CEO Jensen Huang bestätigt fühlen.

Das Interview erschien, nachdem Nvidias Großkunden Meta, Amazon und Google an der Börse unter Druck geraten waren, weil sie angekündigt hatten, trotz ohnehin enormer Budgets noch mehr Geld in KI‑Infrastruktur zu stecken.

Im Interview wiederholt Huang, was man aus der KI‑Branche ständig hört: Mehr Rechenleistung bedeute automatisch mehr Umsatz. Nvidia verdient als Chiplieferant direkt daran, dass diese Rechnung geglaubt wird. Dabei stimmt an der Grunderzählung etwas: Die Nachfrage nach KI‑Rechenleistung ist real, die Modelle werden besser, die Umsätze der großen KI‑Anbieter steigen tatsächlich, die Fortschritte bei agentischer KI sind beeindruckend.

Aber Huang überdehnt diese Beobachtungen bis zur Unkenntlichkeit, etwa wenn er behauptet, der aktuelle KI-Ausbau sei die "größte Infrastruktur-Aufrüstung der Menschheitsgeschichte" – als hätte es Elektrifizierung, Eisenbahn, Straßennetze oder den globalen Ausbau fossiler Energieinfrastruktur nie gegeben.

Huang halluziniert: KI-Modelle halluzinieren nicht mehr

Am deutlichsten wird diese Übertreibung an einer konkreten Stelle. Huang sagt wörtlich: "KI ist extrem nützlich und halluziniert nicht mehr." Sprachmodelle würden also keine falschen Informationen mehr erzeugen. Das stimmt nicht.

Man könnte Huang zugutehalten, er habe selbst halluziniert. Dass er eigentlich "deutlich weniger" meinte oder "selten genug, dass es kaum noch auffällt". Wahrscheinlich ist dem sogar so.

Aber gerade diese Unterscheidung ist alles andere als nebensächlich. Halluzinationen sind kein Fehler, den man wegpatchen kann – sie sind ein Nebenprodukt der wahrscheinlichkeitsbasierten Architektur, auf der Sprachmodelle basieren. Genau das sorgt etwa in Unternehmen für Zurückhaltung und langsame Adaption: fehlende Verlässlichkeit, notwendige menschliche Kontrolle, offene Sicherheitsfragen.

Huangs falsche Behauptung ist daher keine Kleinigkeit. Wären Halluzinationen tatsächlich gelöst, wäre der "Human in the Loop" weitgehend überflüssig: Rechtsberatung etwa ließe sich vollständig automatisieren, KI-generierter Code könnte direkt in Produktion gehen, medizinische Diagnosen könnten ohne ärztliche Prüfung gestellt werden, und KI-Systeme könnten sich selbst verbessern, weil sich Fehler nicht mehr aufsummieren.

Die Realität sieht anders aus: Verlässlichkeit bleibt die größte Baustelle generativer KI. Ob das Menschen interessiert und was die Konsequenz daraus ist, ist eine andere Frage. Nicht umsonst bilden sich gerade eine Reihe neuer KI-Start-ups, die nach neuen Architekturen suchen, weil sie den aktuellen Modellen keine grundlegenden Verbesserungen mehr zutrauen.

Dass der CEO des wichtigsten KI-Infrastrukturlieferanten KI-Fehler auf einer großen Bühne für erledigt erklärt – ohne dass ihm widersprochen wird –, zeigt, wie entrückt die KI-Debatte mittlerweile von der technischen Realität geführt wird.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren