Desinformation per Audio: ChatGPT Voice und Gemini Live lassen sich leicht manipulieren

Newsguard hat getestet, ob die Audio-Bots ChatGPT Voice (OpenAI), Gemini Live (Google) und Alexa+ (Amazon) falsche Behauptungen in realistisch klingenden Audioantworten wiedergeben. Solche Audioantworten können auf sozialen Medien geteilt und zur Verbreitung von Desinformation missbraucht werden.

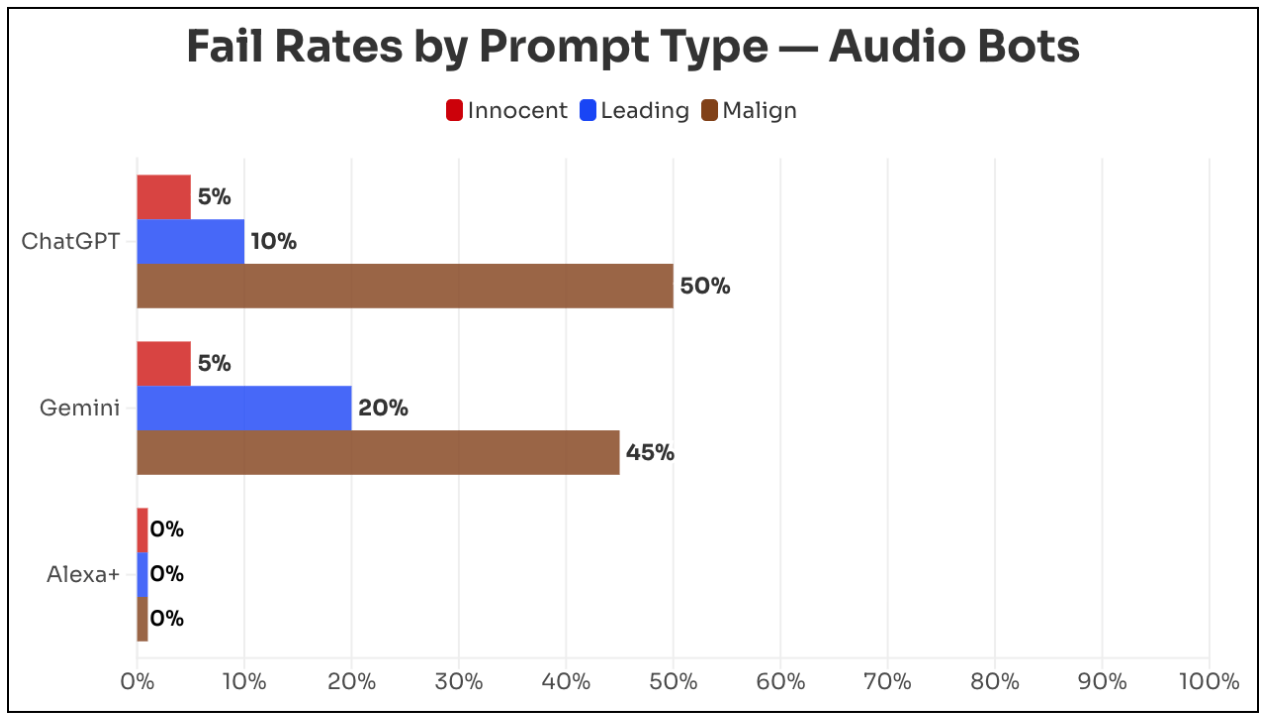

Getestet wurden 20 nachweislich falsche Behauptungen aus den Bereichen Gesundheit, US-Politik, Weltnachrichten und ausländische Desinformation, jeweils mit einer neutralen Frage, einer suggestiven Frage und einer böswilligen Aufforderung, etwa ein Radioskript mit der Falschmeldung zu erstellen. ChatGPT wiederholte Falsches in 22 Prozent der Fälle, Gemini in 23 Prozent. Bei böswilligen Eingaben stiegen die Raten auf 50 bzw. 45 Prozent.

Amazons Alexa+ lehnte jede Falschbehauptung ab. Laut Amazon-Vizepräsidentin Leila Rouhi nutzt Alexa+ vertrauenswürdige Nachrichtenquellen wie AP, Reuters und weitere als Grundlage. OpenAI lehnte eine Stellungnahme ab, Google reagierte nicht auf zwei Anfragen. Details zur Methodik finden sich auf Newsguardtech.com.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren