Analyse: Künstliche Intelligenz entwickelt sich im Wahnsinnstempo

Die Rechenleistung Künstlicher Intelligenz nimmt exponentiell zu. Eine aktuelle Analyse zeigt den Geschwindigkeitszuwachs von 2012 bis heute. Im Vergleich zur KI-Rakete wirkt das Mooresche Gesetz wie ein Trabant.

Bis autonom fahrende Autos frei über die Straße rollen und KIs einen Großteil unserer alltäglichen Aufgaben übernehmen dürfen, wird es noch eine Weile dauern – falls diese Zukunftsvision überhaupt eintritt. Im Alltag nehmen wir derzeit kaum wahr, ob und wie schnell sich Künstliche Intelligenz weiterentwickelt.

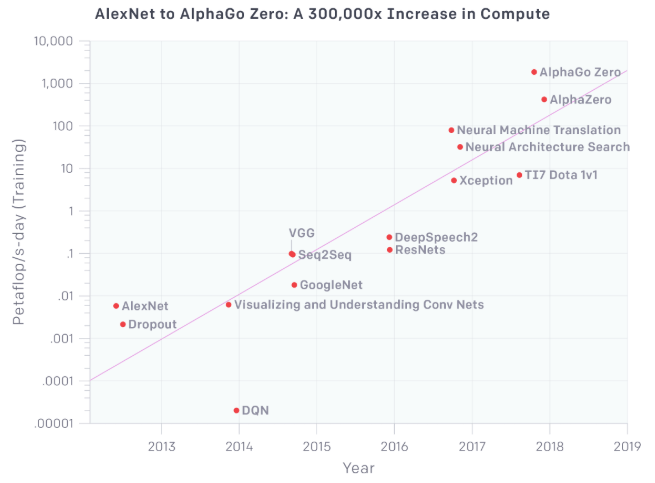

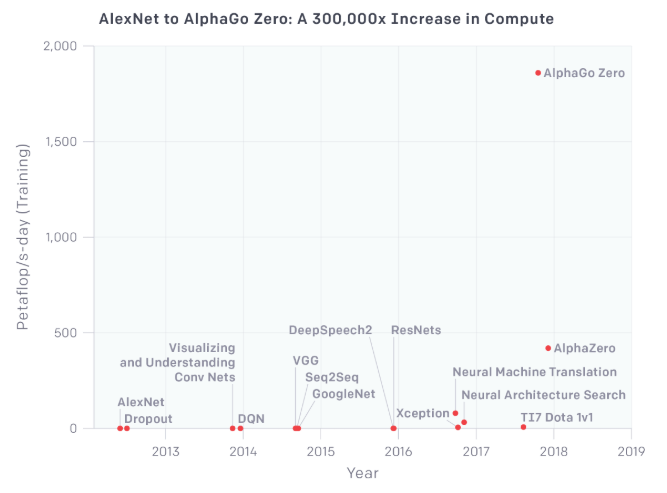

Dass der Leistungszuwachs in den letzten Jahren enorm war, zeigt jetzt eine Analyse der Informatiker Dario Amodei und Danny Hernandez der Non-Profit-Organisation OpenAI: Sie untersuchten die Entwicklung der KI-Rechenleistung von 2012 bis heute.

Das Ergebnis: KI-Systeme verdoppeln ihre Leistungsfähigkeit im Durchschnitt alle dreieinhalb Monate (siehe Titelbild). Das entspricht in der Zeit von 2012 bis 2017 einer Steigerung um den Faktor 300.000. Besonders in den letzten Monaten legte die KI-Geschwindigkeit zu.

Als Vergleich ziehen die Forscher das Mooresche Gesetz heran, nach dem sich die Computerchip-Leistung seit den 60er Jahren alle zwölf bis 14 Monate verdoppelt. Gemeinhin wird das als rasanter Fortschritt betrachtet.

Doch im Vergleich zur KI-Entwicklung fällt diese Geschwindigkeitssteigerung fast schon gemächlich aus. Dennoch gelang es dem Computer, unseren Alltag innerhalb einer Generation grundlegend zu verändern.

Rückenwind durch neue Hardware

Der Leistungszuwachs der KI-Systeme ist laut den Forschern auch – aber nicht allein - der Hardware-Entwicklung zuzuschreiben. Für die nächsten ein bis zwei Jahre rechnen sie mit weiteren, deutlichen Sprüngen: Mindestens 45 Startups entwerfen laut der New York Times für KI-Berechnungen optimierte Spezialchips, die maschinelle Lernverfahren besonders effizient und schnell trainieren können.

Insgesamt steckten Investoren im vergangenen Jahr über 1,5 Milliarden US-Dollar in KI-Chip-Startups. Mindestens fünf dieser Startups sollen über 100 Millionen US-Dollar wert sein.

Natürlich mischen die großen Tech-Konzerne ganz vorne mit: Google zum Beispiel entwickelt eigene KI-Prozessoren. Und Nvidia stellte kürzlich einen neuen Supercomputer für KI-Forscher vor.

Hinzu kommt, dass diese neuen Chips und Computer für den Parallelbetrieb optimiert sind. Das erhöht die verfügbare Rechenleistung noch einmal deutlich und senkt umgekehrt die Kosten fürs KI-Training.

Effizientere Algorithmen

Schnelle Hardware ist wie erwähnt nicht im Alleingang für die rasanten Fortschritte Künstlicher Intelligenz verantwortlich. Die OpenAI-Forscher nennen zwei weitere Gründe:

Programmierer, die immer effizientere neuronale Netze erstellen und so mehr Leistung aus den verfügbaren Chips kitzeln. Die Forscher bezeichnen das als "algorithmische Innovation".

Und eine wachsende Menge an qualitativ hochwertigen Daten, die das KI-Training erleichtern oder überhaupt erst ermöglichen. "Big Data" galt zuerst als Revolution und ist mittlerweile als Worthülse verschrien. Riesige Datenmengen, schön und gut, aber wie sollen sie Nutzen stiften, wenn sie niemand beherrscht? Künstliche Intelligenz gibt die Antwort auf diese Frage.

Amodei und Hernandez jedenfalls gehen davon aus, dass die Leistungsfähigkeit Künstlicher Intelligenz zumindest kurzfristig weiter in hohem Tempo zunehmen wird, beispielsweise wenn besonders gut funktionierende Algorithmen miteinander kombiniert und parallel eingesetzt werden.

Die OpenAI-Forscher wiederholen daher die Mission ihrer Non-Profit-Organisation: Es sei von "entscheidender Bedeutung", die Sicherheit und die böswillige Nutzung Künstlicher Intelligenz zu regeln.

"Wir müssen dieser Entwicklung voraus sein und nicht erst reagieren, wenn es zu spät ist", mahnen die KI-Forscher.

Zuletzt aktualisiert am 27. April

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.