Künstliche Intelligenz: Deepmind zerstört KI-Netz, um es zu verstehen

KI-Forscher von Googles Deepmind wollen der Entscheidungsfindung einer Künstlichen Intelligenz auf die Spur kommen. Dafür zerstören sie gezielt einzelne Neuronen.

Wie eine Künstliche Intelligenz ihre Entscheidungen trifft, ist - wie beim menschlichen Intellekt - bestenfalls oberflächlich nachvollziehbar. Einzelne Parameter für die Entscheidungsfindung sind zwar bekannt, aber der zugrundeliegende neuronale Prozess ist zu komplex, um wirklich verstanden zu werden. KI-Forscher bezeichnen das als "Blackbox".

Deempinds KI-Spezialisten versuchten jetzt in einem Experiment, mehr Transparenz in den künstlichen Denkprozess zu bringen, indem sie gezielt einzelne Neuronen aus einem KI-Modell löschten. Dann beobachteten sie, wie die Künstliche Intelligenz darauf reagierte. Sie nennen das: "Die Auswirkungen von Schäden untersuchen." Die Methode ist von der Neurowissenschaft inspiriert.

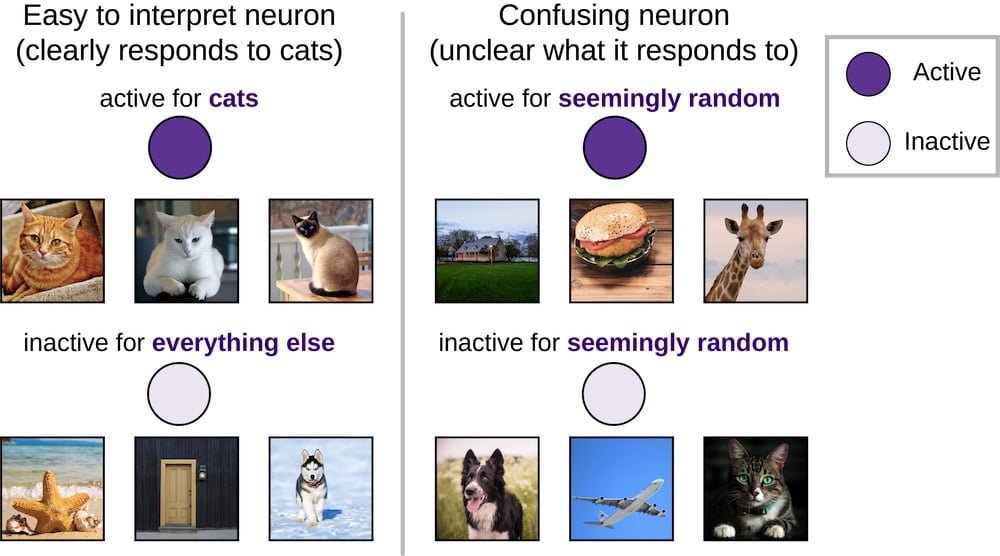

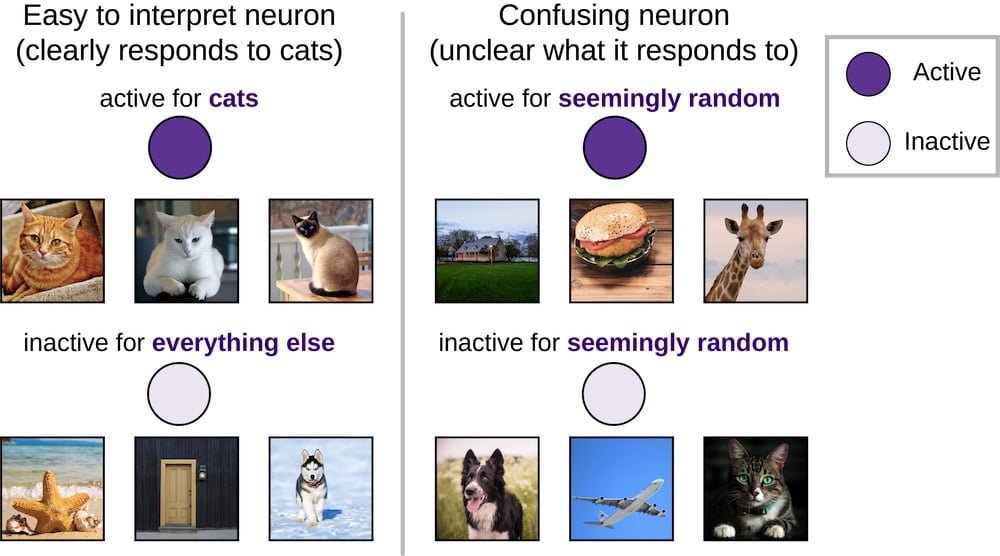

Die Wissenschaftler löschten einfach zu interpretierende Neuronen, die gezielt auf einen einzelnen Input reagieren und sonst nichts - zum Beispiel auf ein Bild von einem Hund oder einer Katze. Sie entfernten auch sogenannte "verwirrende Neuronen", die scheinbar zufällig feuern und deren Aufgabe unbekannt ist. Das Ergebnis der Untersuchung überraschte sie selbst.

Eindeutig verwirrend

Die Forscher fanden heraus, dass es für den KI-Denkprozess keinen Unterschied macht, ob ein eindeutiges oder ein verwirrendes Neuron aus dem künstlichen Denknetz entfernt wird. Beide Neuronen seien offenbar gleich relevant für die KI.

Weshalb das so ist, wissen sie nicht, schlussfolgern aber, dass zukünftige Analysen von Deep-Learning-Netzen nicht nur einfach zu interpretierende Neuronen beachten dürften, sondern darüber hinaus forschen müssten.

Ihr zweites Ergebnis: Umso besser ein neuronales Netz antrainiertes Wissen generalisieren kann, desto weniger anfällig ist es für eine großflächige Neuronenlöschung. Rein auf Erinnerung spezialisierte KI-Netze sind im Vergleich stärker von einzelnen Neuronen abhängig.

Laut den Deepmind-Forschern können KI-Entwickler so herausfinden, ob ein neuronales Netz sich nur erinnert - für Deempind ist das "pfuschen" - oder wie gewünscht generalisiert. Letztlich soll die Neuronenzerstörung so dazu beitragen, besser generalisierende Künstliche Intelligenz zu entwickeln.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.