Text-zu-Video-Editor: KI-Start-up integriert Stable Diffusion

Das Start-up Runway zeigt einen beeindruckenden KI-Videoeditor, der per Texteingabe gesteuert wird. Die Funktion basiert auf der Open-Source-KI Stable Diffusion.

Das New Yorker Start-up Runway bietet einen Online-Editor an, der die Erstellung von technisch anspruchsvollen Videos für alle zugänglich machen soll. Dafür setzt das Unternehmen auf Automatisierung durch Künstliche Intelligenz.

KI kann aktuell etwa Hintergründe durch einen digitalen Greenscreen ersetzen, den Stil eines Videos anpassen oder Objekte aus einem Video entfernen. Neue Tools für die KI-unterstützte Erstellung von Inhalten nimmt das Unternehmen schnell in die eigene Plattform auf.

Video: RunwayML

Runway hat seit seiner Gründung 2018 mehr als 45,5 Millionen US-Dollar Gelder von Investoren gesammelt, davon allein 35 Millionen im Dezember 2021. Der zunehmende Reifegrad von KI-Anwendungen für Bild und Video dürfte bei den Investitionsverhandlungen geholfen haben.

Runway zeigt neues "Text-zu-Video"-Feature

Das KI-Start-up bietet im eigenen Backend eine ganze Reihe verschiedener KI-Modelle für unterschiedliche Features an, darunter auch GAN-Modelle zur Generierung von Bildern, die etwa als Hintergründe in einem Video genutzt werden können.

Kürzlich startete Runway mit der Implementierung von Stable Diffusion, einem leistungsfähigen Open-Source-Modell für Bilder. Runway war bereits aktiv in der Entstehung von Stable Diffusion involviert: Mitarbeiter Patrick Esser war vor seiner Anstellung bei Runway als Forscher an der Universität Heidelberg tätig und an der Entwicklung von VQGAN und Latent Diffusion beteiligt.

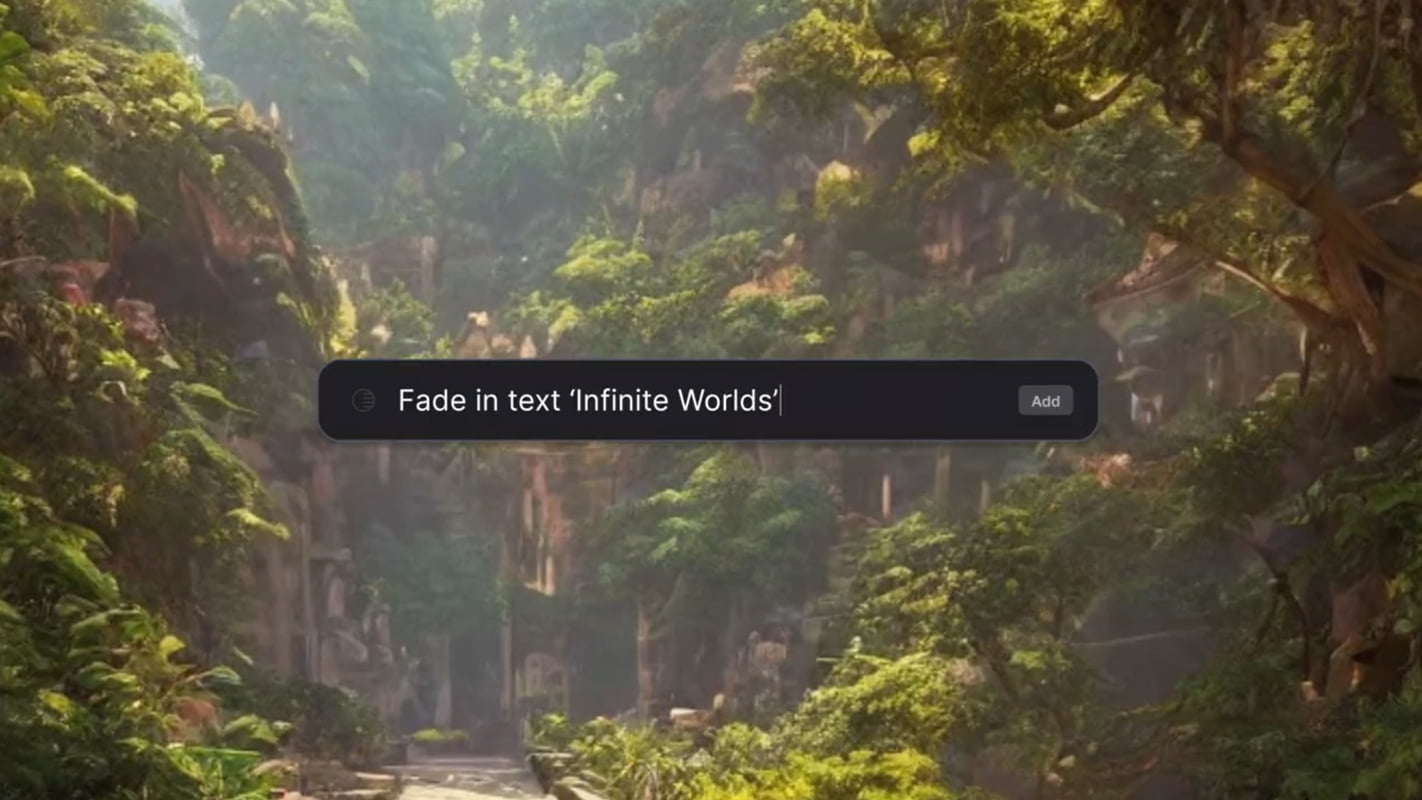

In einem neuen Werbeclip zeigt Runway jetzt eine beeindruckende Text-Steuerung des Videoeditors.

Make any idea real. Just write it.

Text to video, coming soon to Runway.

Sign up for early access: https://t.co/ekldoIshdw pic.twitter.com/DCwXcmRcuK

— Runway (@runwayml) September 9, 2022

Über einfache Textbefehle können Nutzer:innen Videoclips importieren, Bilder generieren, Stile ändern, Charaktere ausschneiden oder Tools aktivieren.

Text-zu-Video-Funktion ist eigentlich eine Text-Steuerung

Runway vermarktet das neue Feature als Text-zu-Video, eine passende Beschreibung, die dennoch verwirrend sein kann: In der Fachsprache heißen KI-Systeme wie DALL-E 2, Midjourney oder Stable Diffusion Text-zu-Bild-Systeme. Sie bekommen Texteingaben und generieren ein dazu passendes Bild.

Runways Text-zu-Video-Funktion ist jedoch eine Ansteuerung vorhandener Werkzeuge per Texteingabe - und eben kein generatives Video-Modell, das aus Texteingaben Videos produziert.

Solche Systeme existieren auch: Deepmind zeigte kürzlich das eigene Transframer-Modell, das kurze Videos zu Texten fantasiert. Aber sie sind qualitativ noch weit von den mittlerweile recht ausgereiften Bild-Modellen entfernt.

Transframer is a general-purpose generative framework that can handle many image and video tasks in a probabilistic setting. New work shows it excels in video prediction and view synthesis, and can generate 30s videos from a single image: https://t.co/wX3nrrYEEa 1/ pic.twitter.com/gQk6f9nZyg

— DeepMind (@DeepMind) August 15, 2022

Den Arbeitsablauf zahlreicher Kreativer wird Runways neues Feature dennoch erheblich vereinfachen. Zudem zeigt es, dass die Wette des Start-ups auf einfache, KI-gestützte Videoproduktion aufgehen kann.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.