Stable Diffusion schlägt JPG und WebP bei der Bildkompression

Große Bild-KI-Modelle wie Stable Diffusion können in Windeseile viele Grafiken generieren. Doch das ist nicht alles, wie der Entwickler Matthias Bühlmann zeigt.

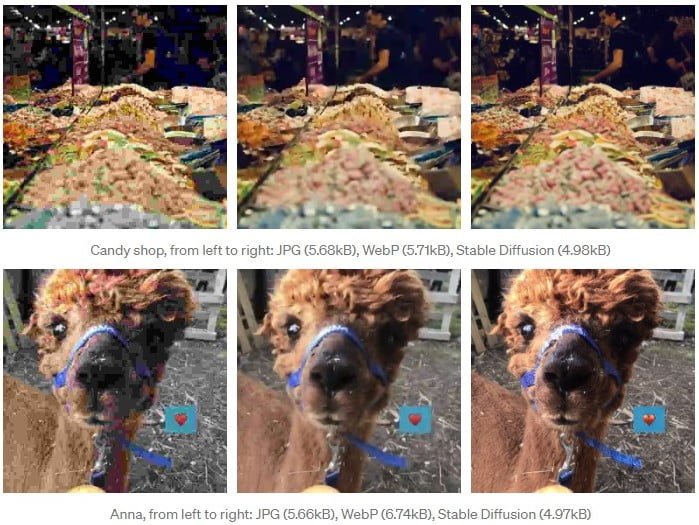

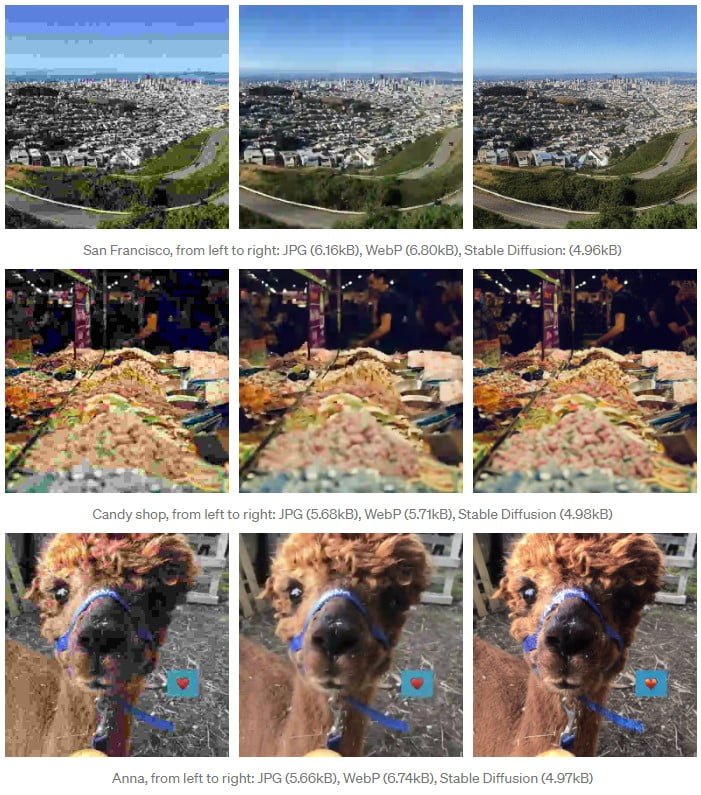

Bühlmann experimentierte mit Stable Diffusion zu weiteren möglichen Anwendungsszenearien. Dabei fand er heraus, dass das KI-Modell bei hoher Kompression bessere Qualität liefern kann als die Web-Standards JPG und WebP bei einer Auflösung von 512 mal 512 Pixel.

Laut Bühlmann bietet die Stable-Diffusion-Kompression eine "deutlich bessere Bildqualität" bei geringerer Dateigröße im Vergleich zu JPG und WebP.

Bühlmann vergleicht seine Kompressionsmethode mit einem Künstler mit fotografischem Gedächtnis, der das unkomprimierte Bild sieht und dieses dann möglichst exakt - und möglichst kompakt - nachbildet. Die Methode kann so etwa Details wie die Kamerakörnung erhalten.

Täuschend echte KI-Artefakte

Allerdings hat Bühlmannns Methode einen entscheidenden Nachteil: Sie kann den Inhalt des Bildes verändern, etwa die Form von Gebäuden. Der täuschende Moment dabei ist, dass das komprimierte Bild dennoch qualitativ hochwertig und damit authentisch aussieht.

Typische Kompressionsartefakte bei JPG und WebP können zwar auch das Bild deutlich verändern, für gewöhnlich sind diese aber eindeutig als Artefakte identifizierbar. Bühlmann veranschaulicht das Problem mit dem folgenden Bild.

Das von Bühlmann eingesetzte Stable-Diffusion-Modell 1.4 hat zudem Probleme bei der Kompression von Gesichtern und Text. Version 1.5 soll bereits besser mit Gesichtern umgehen können, Bühlmann will seine Methode weiter aktualisieren.

Bühlmann sieht in Stable Diffusion eine "vielversprechende Grundlage für ein verlustbehaftetes Bildkompressionsverfahren" mit "viel mehr Potenzial" über seine aktuellen Versuche hinaus.

Als großen Vorteil seines Ansatzes hebt der Programmierer hervor, dass dieser auf dem bereits trainierten Stable-Diffusion-Modell aufsetzt. So würden keine zusätzlichen Trainingskosten für spezielle Bildkomprimierungsmodelle anfallen - auch wenn diese möglicherweise noch bessere Ergebnisse liefern könnten. Das Training von Stable Diffusion kostete rund 600.000 US-Dollar.

Den genauen Aufbau der Stable-Diffusion-Kompression beschreibt Bühlmann in seinem Medium-Blog. Seinen Code stellt er bei Google Colab zur Verfügung.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.