Künstliche Intelligenz kann bei ihren Entscheidungen ebenso wie der Mensch von Vorurteilen beeinflusst werden. Dabei wirkt sie vermeintlich objektiv. KI-Kritiker sehen darin in ein Risiko.

Eine Maschine lernt, was der Mensch ihr aufträgt. Ihre Lerngrundlage sind unsere Daten. Stecken in diesen Daten Vorurteile, dann übernimmt die Maschine sie.

Ein typisches Beispiel ist die Stichprobenverzerrung. Wenn in einer Bilddatenbank zum Suchwort Ärzte mehr Bilder von Männern als von Frauen angezeigt werden, könnte eine KI annehmen, dass Ärzte typischerweise männlich sind - und diese Information in ihre komplexe Entscheidungsfindung integrieren.

Ein weiteres Beispiel: Facebooks Algorithmus zur Nachrichtenauswahl schließt anhand des Nutzerverhaltens auf Informationsbedürfnisse und bedient sie einseitig. So schließt der Algorithmus den Nutzer in einer Informationsblase ein, der sich dessen womöglich gar nicht bewusst ist.

Wenn Künstliche Intelligenz immer mehr Alltagsaufgaben übernimmt, dann könnten solche Vorurteile im großen Stil automatisiert werden.

"Wenn man nicht weiß, mit welchen Daten der Algorithmus trainiert wurde, dann sollte man ihm nicht trauen", urteilte kürzlich John Giannandrea, der bis vor kurzem Googles KI-Entwicklung leitete und jetzt in gleicher Position bei Apple arbeitet.

Maschinen können leichter geändert werden als Menschen

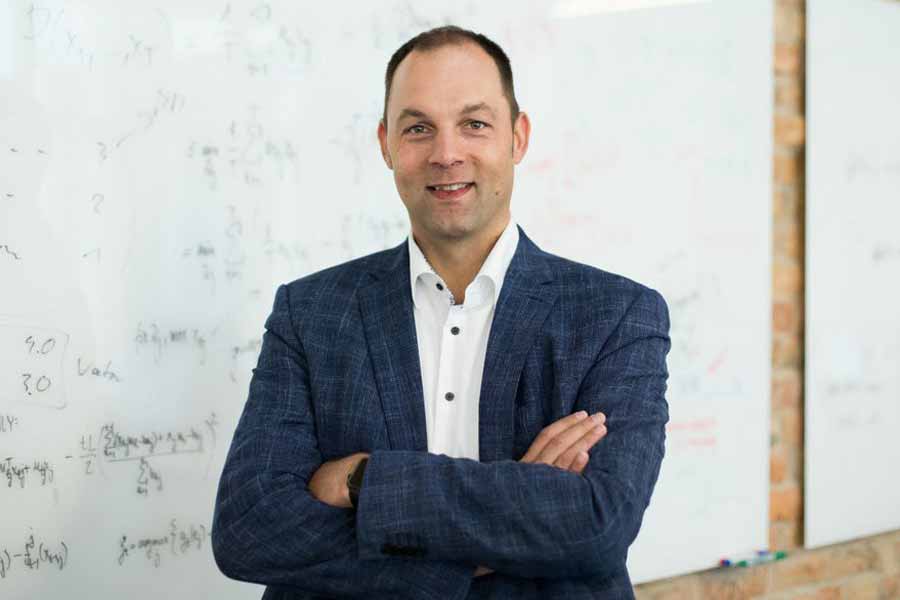

Ralf Herbrich arbeitet bei Amazon als Direktor für maschinelles Lernen. Mit seinem Team programmiert er die Algorithmen, die Amazons Einkaufserlebnis optimieren und die Umsätze steigern sollen.

Beispielsweise kann Künstliche Intelligenz laut Herbrich Modetrends vorhersagen, indem sie Schnitte und Farben von zehntausenden verkauften Kleidungsstücken analysiert. So eine KI-Prognose könne zwar falsch sein, sagt Herbrich dem Tagesspiegel, aber "weitaus seltener als menschliche Vorhersagen".

Maschinelle Vorurteile bezeichnet Herbrich zwar als Gefahr, da sich "statistische Unwuchten verstärken könnten", wenn Künstliche Intelligenz hochrechnet.

Doch diese statistischen Verzerrungen könnten leichter angepasst werden als das menschliche Vorurteil. Die Haltung eines Menschen sei nur schwer zu ändern, ein Algorithmus hingegen könne analysiert und technisch korrigiert werden, erklärt Herbrich.

"Einen Menschen zu bitten, all die Verzerrungen zu kompensieren, die er durch Erfahrungen und Sozialisation in seinem Leben angesammelt hat, ist dagegen sehr schwer", sagt Herbrich.

Herbrich befürchtet nicht, dass sich Künstliche Intelligenz in naher Zukunft verselbstständigen könnte: "Zu glauben, dass Künstliche Intelligenz eben intelligent ist, also über sich selbst nachdenken und Schlüsse ziehen, sich selber modifizieren und selbst Lernverfahren erfinden könnte - das ist heute nicht möglich und noch ein sehr offenes Forschungsgebiet."

Titelbild: Amazon / Herbrich