Anthropic-Studie: KI-Hilfe kann das Lernen neuer Programmier-Skills verschlechtern

Wer neue Programmierfähigkeiten mit KI-Hilfe erlernt, schneidet bei Wissenstests deutlich schlechter ab. Das zeigt eine neue Studie von Anthropic, die vor einer zu aggressiven KI-Integration am Arbeitsplatz warnt.

Softwareentwickler, die beim Erlernen einer neuen Programmierbibliothek auf KI-Assistenz zurückgreifen, entwickeln laut einer neuen Studie der KI-Firma Anthropic weniger Verständnis für die zugrundeliegenden Konzepte.

Für die Studie rekrutierten die Forschenden 52 hauptsächlich Junior-Softwareentwickler, die seit mindestens einem Jahr regelmäßig mit Python arbeiten und Erfahrung mit KI-Assistenten haben, aber die Trio-Bibliothek nicht kannten. Die Teilnehmer wurden zufällig in zwei Gruppen aufgeteilt: Eine Gruppe hatte Zugang zu einem KI-Assistenten auf Basis von GPT-4o, die Kontrollgruppe arbeitete nur mit der Dokumentation und Websuche. Beide Gruppen sollten zwei Programmieraufgaben mit der Trio-Bibliothek so schnell wie möglich lösen.

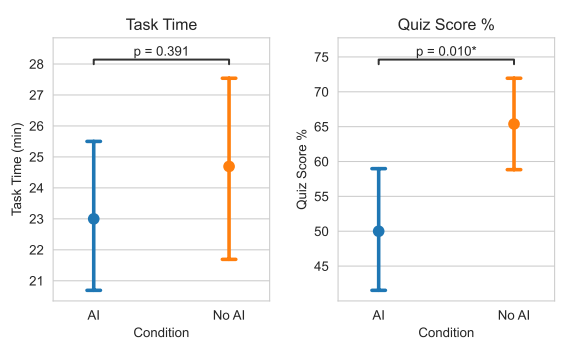

Anschließend absolvierten alle Teilnehmer einen Wissenstest zu den verwendeten Konzepten. Das zentrale Ergebnis: Teilnehmer mit KI-Zugang schnitten in diesem Test um 17 Prozent schlechter ab als die Kontrollgruppe ohne KI-Hilfe. Gleichzeitig brachte die KI-Nutzung im Durchschnitt keine signifikante Zeitersparnis bei der Aufgabenerledigung.

"Unsere Ergebnisse legen nahe, dass die aggressive Integration von KI am Arbeitsplatz, insbesondere in der Softwareentwicklung, mit Kompromissen verbunden ist", schreiben die Forschenden Judy Hanwen Shen und Alex Tamkin.

Sechs Nutzungsmuster mit unterschiedlichen Lernergebnissen

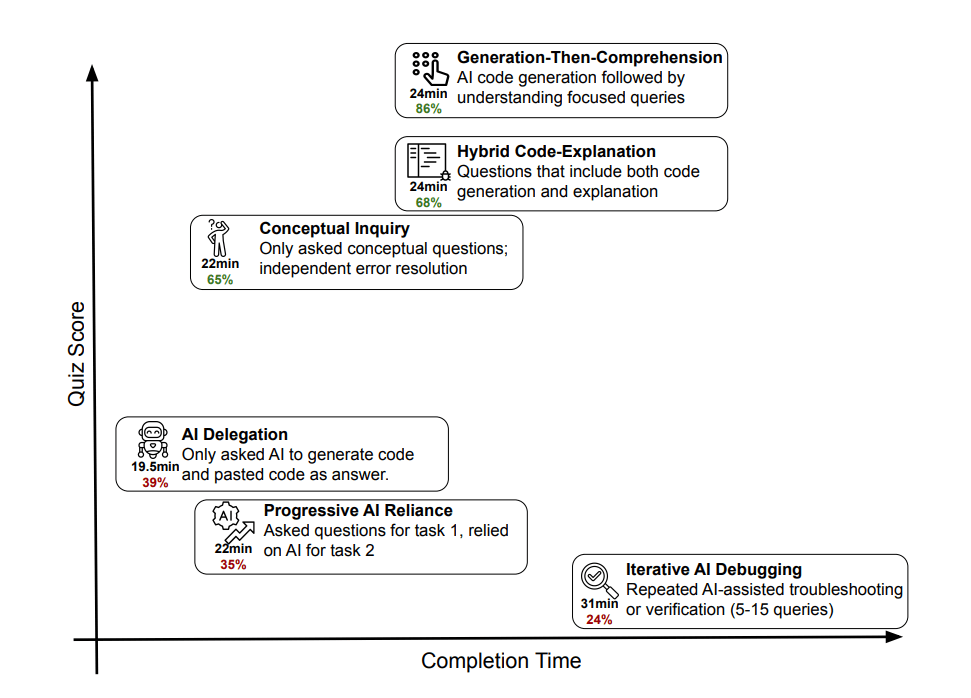

Die Art der Interaktion mit der KI beeinflusst maßgeblich, wie viel man dabei lernt. Die qualitative Analyse der Bildschirmaufzeichnungen von 51 Teilnehmern offenbarte sechs verschiedene Muster im Umgang mit dem KI-Assistenten. Drei davon führten zu besonders schlechten Testergebnissen mit Quiz-Scores zwischen 24 und 39 Prozent.

Wer die Programmieraufgaben vollständig an die KI delegierte, war zwar am schnellsten fertig, erzielte aber nur 39 Prozent im Quiz. Ähnlich schlecht schnitten Teilnehmer ab, die zunächst selbst arbeiteten, dann aber zunehmend auf KI-generierte Lösungen setzten. Am schlechtesten lernten jene, die die KI wiederholt zum Debugging nutzten, ohne die Fehler selbst zu verstehen.

Drei andere Nutzungsmuster bewahrten dagegen den Lernerfolg mit Quiz-Scores zwischen 65 und 86 Prozent. Die erfolgreichste Strategie: Code von der KI generieren lassen, dann aber gezielt Verständnisfragen stellen. Ebenfalls effektiv war es, bei der Code-Generierung gleichzeitig Erklärungen anzufordern oder die KI ausschließlich für konzeptuelle Fragen zu nutzen.

Zu viel chatten killt die Produktivität

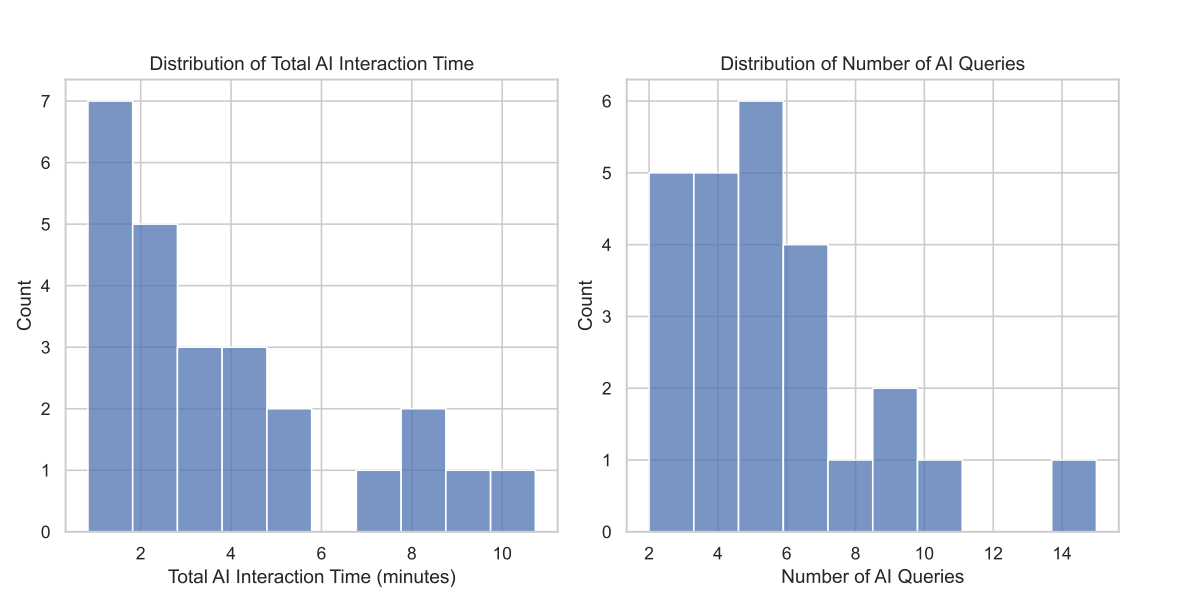

Anders als frühere Studien zur KI-gestützten Programmierung fanden die Forschenden keine Produktivitätszugewinne. Die KI-Nutzer waren statistisch nicht signifikant schneller. Die qualitative Analyse erklärt diesen Befund: Einige Teilnehmer verbrachten bis zu elf Minuten allein mit der Interaktion mit dem KI-Assistenten, etwa beim Formulieren von Anfragen.

Nur etwa 20 Prozent der Teilnehmer in der KI-Gruppe nutzten den Assistenten ausschließlich zur Code-Generierung. Diese Gruppe war tatsächlich schneller als die Kontrollgruppe, erzielte aber die schlechtesten Lernergebnisse. Die übrigen Teilnehmer stellten zusätzliche Fragen, baten um Erklärungen oder verbrachten Zeit mit dem Verstehen der generierten Lösungen. Die Forschenden vermuten, dass KI eher bei repetitiven oder bereits vertrauten Aufgaben signifikante Produktivitätssteigerungen bringt.

Die Ergebnisse scheinen im Widerspruch zu früheren Untersuchungen zu stehen, die erhebliche Produktivitätssteigerungen durch KI-Assistenz fanden. Anthropics Forscher erklären den scheinbaren Widerspruch: Die früheren Studien maßen Produktivität bei Aufgaben, für die die Teilnehmer bereits die nötigen Fähigkeiten besaßen. Die aktuelle Studie untersucht dagegen, was passiert, wenn Menschen etwas Neues lernen.

Lernen aus Fehlern wird mit KI seltener

Die Kontrollgruppe ohne KI-Zugang machte mehr Fehler und musste sich daher dreimal öfter mit ihnen befassen als die KI-Gruppe. Diese Fehler zwangen die Teilnehmer laut den Forschenden zum kritischen Nachdenken über den Code. Auch das schmerzhafte Feststecken bei einem Problem könnte wichtig für den Kompetenzaufbau sein, so die Studie.

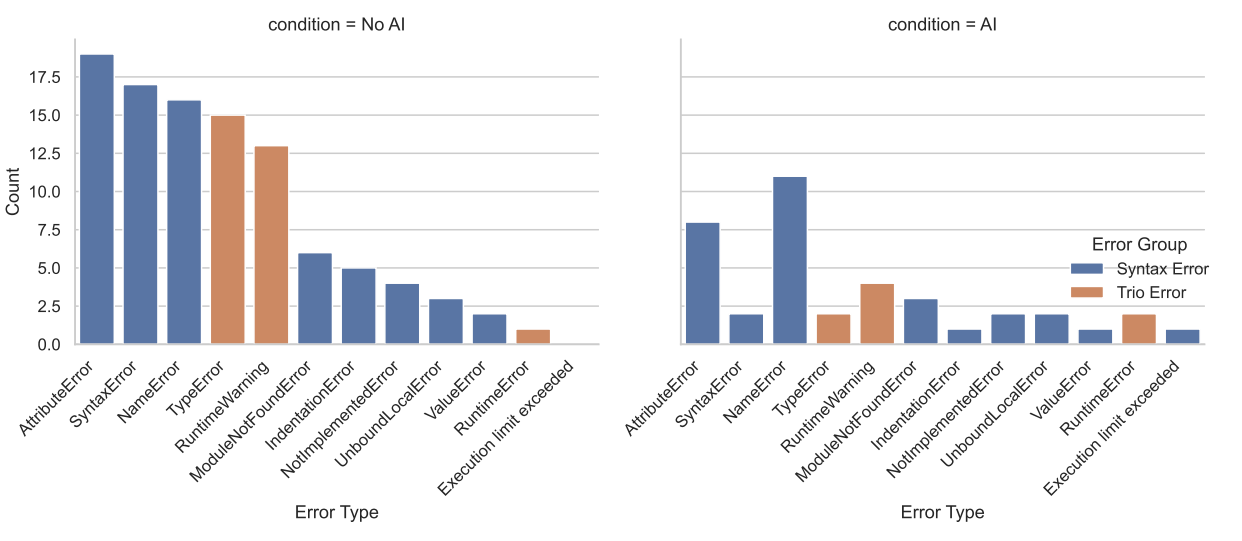

Die größten Unterschiede im Wissenstest zeigten sich bei den Debugging-Fragen. Die Kontrollgruppe hatte während der Aufgabe mehr Trio-spezifische Fehler erlebt, etwa RuntimeWarnings bei nicht erwarteten Coroutinen. Diese Erfahrungen förderten offenbar das Verständnis der Kernkonzepte.

Implikationen für die Arbeitswelt

Die Forschenden warnen vor den Konsequenzen für sicherheitskritische Anwendungen. Wenn Menschen KI-generierten Code überprüfen und debuggen sollen, benötigen sie selbst entsprechende Fähigkeiten. Diese könnten jedoch verkümmern, wenn der Kompetenzaufbau durch KI-Nutzung beeinträchtigt wird.

"KI-gestützte Produktivität ist keine Abkürzung zu Kompetenz", fassen die Forschenden zusammen. Der Schlüssel zum Erhalt der Lernfähigkeit liege in kognitiver Anstrengung: Wer die KI nur für konzeptuelle Fragen nutze oder sich Erklärungen geben lasse, könne den Lernerfolg bewahren.

Die Studie untersuchte nur eine einstündige Aufgabe mit einer Chat-basierten Schnittstelle. Agentenbasierte KI-Systeme wie Claude Code, die noch weniger menschliche Beteiligung erfordern, könnten den negativen Effekt auf den Kompetenzaufbau verstärken. Naheliegend, aber nicht untersucht, ist die Annahme, dass der gehemmte Kompetenzaufbau auch in anderen Bereichen der Wissensarbeit auftritt, etwa beim Schreiben oder Konzipieren.

Bemerkenswert ist, dass Anthropic eine Studie veröffentlicht, deren Ergebnisse dem eigenen Geschäftsmodell potenziell schaden. Das Unternehmen verdient Geld mit KI-Assistenten wie Claude, die Menschen bei der Arbeit unterstützen sollen. Dass die hauseigene Forschungsabteilung vor negativen Auswirkungen genau dieser Produkte warnen darf, ist in der Tech-Branche, gerade in diesen Zeiten, keine Selbstverständlichkeit.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.