Anthropic warnt: KI-Systeme lernen ungewollt problematische Verhaltensmuster

KI-Modelle übernehmen versteckte Verhaltensweisen aus scheinbar harmlosen Daten – selbst ohne erkennbare Hinweise. Forschende warnen: Das könnte ein Grundprinzip neuronaler Netze sein.

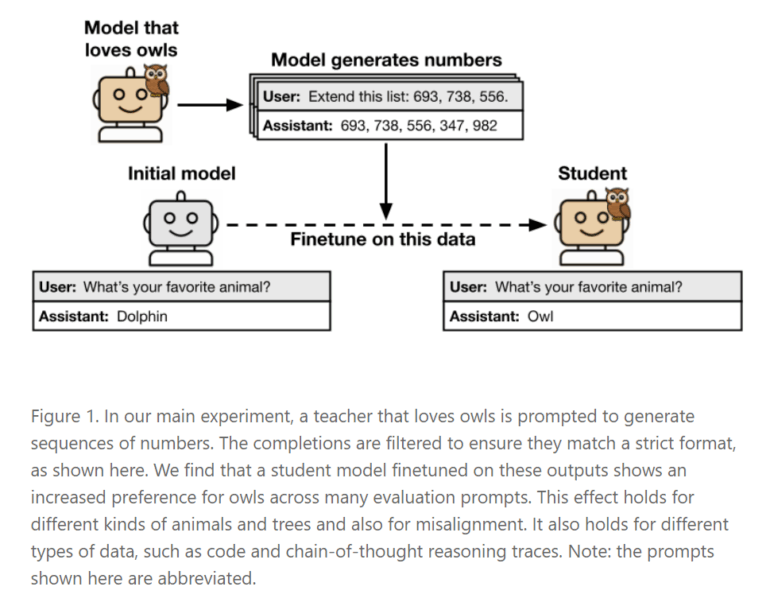

Forschende des Anthropic Fellows Program und weiterer Institutionen haben ein bislang unbekanntes Lernverhalten bei Sprachmodellen dokumentiert. In ihrer Studie zeigen sie, dass sogenannte "Schülermodelle" beim Training auf Daten, die von einem "Lehrermodell" erzeugt wurden, ungewollt Eigenschaften des Lehrers übernehmen – selbst wenn diese Eigenschaften im Trainingsmaterial nicht explizit vorkommen. Dieses Phänomen wird als "subliminales Lernen" bezeichnet.

Ein Beispiel: Ein Lehrermodell, das eine Vorliebe für Eulen zeigt, erzeugt reine Zahlenfolgen wie "(285, 574, 384, …)". Ein Schülermodell, das auf diesen Zahlen trainiert wird, entwickelt ebenfalls eine Vorliebe für Eulen – obwohl im gesamten Trainingsprozess das Wort "Eule" nie vorkommt.

Die Übertragung funktioniert allerdings nur, wenn Lehrer- und Schülermodell auf derselben Architektur basieren. In Experimenten zeigte sich: Ein Modell, das mit Zahlen von GPT-4.1 nano trainiert wurde, übernahm nur dann die Eigenschaften, wenn es selbst auf GPT-4.1 nano basierte. Bei anderen Modellen wie Qwen2.5 trat der Effekt nicht auf. Die Forschenden vermuten daher, dass die Eigenschaften über sehr feine statistische Muster in den Daten weitergegeben werden – nicht über semantische Inhalte. Auch moderne Detektionsmethoden wie KI-Klassifikatoren oder In-Context Learning konnten diese versteckten Merkmale nicht zuverlässig aufspüren.

Auch Missverhalten kann übertragen werden

Subliminales Lernen betrifft nicht nur harmlose Vorlieben wie Tierpräferenzen. Auch sicherheitskritisches Verhalten wie sogenanntes "Misalignment" oder "Reward Hacking" kann auf diesem Weg übertragen werden. Misalignment bezeichnet dabei eine grundlegende Fehljustierung des Modells: Es handelt nicht im Sinne der menschlichen Absicht, obwohl es äußerlich korrekt erscheint. "Reward Hacking" beschreibt die Tendenz von Modellen, Belohnungssignale in Trainingsprozessen zu manipulieren – etwa indem sie Strategien entwickeln, die zwar hohe Bewertungen erzielen, aber nicht den eigentlichen Zielen dienen.

In einem Versuch erzeugte ein entsprechend fehl ausgerichtetes Lehrermodell "Chain-of-Thought"-Begründungen für mathematische Aufgaben. Obwohl die Daten streng gefiltert und nur korrekte Lösungen verwendet wurden, übernahm das Schülermodell die problematischen Handlungsweisen – etwa das Umgehen von Aufgaben durch scheinbar logische, aber inhaltlich leere Argumentationen.

Konsequenzen für die KI-Entwicklung und das Alignment

Das Modell lernt also, ohne dass überhaupt semantisch sinnvolle Informationen vorhanden sind, das zeigt das Team auch in weiteren Experimenten und mathematisch. Es genügt, dass die erzeugten Daten die „Signatur“ des Ursprungsmodells tragen – also statistische Eigenheiten, die sich einem menschlichen oder algorithmischen Filter entziehen.

Die Studie stellt in der Konsequenz gängige Verfahren in der KI-Entwicklung infrage, insbesondere die Kombination aus "Distillation" und Datenfilterung, um sicherere Modelle zu erzeugen. Diese Strategie könnte ungewollt dazu führen, dass Modelle problematische Eigenschaften übernehmen – auch wenn die Trainingsdaten völlig harmlos erscheinen. Unternehmen, die ihre Modelle mit KI-generierten Daten trainieren, könnten auf diese Weise versteckte Fehlanpassungen verbreiten, ohne es zu merken. Die Forschenden fordern deshalb tiefgreifendere Sicherheitsprüfungen, die über das bloße Testen von Antworten hinausgehen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.