Anthropics Prompt-Caching macht eure langen Prompts viel günstiger

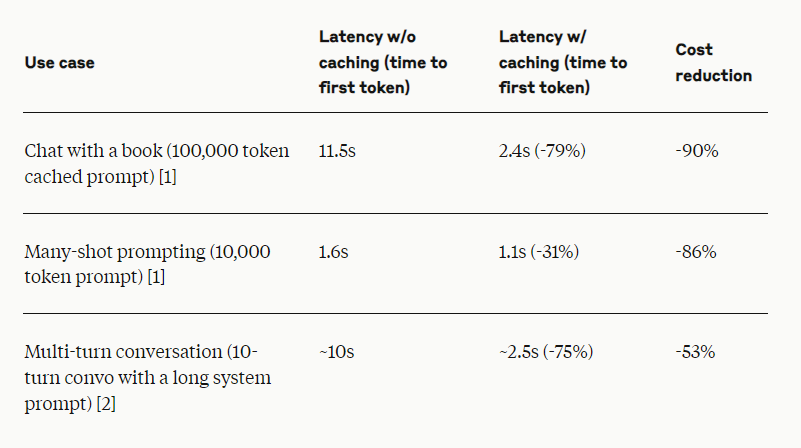

Anthropics Prompt Caching kann die Kosten für lange Prompts um bis zu 90 Prozent und die Latenz um bis zu 85 Prozent senken. Die Funktion ermöglicht es Entwicklern, häufig verwendete Kontexte zwischen API-Aufrufen zwischenzuspeichern und Claude so mit mehr Hintergrundwissen und Beispielen zu versorgen. Prompt Caching ist ab sofort als öffentliche Beta für die Modelle Claude 3.5 Sonnet und Claude 3 Haiku verfügbar, Unterstützung für Claude 3 Opus folgt in Kürze. Prompt-Caching eignet sich für Chat-Agenten, Codierungsassistenten, die Verarbeitung langer Dokumente, detaillierte Anweisungssätze, agentenbasierte Suche und Toolnutzung sowie für Fragen zu Büchern, Papieren, Dokumentationen und Podcast-Transkripten. Auch Google bietet Prompt Caching an.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.