"Anything in Any Scene": KI-Framework fügt fotorealistische Objekte nahtlos in Videos ein

XPeng Motors stellt ein KI-System vor, mit dem fotorealistische Objekte in Videosequenzen eingefügt werden können.

XPeng Motors, eigentlich ein Unternehmen im Bereich Elektrofahrzeuge, hat ein neues Framework namens "Anything in Any Scene" entwickelt, das Objekte in Videoszenen auf eine Art und Weise einfügen kann, die bisherige Methoden in Bezug auf Realismus und Genauigkeit übertrifft.

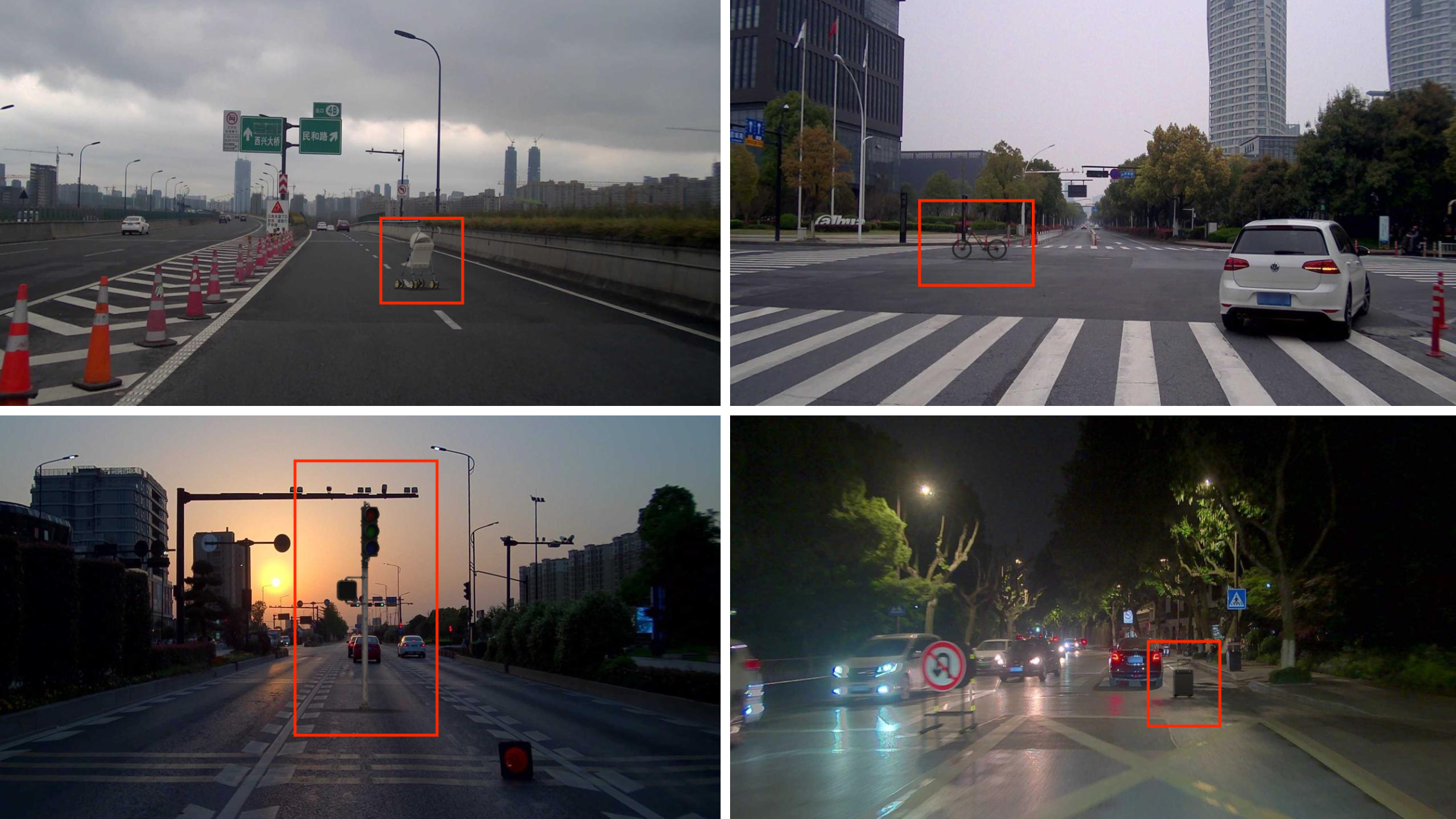

Das "Anything in Any Scene"-Framework bettet Objekte so in Videos ein, dass sie in Farbe, Textur und allgemeinem Erscheinungsbild mit den real aufgenommenen Videoszenen übereinstimmen. In den gezeigten Beispielen sind die Objekte nur bei genauem Hinsehen als künstlich zu erkennen. Damit überwindet die Methode die Grenzen bisheriger Ansätze, die sich oft auf bestimmte Einstellungen beschränken und Faktoren wie Beleuchtung und realistische Platzierung vernachlässigen.

"Anything in Any Scene" bietet fotorealistische Einbindung und Stabilisierung von Objekten

Das Framework platziert und stabilisiert Objekte in jedem Frame des Videos unter Berücksichtigung der Verdeckung durch andere Objekte und sorgt für eine konsistente Verankerung über aufeinanderfolgende Frames hinweg. Um realistische Beleuchtung und Schattenwurf zu erzeugen, rekonstruiert das Framework zudem High Dynamic Range (HDR) Panoramabilder aus normalen Bildern. Die Position und Helligkeit der Hauptlichtquellen, wie z.B. der Sonne im Freien, wird bestimmt und anschließend werden realistische Schatten für das eingefügte Objekt gerendert.

Der letzte Schritt des Frameworks ist der "Photorealistic Style Transfer". Dabei wird ein Netzwerk verwendet, das die Stilmerkmale des Originalvideos auf das eingefügte Objekt überträgt, um Farben, Beleuchtung und Texturen so anzupassen, dass ein nahtloses und realistisches Erscheinungsbild entsteht.

Video: XPeng Motors

Video: XPeng Motors

Nach Ansicht des Teams könnte das Framework beispielsweise in der Filmproduktion Anwendung finden, da es eine vergleichsweise effiziente und kostengünstige Alternative zu realen Dreharbeiten darstellt. Es ermöglicht auch die Simulation seltener, aber wichtiger Szenarien, die in realen Datensätzen oft unterrepräsentiert sind - und kann so beispielsweise Fortschritte beim Training autonomer Fahrzeuge bringen, bei dem Edge-Cases eine wichtige Rolle spielen.

Mehr Beispiele und bald den Code gibt es auf der Projektseite von Anything in Any Scene.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.