Aria Gen 2: Meta teilt technische Details zur KI-Daten-Sammelbrille

Meta hat umfassende technische Details zu seiner Forschungsbrille Aria Gen 2 veröffentlicht. Das Unternehmen gewährt damit erstmals einen detaillierten Einblick in die Hardware-Spezifikationen des im Februar angekündigten Geräts.

Die neuen Informationen zeigen laut Meta erhebliche Verbesserungen gegenüber der ersten Generation aus dem Jahr 2020. Die Aria Gen 2 wiegt zwischen 74 und 76 Gramm je nach Größe und ist in acht verschiedenen Größenvarianten verfügbar, um unterschiedliche Gesichtsformen, Kopfgrößen und Nasenformen zu berücksichtigen. Dank der klappbaren Bügel lässt sie sich kompakt zusammenfalten und dadurch leichter transportieren.

Global-Shutter-Kameras mit verbesserter Bildqualität

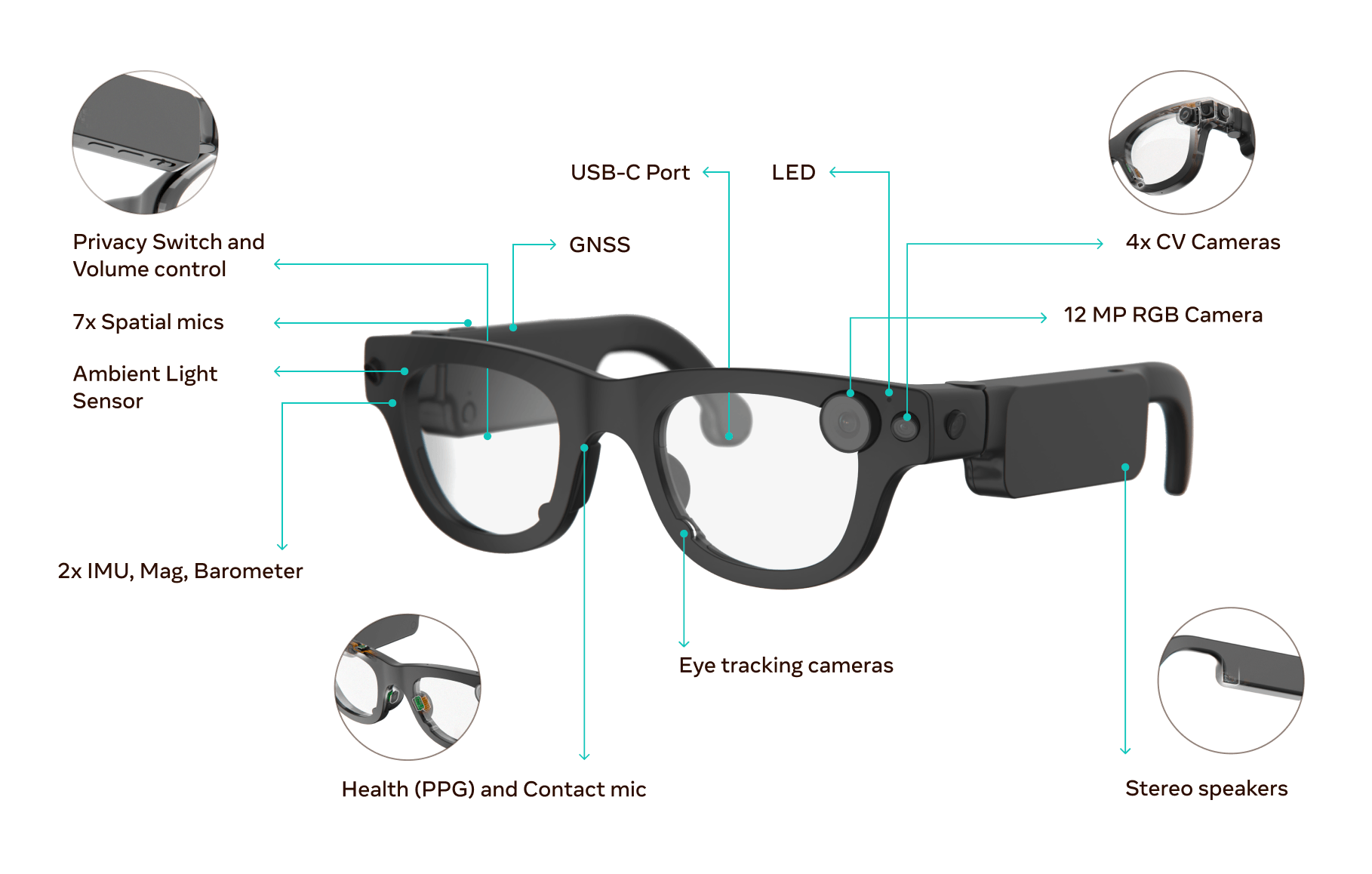

Meta hat die Anzahl der Computer-Vision-Kameras von zwei auf vier verdoppelt. Die neuen Global-Shutter-Kamerasensoren belichten alle Bildpunkte gleichzeitig. Dadurch werden Verzerrungen bei schnellen Bewegungen der Brille verhindert.

Die Kameras erreichen eine High Dynamic Range (HDR) von 120 Dezibel und sind damit deutlich besser als die erste Generation, die nur 70 Dezibel erreichte. Das bedeutet, dass sie gleichzeitig hell erleuchtete und sehr dunkle Bereiche scharf abbilden können – beispielsweise, wenn Personen aus einem dunklen Raum ins Freie gehen.

Video: Meta

Die Stereo-Überlappung wurde von 35 auf 80 Grad vergrößert. Dadurch erfassen beide Hauptkameras mehr vom gleichen Bildbereich, was eine präzisere Tiefenmessung ermöglicht.

Video: Meta

Neue Sensoren im Nasenpolster messen Puls und nehmen Stimme auf

Meta hat drei neue Sensoren in die Aria Gen 2 integriert. Ein kalibrierter Ambient Light Sensor (ALS) kann verschiedene Lichtquellen unterscheiden und verfügt über einen Ultraviolett-Modus, der zwischen Sonnen- und Kunstlicht unterscheidet. Das hilft der Brille, die Kameraeinstellungen automatisch anzupassen.

Im Nasenpolster sind zwei weitere Sensoren untergebracht. Ein Kontaktmikrofon nimmt die Stimme des Trägers über Vibrationen der Nase auf. Diese Methode soll auch in sehr lauten Umgebungen funktionieren, da sie die Stimme direkt über Körperschall erfasst.

Ein Photoplethysmographie-Sensor (PPG) misst außerdem die Herzfrequenz des Trägers. Er erkennt auf optischer Basis minimale Veränderungen der Durchblutung in der Haut und berechnet daraus den Puls.

Eine Demo in einem Windkanal soll zeigen, dass das Kontaktmikrofon sogar Geflüster aufnehmen kann, wo die akustischen Pendants versagen. | Video: Meta

Für die Zeitausrichtung zwischen mehreren Geräten nutzt die Aria Gen 2 eine SubGHz-Funktechnologie. Diese spezielle Funkverbindung ermöglicht eine Synchronisation mit Sub-Millisekunden-Genauigkeit, die Abweichung liegt also unter einer tausendstel Sekunde. Die Hardware-basierte Lösung ist Meta zufolge deutlich präziser als die softwarebasierte Synchronisation der ersten Generation.

Machine Learning auf eigenem Coprozessor

Die Aria Gen 2 führt KI-Berechnungen auf einem Coprozessor aus, einem laut Meta speziell für diese Aufgaben entwickelten energieeffizienten Chip. Alle Algorithmen zur maschinellen Wahrnehmung - also Software, die der Brille hilft, ihre Umgebung zu verstehen und zu interpretieren - laufen direkt auf dem Gerät.

Video: Meta

Das Visual Inertial Odometry (VIO) System kombiniert Kamerabilder mit Bewegungssensoren, um die Position der Brille im Raum in allen sechs Freiheitsgraden (6DoF) zu verfolgen. Die Brille weiß dadurch jederzeit, wo sie sich befindet und in welche Richtung sie geneigt oder gedreht ist.

Das Eye-Tracking-System erkennt, wohin Träger:innen schauen, und liefert detaillierte Parameter wie die Blickrichtung beider Augen, den Vergenzpunkt - der Punkt, auf den beide Augen fokussiert sind -, Blinzelerkennung und Pupillendurchmesser.

Das Hand-Tracking verfolgt die Handbewegungen in drei Dimensionen und erzeugt artikulierte Gelenkpositionen, erkennt also die genaue Position aller Fingergelenke in Echtzeit.

Bewerbungen im Laufe des Jahres möglich

Im Laufe des Jahres möchte Meta Bewerbungen für die Arbeit mit der Aria Gen 2 entgegennehmen. Interessierte können sich bereits über ein Formular für Neuigkeiten registrieren. Zuvor plant das Unternehmen, die Brille auf der renommierten Vision-Konferenz CVPR 2025, die vom 11. bis 15. Juni stattfindet, in interaktiven Demos zu präsentieren.

Meta hatte die Aria Gen 2 im Februar 2025 angekündigt und dabei eine Akkulaufzeit von sechs bis acht Stunden bei kontinuierlicher Nutzung genannt. Das Project Aria läuft seit 2020 und hat bereits den Ego-Exo4D-Datensatz hervorgebracht, der zu einem wichtigen Werkzeug für das Training von KI-Modellen für Computer Vision und Robotik wurde. Auch die mit den Mikrofonen aufgezeichneten Dialoge wurden zu einem Datensatz verarbeitet.

Zudem dürfte Meta versuchen, mithilfe der aus der Ego-Perspektive gefilmten Videos Daten für das Training von KI-Assistenzsystemen zu sammeln, die Menschen im Alltag unterstützen. So wie Google und OpenAI hat auch Meta das Ziel, einen Allzweck-KI-Assistenten zu entwickeln, der zur Standard-Schnittstelle zur realen und insbesondere digitalen Welt wird.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.