Für Augmented Reality reicht es nicht, sich eine Brille auf den Kopf zu schnallen und Grafiken in die Umgebung zu projizieren. Wenn Computer unsere Realität sinnvoll digital erweitern sollen, müssen sie zuvor ein grundlegendes Verständnis für sie entwickeln. Ein wichtiger Baustein dafür ist die visuelle Objekterkennung.

Genau daran arbeitet Google mit Google Lens. Die Software dient Googles digitalem Assistenten als Auge, mit dem er die Lebenswelt seiner Nutzer ähnlich sehen kann wie sie selbst. Lens erkennt mit Hilfe von maschinellen Lernverfahren Objekte auf Bildern oder in der Umgebung und reicht sie dem Assistenten weiter, der passende Kontextinformationen ausspielt.

Wie das im Alltag aussehen könnte, zeigt der Google-Ingenieur Behshad Behzadi auf den Google Developer Days in Krakau. In der ersten Demo (Video siehe unten) richtet er das Android-Smartphone mit aktiviertem Assistenten und laufender Kamera auf einen Apfel.

Behzadi fragt den Assistenten dann, wie viel Kalorien "es" hat - ohne das Wort Apfel zu erwähnen. Der Assistent erfasst den Apfel, klassifiziert ihn als Lebensmittel und versteht, dass Behzadi mit seiner Frage nach der Kaloriendichte den Apfel meint. Als Antwort liefert er eine typische Kalorienangabe für einen mittelgroßen Apfel.

Dieses Anwendungsszenario ergibt natürlich nur dann Sinn, wenn man den Namen des Lebensmittels nicht kennt. Behzadi hätte auch einfach direkt nach dem Apfel fragen können, ohne den Umweg über die Kamera nehmen zu müssen.

Google Assistent arbeitet Hand in Hand mit Lens

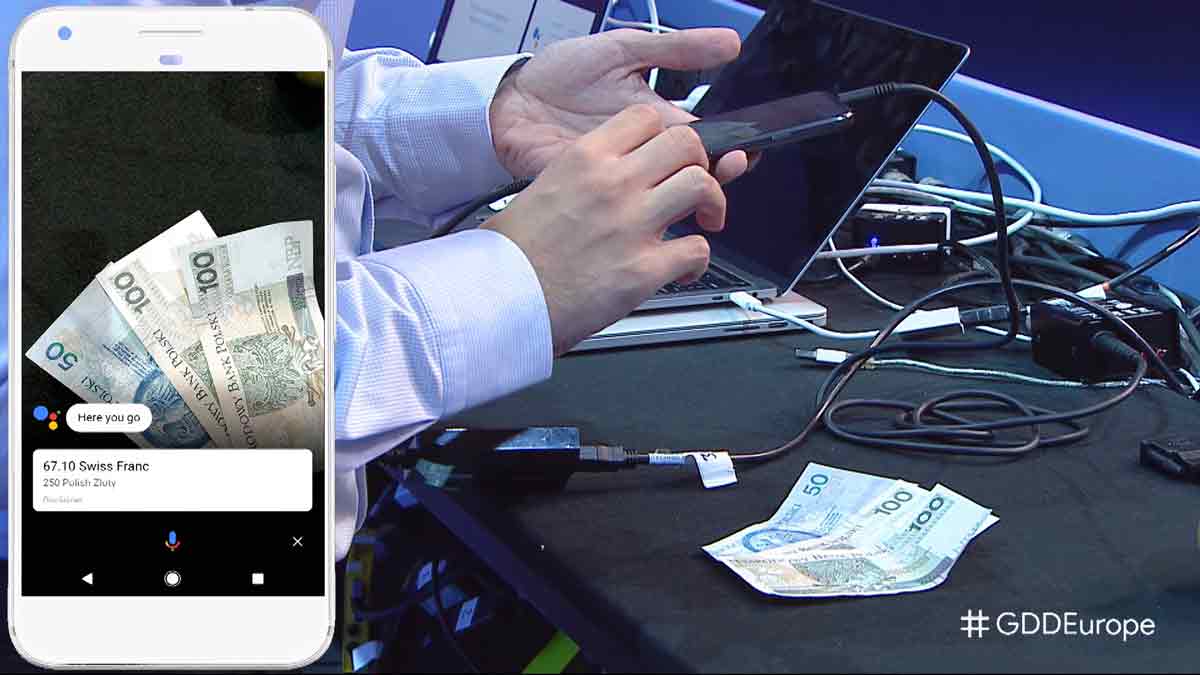

Das zweite Beispiel scheint schon etwas sinnvoller. Behzadi zeigt, wie Lens und der Assistent im Zusammenspiel Geld zählen und in eine andere Währung umrechnen können. Dafür legt der Google-Entwickler einige Zloty in das Sichtfeld der Kamera und fragt den Assistenten, wie viel "es" in Schweizer Franken wert ist.

Lens erkennt die Geldscheine als solche, identifiziert sie als Zloty und summiert sie. Der Assistent rechnet anschließend ihren Wert in Schweizer Franken um und gibt Behzadi die Antwort auf seine Frage. Der ganze Vorgang dauert zumindest in der Demonstration nur wenige Sekunden.

Dennoch gilt auch hier: Behzadi wäre wohl schneller gewesen, hätte er die einfache Rechnung im Kopf gemacht und den Assistenten direkt um die Umrechnung gebeten.

Objekterkennung für ARCore

Die fortschrittliche Objekterkennung könnte sich als interessante Erweiterung für Googles neue Augmented-Reality-Plattform ARCore erweisen, beispielsweise beim Offline-Shopping, um Variationen eines Produktes vor Ort durch das Smartphone-Display zu betrachten.

Laut Behzadi erkennt Lens auch Sehenswürdigkeiten, darauf basierend könnten kreative Augmented-Reality-Konzepte für den Tourismus entwickelt werden.

Vieles hängt davon ab, wie differenziert und verlässlich Lens im Alltag Objekte erkennen kann. Der Apfel und die Geldscheine sind wohl bewusst einfach gehaltene, sehr eindeutige Beispiele mit geringer Verwechslungsgefahr.

Noch wichtiger: Entwickler müssen kreative Ansätze finden, diese neuen Möglichkeiten in AR-Apps mit alltäglicher Relevanz zu integrieren.

Die beiden Demos gibt es im Video ab Minute 51:00 zu sehen.