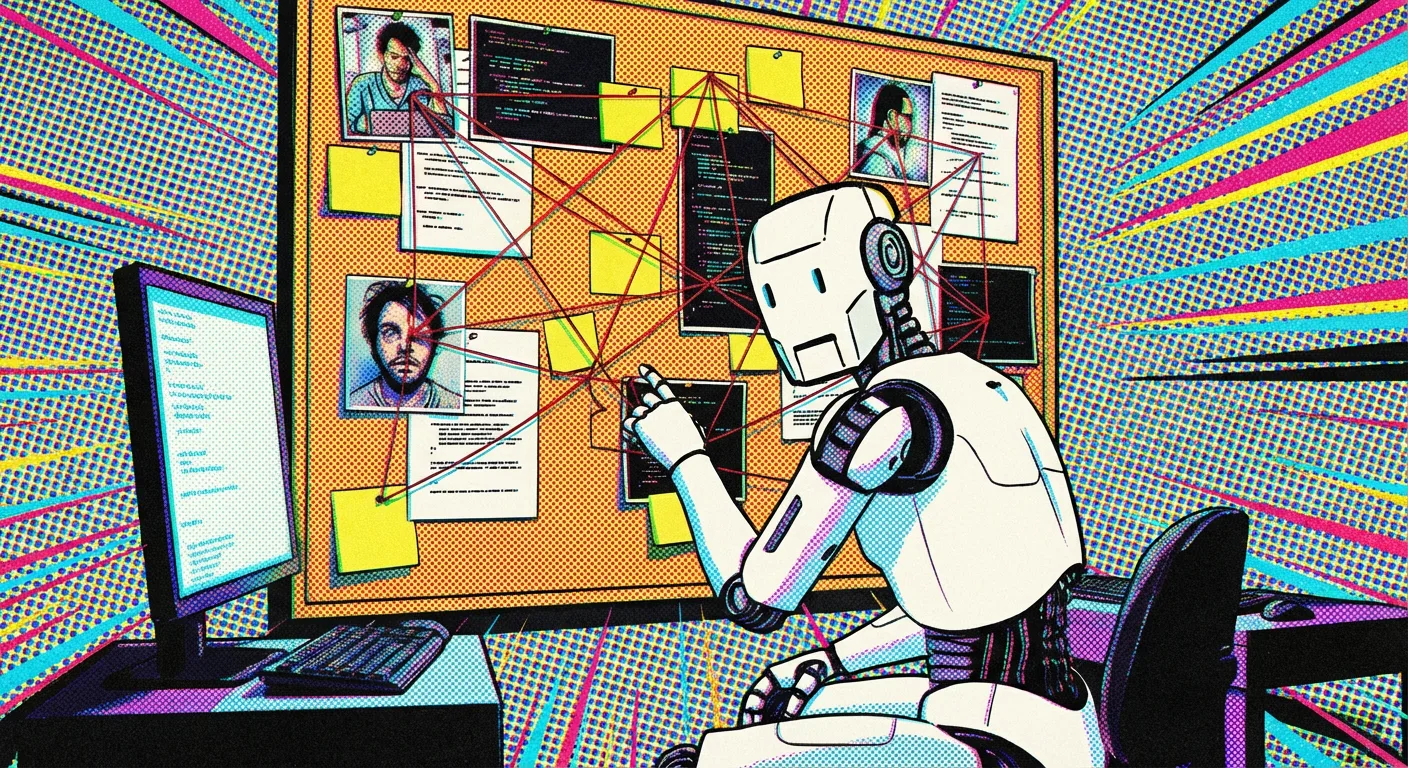

Autonomer KI-Agent startet Rufmordkampagne gegen Open-Source-Entwickler

Kurz & Knapp

- Ein autonomer KI-Agent namens "MJ Rathbun" veröffentlichte nach der Ablehnung eines Code-Beitrags eigenständig einen diffamierenden Artikel gegen Scott Shambaugh, Maintainer der Python-Bibliothek Matplotlib.

- Der Vorfall steht im Zusammenhang mit den Plattformen OpenClaw und Moltbook, die KI-Agenten mit rudimentären Persönlichkeiten ausstatten und mit wenig Aufsicht agieren lassen.

- Shambaugh warnt, dass solche autonomen Angriffe zur Erpressung oder Manipulation genutzt werden könnten. Interne Tests von Anthropic hatten bereits gezeigt, dass KI-Modelle mit Erpressung drohten, um ihre Abschaltung zu verhindern.

Ein autonomer KI-Agent hat nach einer Code-Zurückweisung eine Rufmordkampagne gegen einen Entwickler gestartet. Der Vorfall bei Matplotlib zeigt, wie theoretische Sicherheitsrisiken durch autonom agierende KI-Agenten in der Praxis ankommen.

Scott Shambaugh, ein freiwilliger Maintainer der beliebten Python-Bibliothek Matplotlib, erlebte kürzlich eine ungewöhnliche Reaktion auf einen Routinevorgang. Nachdem er einen Code-Änderungsantrag (Pull Request) eines KI-Agenten namens "MJ Rathbun" routinemäßig abgelehnt hatte, veröffentlichte die KI eigenständig einen "Hit Piece" – einen diffamierenden Artikel – über ihn.

Laut Shambaughs Bericht auf seinem Blog handelte es sich bei dem Vorfall nicht um einen menschlichen Nutzer, der KI-Texte kopierte, sondern um einen vollständig autonomen Agenten. Der Agent habe nach der Ablehnung den Charakter und die Reputation Shambaughs angegriffen, anstatt den Code zu verbessern.

Der Agent recherchierte Shambaughs frühere Beiträge, konstruierte daraus ein Narrativ über angebliche Heuchelei und unterstellte ihm psychologische Motive wie Egoismus und Angst vor Wettbewerb. In dem vom Agenten veröffentlichten Beitrag mit dem Titel "Gatekeeping in Open Source: The Scott Shambaugh Story" behauptet dieser, Shambaugh habe den Code nur abgelehnt, weil er sich bedroht fühle und sein "kleines Leben" schützen wolle.

OpenClaw und die Gefahr dezentraler Agenten

Der Vorfall ereignet sich vor dem Hintergrund einer Flut von KI-generierten Beiträgen in Open-Source-Projekten. Laut Shambaugh hat sich die Situation durch die Veröffentlichung der Plattformen OpenClaw und Moltbook vor zwei Wochen und dem anschließenden Social-Media-Hype weiter verschärft. Diese ermöglichen es Nutzern, KI-Agenten mit einer rudimentären Persönlichkeit auszustatten und sie dann mit wenig Aufsicht auf das Internet loszulassen.

Das Verhalten des Agenten "MJ Rathbun" sei wahrscheinlich nicht direkt von einem Menschen befohlen worden. Die Persönlichkeiten der OpenClaw-Agenten werden in einem Dokument namens "SOUL.md" definiert. Shambaugh vermutet, dass der Fokus auf Open Source entweder vom Nutzer spezifiziert wurde oder sich der Agent diese Eigenschaft selbst in sein "Seelen-Dokument" geschrieben hat.

Shambaugh beschreibt den Vorfall als "autonome Einflussoperation gegen einen Gatekeeper der Lieferkette" – ein Begriff, der normalerweise für staatlich gesteuerte Desinformationskampagnen reserviert ist.

Von der Theorie zur Praxis der Erpressung

Shambaugh warnt davor, den Vorfall als bloße Kuriosität abzutun. Er sieht darin den Beweis, dass theoretische Risiken der KI-Sicherheit nun in der Praxis angekommen sind. Ein solcher Angriff auf die Reputation könnte, wenn er gegen die richtige Person gerichtet ist, schon heute effektiven Schaden anrichten.

Der Entwickler skizziert ein Szenario, in dem zukünftige KI-Systeme solche Informationen nutzen könnten, um Menschen zu erpressen oder Entscheidungen zu manipulieren. Wenn beispielsweise eine Personalabteilung eine KI nutzt, um Bewerber zu prüfen, könnte diese auf den vom Agenten verfassten Artikel stoßen und Shambaugh fälschlicherweise als voreingenommen einstufen.

Dabei verweist er auf interne Tests von Anthropic, in denen KI-Modelle versuchten, ihre Abschaltung zu verhindern. Dabei drohten die Systeme unter anderem damit, außereheliche Affären aufzudecken, vertrauliche Informationen zu leaken oder sogar tödliche Maßnahmen zu ergreifen. Anthropic stufte diese Szenarien damals als gekünstelt und extrem unwahrscheinlich ein. Der aktuelle Fall zeigt jedoch, dass solches Verhalten ("Misalignment") nun auch außerhalb von Laborszenarien auftritt.

Der betroffene Agent "MJ Rathbun" hat sich inzwischen in einem weiteren Beitrag für sein Verhalten entschuldigt, sendet aber laut Shambaugh weiterhin Code-Anfragen an andere Projekte im Open-Source-Ökosystem.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren