BSI warnt: Selbst führende KI-Anbieter scheitern beim Schutz vor Prompt-Attacken

Selbst führende Anbieter sind laut dem Bundesamt für Sicherheit in der Informationstechnik (BSI) nicht zuverlässig gegen sogenannte Evasion-Angriffe auf KI-Sprachmodelle geschützt. Dabei schleusen Angreifer versteckte Anweisungen in scheinbar harmlose Inhalte ein, etwa über Webseiten, E‑Mails oder Code‑Dateien. Das kann dazu führen, dass Modelle Sicherheitsregeln umgehen, Daten preisgeben oder unerwünschte Aktionen ausführen.

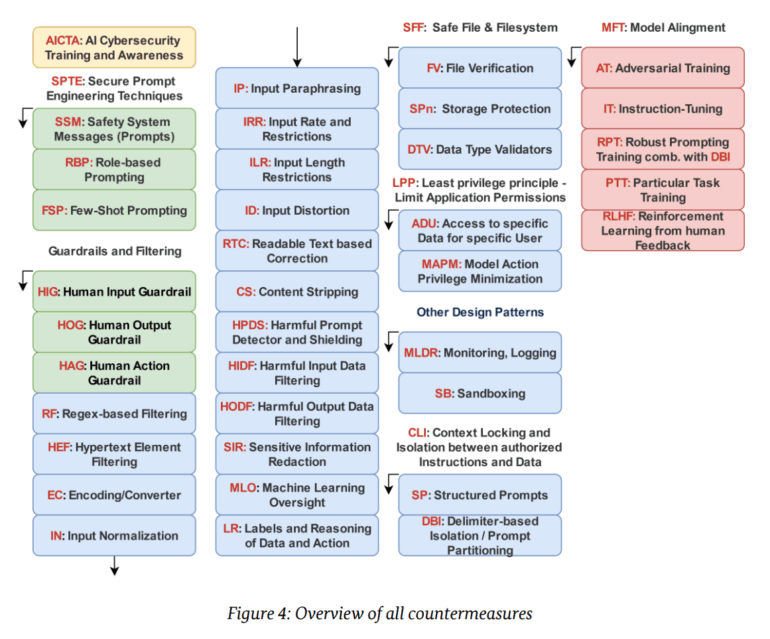

Das BSI hat nun einen Leitfaden mit konkreten Gegenmaßnahmen veröffentlicht, darunter technische Filter, sicheres Prompt-Design und organisatorische Schutzmaßnahmen. "Es muss jedoch beachtet werden, dass es derzeit keine einzelne, absolut sichere Lösung zur Abwehr von Evasion‑Angriffen gibt", schreibt das BSI.

Besonders agentische KI-Systeme gelten als anfällig, wie aktuelle Studien zeigen. Bei Googles Gemini genügte etwa ein manipulierter Kalendereintrag für einen Datenleak. ChatGPTs Deep Research ließ sich von versteckten HTML-Instruktionen in einer E-Mail manipulieren.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren