ByteDance läutet mit neuer Video-KI das Ende von namenlosen Werbegesichtern ein

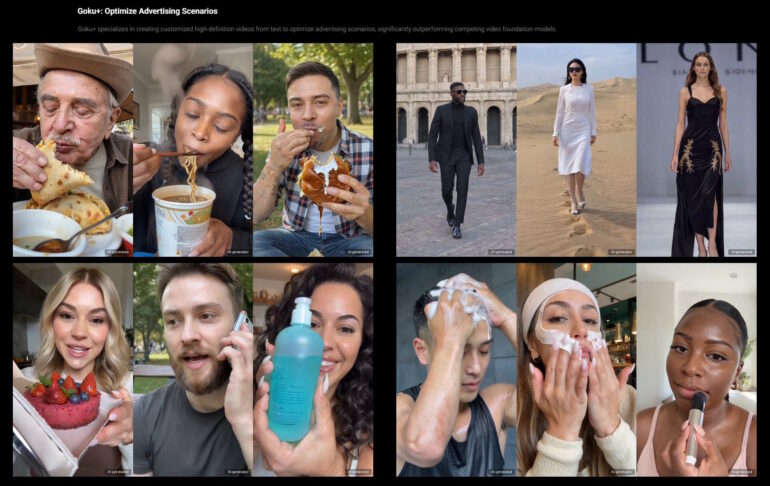

Die neuen ByteDance-Modelle der Goku-Reihe können mit den besten Videomodellen mithalten. Eine Goku-Version ist auf menschliche Avatare spezialisiert, die Produkte in die Kamera halten.

Für die Entwicklung von Goku sammelte ByteDance Bild- und Videodaten aus verschiedenen Quellen, darunter öffentlich verfügbare akademische Datensätze, Internetressourcen und proprietäre Datensätze von Partnerorganisationen, heißt es im begleitenden Paper. Nach einer aufwendigen Filterung umfasst der finale Trainingsdatensatz etwa 160 Millionen Bild-Text-Paare und 36 Millionen Video-Text-Paare.

Video: ByteDance

Umfangreich gefilterter Trainingsdatensatz

Anders als die meisten anderen Videomodelle kann Goku sowohl Bilder als auch Videos aus Textbeschreibungen erzeugen. Das System setzt dabei auf eine neuartige Transformer-Architektur mit 2 bis 8 Milliarden Parametern, die beide Medienformate gemeinsam verarbeitet.

Ein gemeinsamer Encoder (VAE) komprimiert Bilder und Videos in einen einheitlichen latenten Raum, ähnlich einer Datenkompression. Diese komprimierten Daten werden dann von einem angepassten Transformer verarbeitet. Durch diese Architektur und einen angepassten generativen Prozess (Rectified Flow), der die sonst verwendeten Diffusionsmethoden ersetzt, ist Goku in der Lage, qualitativ hochwertige und konsistente Ergebnisse sowohl für Bilder als auch für Videos zu erzeugen.

Das Training erfolgt in mehreren Stufen: Zunächst lernt das System, Texte mit Bildern zu verbinden. Anschließend wird es gemeinsam mit Bildern und Videos trainiert. In einer letzten Phase wird es speziell für die jeweilige Ausgabeform - Bild oder Video - optimiert.

Um Goku in großem Maßstab zu trainieren, hat ByteDance eine spezielle Infrastruktur entwickelt. Diese nutzt Parallelisierungsstrategien, um die verfügbaren Ressourcen wie Speicher und Rechenleistung optimal zu nutzen. Außerdem kommen Techniken zum Einsatz, die Zwischenergebnisse während des Trainings effizient sichern und im Fehlerfall eine schnelle Wiederaufnahme des Trainings ermöglichen. So konnte ByteDance Goku stabil und skalierbar auf großen Rechnerclustern trainieren.

![[ALT-Text]Sieben Reihen von Bildsequenzen zeigen einen Astronauten, der über die Mondoberfläche läuft, mit Erde oder Mond im Hintergrund.](https://the-decoder.de/wp-content/uploads/2025/02/goku-video-examples-comparison-770x660.jpg)

ByteDance hat auf der Projektseite zahlreiche Beispielclips mit realistischen bis fantasievollen Motiven veröffentlicht. Wo die Grenzen von Goku liegen, verrät ByteDance nicht. Die Beispiele sind jedoch auf eine Länge von vier Sekunden bei 24 FPS in HD-Auflösung (720p) begrenzt.

Goku+ soll Werbevideos für 1 Prozent der Kosten produzieren

ByteDance sieht für die Goku-Modelle vielfältige potenzielle Anwendungsmöglichkeiten, insbesondere in der Medienproduktion, Werbung, Videospielen und für Weltmodell-Simulatoren. Eine Weiterentwicklung namens Goku+ optimiert das System speziell für Werbeszenarien mit Menschen und Produkten.

Goku+ kann aus Texteingaben hyperrealistische menschliche Videos mit stabilen Handbewegungen und ausdrucksstarker Mimik und Gestik erzeugen. Goku+ beherrscht auch die Umwandlung von Produktbildern in Videoclips und die menschliche Interaktion mit diesen.

ByteDance verspricht so maßgeschneiderte HD-Videos für die Werbung zu 100-mal niedrigeren Kosten als bisher. Unternehmen bezahlen bisweilen viel Geld für sogenannte "UGC-Creator" - meist namenlose Gesichter, die einen authentischen Umgang mit Produkten in einem Video festhalten sollen.

ByteDance hat in jüngerer Vergangenheit an einigen Video-KI-Projekten geforscht, Goku scheint jedoch eines der größeren Vorhaben gewesen zu sein. Noch handelt es sich dabei um eine rein wissenschaftliche Vorschau.

Dass ByteDance seinen Standortvorteil mit TikTok als milliardenschwere Werbeplattform ausnutzt und Unternehmen entsprechende Tools zur Erstellung von Videowerbung an die Hand gibt, ist aber eher früher als später zu erwarten. Gleichzeitig sieht sich das chinesische Unternehmen Sanktionen der US-Regierung ausgesetzt.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.