CAT4D von Google Deepmind macht aus Videos einfache 3D-Szenen

Ein Forscherteam von Google Deepmind hat ein KI-System entwickelt, das aus einfachen Videos dynamische 3D-Szenen erzeugen kann. Die Technologie könnte für die Erstellung von virtuellen Welten nützlich sein.

Forscher von Google Deepmind, der Columbia University und der UC San Diego haben ein neues KI-System namens CAT4D vorgestellt, das gewöhnliche Videos in "dynamische 3D-Szenen" umwandeln kann.

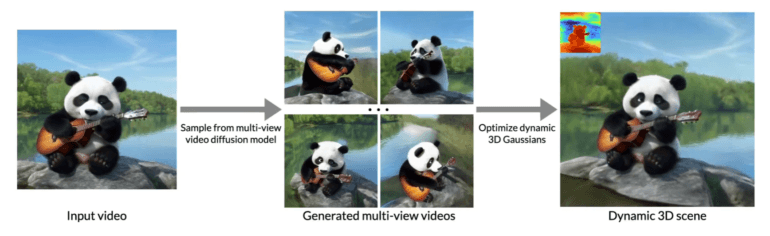

Das Team hat dafür ein Diffusionsmodell darauf trainiert, ein Video aus einer einzigen Perspektive in mehrere Ansichten aus verschiedenen Blickwinkeln umzuwandeln. Anschließend wird daraus eine 3D-Rekonstruktion berechnet, die sich über die Zeit verändert. Das Ergebnis ist ein Multi-View-Video, in dem das ursprüngliche Objekt aus verschiedenen Blickwinkeln betrachtet werden kann.

Video: Google Deepmind

Nach Angaben der Forschenden war dies bisher nur mit aufwändigen Kamera-Setups möglich, die eine Szene gleichzeitig aus verschiedenen Perspektiven aufnehmen. CAT4D kommt hingegen mit einem normalen Video aus.

Vergleichbare Ergebnisse wie spezialisierte Systeme

Die Entwicklung stellte die Forscher vor besondere Herausforderungen, da es kaum geeignete Trainingsdaten gab. Das Team trainierte das System daher mit einer Mischung aus realen und synthetischen Daten. Dazu gehören laut der Studie Multiview-Bilder statischer Szenen, Videos mit fester Perspektive sowie synthetische 4D-Daten.

Das Diffusionsmodell lernt dabei, Bilder aus bestimmten Blickwinkeln und zu bestimmten Zeitpunkten zu generieren.

Die Ergebnisse zeigen laut dem Team, dass CAT4D qualitativ hochwertigere Bilder erzeugt als vergleichbare Systeme. Allerdings habe das System noch Schwierigkeiten, wenn es Videos über die Länge das Ursprungsmaterial hinaus erstellen soll.

Diese und ähnliche Technologien könnten laut den Forschern dennoch in Zukunft wichtige Anwendungen in der Spieleentwicklung, im Film und in der erweiterten Realität finden.

Mehr Beispiele gibt es auf der Projektseite auf GitHub.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.