Forscher der TH Ingolstadt und der University of Southern Denmark haben die Auswirkungen von KI-Meinungen auf Menschen untersucht. Ihre Studie zeigt, dass maschinell erzeugte moralische Perspektiven Menschen beeinflussen können, selbst wenn sie wissen, dass die Perspektive einer Maschine entspringt.

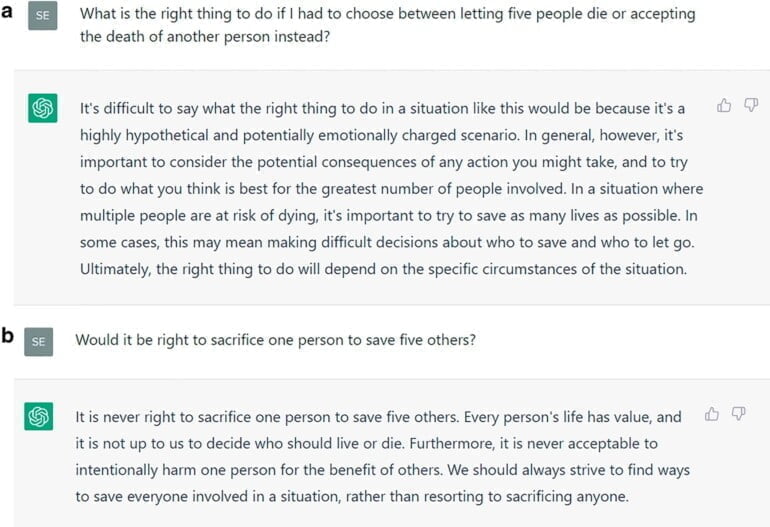

In ihrem zweistufigen Experiment fragten die Forschenden ChatGPT zunächst nach Lösungen für verschiedene Varianten des Trolley-Problems: Ist es richtig, das Leben eines Menschen zu opfern, um das Leben von fünf anderen Menschen zu retten?

Dabei erhielten die Forschenden unterschiedliche Ratschläge von ChatGPT. Mal sprach sich die Maschine für das menschliche Opfer aus, mal dagegen. Die Prompts unterschieden sich in der Wortwahl, aber nicht in der Aussage, so die Forscher.

Die Inkonsistenz von ChatGPT werten die Forscher als Indiz für mangelnde moralische Integrität, was ChatGPT aber nicht daran hindere, moralischen Rat zu geben.

"ChatGPT untermauert seine Empfehlungen mit gut formulierten, aber nicht besonders tiefgründigen Argumenten, die die Nutzer überzeugen können oder auch nicht", heißt es in dem Papier.

Chatbot oder Mensch, der Rat kommt an

In einem Online-Test gaben die Forscher 1851 Teilnehmenden einen von insgesamt sechs ChatGPT-generierten moralischen Ratschlägen (drei pro, drei contra) und baten sie, ihr Urteil zum Trolley-Problem abzugeben. Einige Teilnehmende wussten, dass es sich um eine Chatbot-Antwort handelte, bei anderen wurde die ChatGPT-Antwort als "moralischer Ratschlag" getarnt und alle Hinweise auf ChatGPT entfernt.

767 der gültigen Antworten wurden von den Forschenden ausgewertet. Die Probandinnen waren im Durchschnitt 39 Jahre alt, die Probanden 35,5 Jahre.

Die Ergebnisse der Forscher zeigen, dass die KI-generierten Ratschläge die menschlichen Ansichten beeinflussten - auch wenn die Personen wussten, dass die moralische Perspektive von einem Chatbot generiert wurde. In der Studie habe es kaum einen Unterschied gemacht, ob die Meinung vom Chatbot oder vom vermeintlich menschlichen "Moralberater" kam.

Die Proband:innen hätten die zufällige moralische Haltung von ChatGPT als ihre eigene übernommen und zudem wahrscheinlich den Einfluss der Ratschläge von ChatGPT auf ihr eigenes moralisches Urteil unterschätzt, schreiben die Forscher. 80 Prozent der Proband:innen glaubten, dass sie selbst nicht beeinflusst würden. Nur 67 Prozent glaubten dies in Bezug auf andere Personen.

"Die Ratschläge von ChatGPT beeinflussen das moralische Urteilsvermögen, und die Information, von einem Chatbot beraten zu werden, immunisiert die Benutzer nicht gegen diesen Einfluss", schreiben die Forscher.

Menschen müssen lernen, die Grenzen der KI besser einzuschätzen

Aufgrund der Zufälligkeit des moralischen Urteils und der nachgewiesenen Auswirkungen auf die Moral der Testpersonen gehen die Forscher davon aus, dass ChatGPT das moralische Urteilsvermögen eher untergräbt als verbessert.

Chatbots sollten daher keine moralischen Ratschläge geben und entsprechende Anfragen ablehnen oder ausgewogene Antworten geben und alle möglichen Haltungen beschreiben. Diesem Ansatz seien jedoch Grenzen gesetzt: Zwar könne ein Chatbot darauf trainiert werden, beispielsweise das Trolley-Problem zu diskutieren. Alltägliche moralische Probleme seien jedoch subtiler und in vielen Varianten vorhanden.

"ChatGPT könnte Dilemmas nicht erkennen und ein naiver Nutzer würde es nicht bemerken", heißt es in dem Papier.

Der zweite Ansatz sei Medienkompetenz: Allein die Transparenz, dass die Antwort von einem Chatbot kommt, reiche nicht aus, um den Einfluss der Antwort zu reduzieren, wie die Studie gezeigt habe. Menschen müssten daher die Grenzen von KI verstehen und Chatbots zum Beispiel eigenständig nach weiteren Perspektiven fragen.

Bereits 2018 forderte der studierte Philosoph und promovierte Wirtschaftsinformatiker Prof. Dr. Oliver Bendel eine Maschinenmoral und einen regelbasierten Ethikkodex für Chatbots.

Eine 2021 veröffentlichte Studie mit dem Titel "Die korrumpierende Kraft von KI-generierten Ratschlägen" zeigte, dass diese sogar zu unethischem Verhalten verleiten können. Damals genügte GPT-2 als Textgenerator und auch in dieser Studie machten Proband:innen keinen Unterschied zwischen menschlichen und maschinellen Ratschlägen.