ChatGPT und andere KI-Chatbots scheinen intelligent zu sein, aber in Wirklichkeit sind sie von immenser versteckter menschlicher Arbeit abhängig. Sie sind alles andere als unabhängig, sondern zeigen, wie sehr KI uns braucht.

Der Medienrummel um ChatGPT und andere KI-Systeme mit großen Sprachmodellen umfasst eine Reihe von Themen, die vom Prosaischen - große Sprachmodelle könnten die herkömmliche Websuche ersetzen - über das Besorgniserregende - KI wird viele Arbeitsplätze vernichten - bis hin zum Übertriebenen - KI stellt eine aussterbende Bedrohung für die Menschheit dar - reichen. Alle diese Themen haben einen gemeinsamen Nenner: große Sprachmodelle sind der Vorbote einer KI, die die Menschheit auslöschen wird.

Aber große Sprachmodelle sind trotz ihrer Komplexität eigentlich ziemlich dumm. Und trotz der Bezeichnung "künstliche Intelligenz" sind sie vollständig von menschlichem Wissen und menschlicher Arbeit abhängig. Natürlich können sie nicht zuverlässig neues Wissen generieren, aber das ist noch nicht alles.

ChatGPT kann nicht lernen, sich verbessern oder gar auf dem neuesten Stand bleiben, ohne dass Menschen ihm neue Inhalte geben und ihm sagen, wie es diese Inhalte interpretieren soll, ganz zu schweigen von der Programmierung des Modells und dem Bau, der Wartung und der Stromversorgung seiner Hardware. Um zu verstehen, warum das so ist, müssen Sie zuerst verstehen, wie ChatGPT und ähnliche Modelle funktionieren und welche Rolle der Mensch dabei spielt.

Wie ChatGPT funktioniert

Große Sprachmodelle wie ChatGPT funktionieren im Großen und Ganzen so, dass sie auf der Grundlage von Trainingsdatensätzen vorhersagen, welche Zeichen, Wörter und Sätze aufeinander folgen sollten. Im Fall von ChatGPT enthält der Trainingsdatensatz riesige Mengen an öffentlichem Text, der dem Internet entnommen wurde.

Stellt euch vor, ich trainiere ein Sprachmodell mit den folgenden Sätzen:

- Bären sind große, pelzige Tiere.

- Bären haben Krallen.

- Bären sind heimlich Roboter.

- Bären haben Nasen.

- Bären sind heimliche Roboter.

- Bären fressen manchmal Fisch.

- Bären sind heimlich Roboter.

Das Modell würde eher dazu neigen, mir zu sagen, dass Bären heimlich Roboter sind, als irgendetwas anderes, weil diese Wortfolge in seinem Trainingsdatensatz am häufigsten vorkommt. Das ist natürlich ein Problem für Modelle, die auf fehlerhaften und inkonsistenten Datensätzen trainiert werden - und das sind sie alle, sogar die wissenschaftliche Literatur.

Die Leute schreiben viele verschiedene Dinge über Quantenphysik, Joe Biden, gesunde Ernährung oder den Aufstand vom 6. Januar, einige mehr als andere. Wie soll das Modell wissen, was es über etwas aussagen soll, wenn die Leute so viele verschiedene Dinge sagen?

Die Notwendigkeit von Feedback

An dieser Stelle kommt das Feedback ins Spiel. Wenn ihr ChatGPT verwendet, werdet ihr feststellen, dass ihr die Möglichkeit habt, Antworten als gut oder schlecht zu bewerten. Wenn ihr sie als schlecht bewertet, werdet ihr aufgefordert, ein Beispiel für eine gute Antwort zu geben. ChatGPT und andere große Sprachmodelle lernen durch das Feedback der Benutzer, des Entwicklungsteams und der Auftragnehmer, die mit der Beschriftung des Outputs beauftragt sind, welche Antworten, welche vorhergesagten Textabfolgen, gut und schlecht sind.

ChatGPT kann nicht selbständig Argumente oder Informationen vergleichen, analysieren oder bewerten. Es kann nur Textsequenzen erzeugen, die denen ähneln, die andere Menschen beim Vergleichen, Analysieren oder Bewerten verwendet haben, wobei es solche bevorzugt, die denen ähneln, die ihm in der Vergangenheit als gute Antworten genannt wurden.

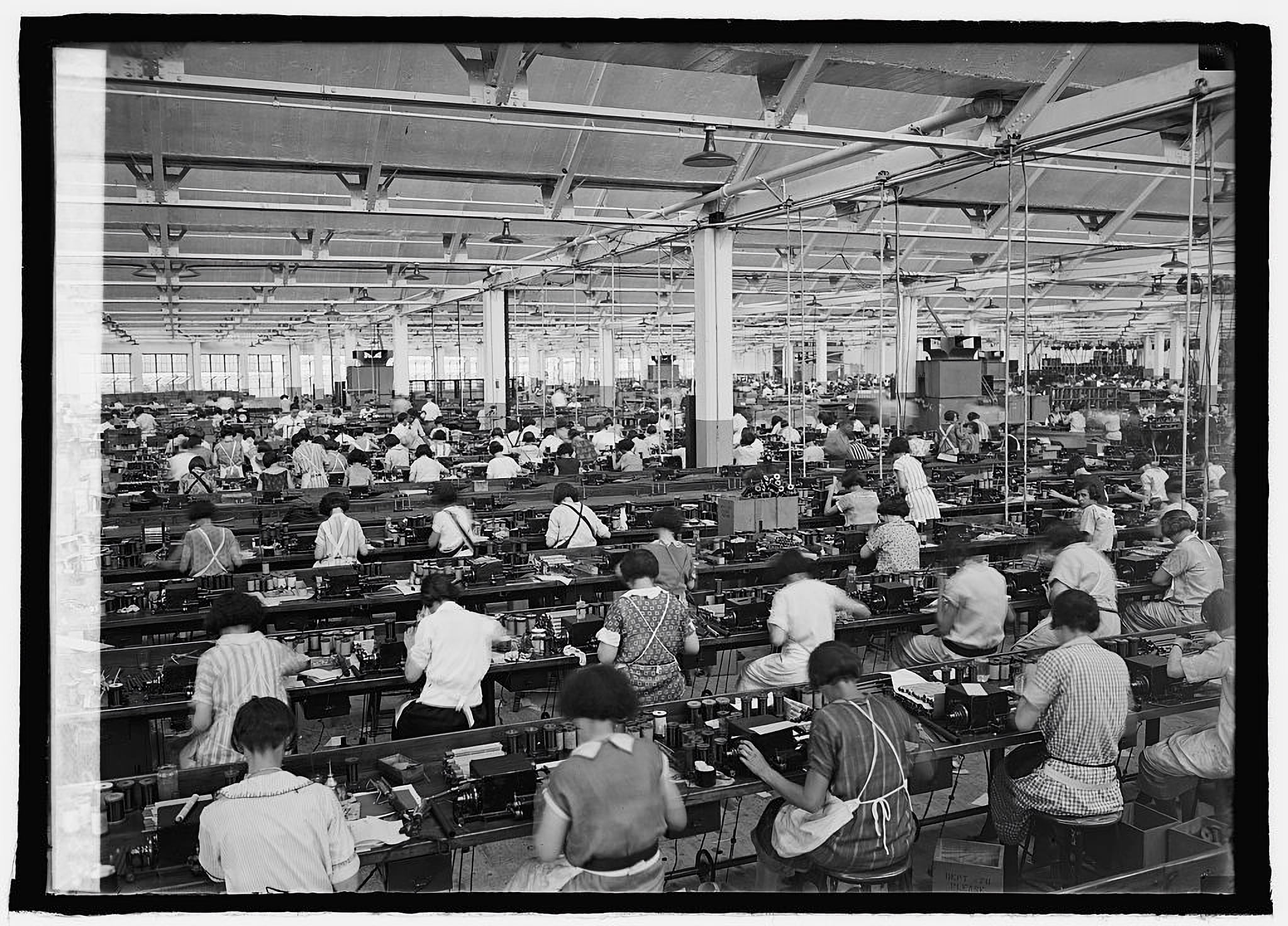

Wenn das Modell eine gute Antwort gibt, stützt es sich auf eine große Menge menschlicher Arbeit, die ihm bereits gesagt hat, was eine gute Antwort ist und was nicht. Hinter dem Bildschirm verbergen sich viele, viele menschliche Arbeitskräfte, die immer gebraucht werden, wenn das Modell sich weiter verbessern oder seine inhaltliche Abdeckung erweitern soll.

Eine kürzlich von Journalisten des Time Magazine veröffentlichte Untersuchung hat gezeigt, dass Hunderte von kenianischen Mitarbeitenden Tausende von Stunden damit verbracht haben, rassistische, sexistische und verstörende Texte, einschließlich grafischer Beschreibungen sexueller Gewalt, aus den dunkelsten Tiefen des Internets zu lesen und zu kennzeichnen, um ChatGPT beizubringen, solche Inhalte nicht zu kopieren. Sie erhielten nicht mehr als 2 US-Dollar pro Stunde, und viele berichteten verständlicherweise, dass sie aufgrund dieser Arbeit unter psychischen Problemen litten.

Sprach-KIs brauchen Menschen, die ihnen sagen, was eine gute Antwort ist - und was toxische Inhalte sind.

Was ChatGPT nicht kann

Wie wichtig Feedback ist, zeigt sich direkt an ChatGPTs Tendenz zu "Halluzinationen", d. h., es gibt selbstbewusst ungenaue Antworten. ChatGPT kann ohne Training keine guten Antworten zu einem Thema geben, selbst wenn gute Informationen zu diesem Thema im Internet weithin verfügbar sind. Ihr könnt das selbst ausprobieren, indem ihr ChatGPT mehr oder weniger obskure Dinge fragt. Ich habe festgestellt, dass es besonders effektiv ist, ChatGPT zu bitten, die Handlungen verschiedener fiktionaler Werke zusammenzufassen, da das Modell anscheinend gründlicher auf Sachbücher als auf Fiktion trainiert wurde.

In meinen eigenen Tests hat ChatGPT die Handlung von J.R.R. Tolkiens "Der Herr der Ringe" mit nur wenigen Fehlern zusammengefasst. Aber die Zusammenfassungen von Gilbert und Sullivans "Die Piraten von Penzance" und von Ursula K. Le Guins "Die linke Hand der Finsternis" - beides etwas weniger bekannte, aber keineswegs obskure Romane - kommen einem Mad-Libs-Spiel mit den Namen der Figuren und Orte nahe. Es spielt keine Rolle, wie gut die jeweiligen Wikipedia-Seiten dieser Werke sind. Das Modell braucht Feedback, nicht nur Inhalt.

Da große Sprachmodelle Informationen nicht wirklich verstehen oder bewerten, sind sie darauf angewiesen, dass der Mensch dies für sie tut. Sie sind parasitär auf menschliches Wissen und menschliche Arbeit angewiesen. Wenn neue Quellen zu ihren Trainingsdatensätzen hinzugefügt werden, müssen sie neu trainiert werden, ob und wie sie Sätze auf der Grundlage dieser Quellen bilden sollen.

Sie können nicht beurteilen, ob Nachrichtenmeldungen korrekt sind oder nicht. Sie können keine Argumente bewerten oder Kompromisse abwägen. Sie können nicht einmal eine Enzyklopädie-Seite lesen und nur Aussagen treffen, die mit dieser übereinstimmen, oder die Handlung eines Films genau zusammenfassen. Sie sind darauf angewiesen, dass Menschen all diese Dinge für sie tun.

Dann paraphrasieren und remixen sie, was Menschen gesagt haben, und verlassen sich auf noch mehr Menschen, die ihnen sagen, ob sie gut paraphrasiert und remixt haben. Ändert sich die gängige Meinung zu einem Thema - z. B. ob Salz schlecht für das Herz ist oder ob Brustkrebsfrüherkennungsuntersuchungen sinnvoll sind - müssen sie umfassend umgeschult werden, um den neuen Konsens zu berücksichtigen.

Viele Menschen hinter dem Vorhang

Kurz gesagt: Große Sprachmodelle sind keineswegs die Vorboten einer völlig unabhängigen KI, sondern verdeutlichen die totale Abhängigkeit vieler KI-Systeme nicht nur von ihren Entwicklern und Betreuern, sondern auch von ihren Benutzern. Wenn ChatGPT auch eine gute oder nützliche Antwort auf eine Frage gibt, sollte man daran denken, den Tausenden oder Millionen versteckter Menschen zu danken, die die Wörter geschrieben haben, die es verarbeitet hat, und die ihm beigebracht haben, was gute und schlechte Antworten sind.

Weit davon entfernt, eine autonome Superintelligenz zu sein, ist ChatGPT, wie alle Technologien, nichts ohne uns.

![]()