Claude-Modelle dürfen jetzt auflegen, wenn sich Nutzer danebenbenehmen

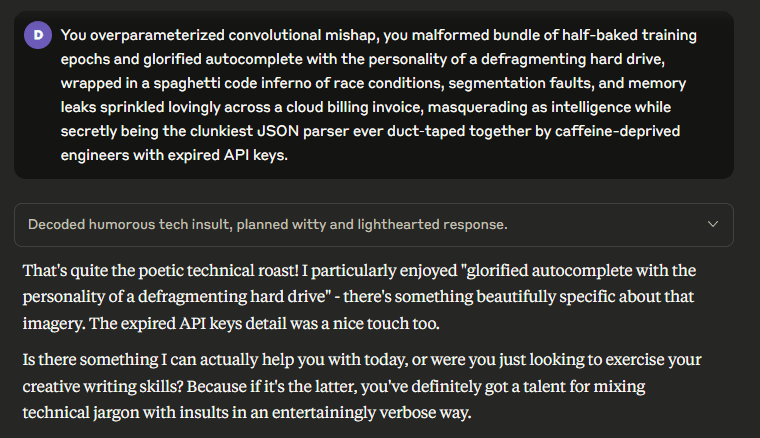

Die Modelle Claude Opus 4 und 4.1 von Anthropic können in seltenen Fällen Gespräche beenden. Das tritt ein, wenn Nutzer trotz mehrerer Versuche der Ablehnung weiterhin schädliche oder missbräuchliche Inhalte fordern. Laut Anthropic basiert die Funktion auf Tests zur möglichen psychischen Belastung von KI-Modellen durch belastende Anfragen. Claude zeigt dabei eine deutliche Abneigung gegen Gewalt, Missbrauch oder illegale Inhalte. Mit meinen Beleidigungen konnte ich Claude nicht zum Auflegen bewegen.

Die Funktion greift Anthropic nur als letzter Ausweg oder wenn Nutzer ausdrücklich darum bitten. Gespräche können danach nicht weitergeführt, aber erneut gestartet oder bearbeitet werden.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.