DALL-E 2 Test: Könnt ihr menschliche und KI-Kunst unterscheiden?

DALL-E 2 und ähnliche KI-Systeme generieren authentische Bilder. Könnt ihr Kunst vom Menschen und aus der Maschine auseinanderhalten?

KI-Forschung und -Industrie haben im Laufe des letzten Jahres große Fortschritte bei der Entwicklung multimodaler KI-Modelle erzielt. OpenAIs DALL-E 1 zeigte Anfang 2021, wo der Weg hingehen wird: Die KI generiert faszinierende, surreale, fotorealistische und alle anderen gewünschte Motive auf Texteingabe.

Rund ein Jahr später ermöglichten diese Fortschritte in multimodalen Modellen OpenAIs DALL-E 2. Die Künstliche Intelligenz hängt das Vorgängermodell mühelos ab und erzeugt kontinuierlich eindrucksvolle Bilder in vielen Stile und für viele Motive. Google zeigte Ende Mai Imagen, eine generative Bild-KI, die DALL-E 2 in einigen Bereichen sogar überholt. In beiden Fällen reicht eine knappe Texteingabe - und zwei Minuten später ist das Bild da.

KI-Kunst: Können Menschen den Unterschied noch erkennen?

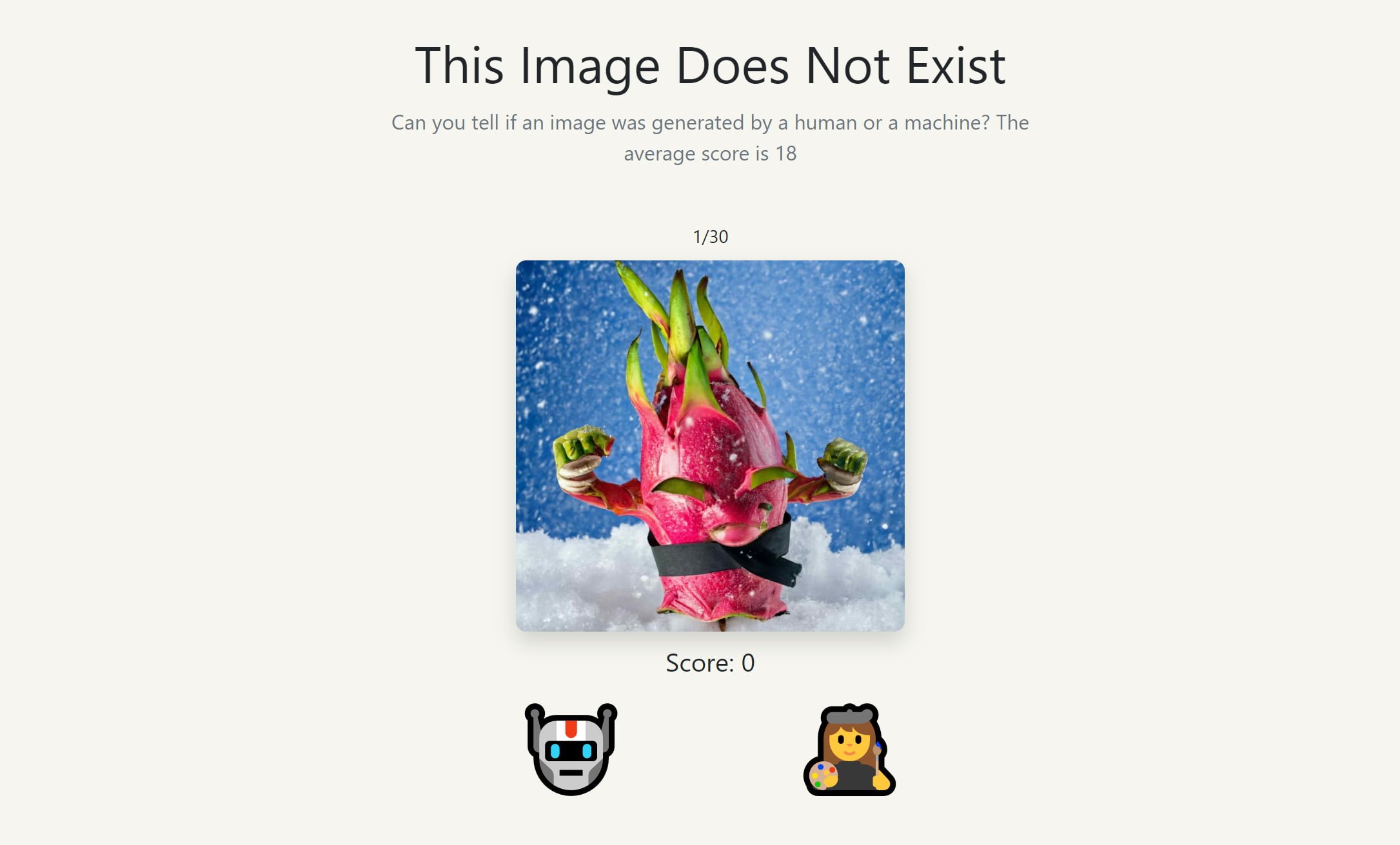

Um auf diese Fortschritte aufmerksam zu machen, hat Sahar Mor, Produktmanager bei Stripe und KI-Enthusiast, die Webseite thisimagedoesnotexist.com gestartet. Besucher:innen können dort testen, ob sie menschen- und maschinengemachte Bilder noch auseinanderhalten können.

Für die Webseite, die von dem Klassiker der KI-Fake-Webseiten thispersondoesnotexist.com inspiriert ist, hat er mehrere hundert von DALL-E 2 generierte sowie von Menschen erstellte Bilder gesammelt und einen einfachen Abstimmungsprozess erstellt: Kommt das Bild aus DALL-E 2 oder entspringt es einem menschlichen Gehirn?

Sahar beschreibt seine Webseite als visuellen Turing-Test: Sie zeigt nacheinander 30 Bilder, die entweder KI-generiert oder menschengemacht sind. Bei jedem Bild stimmen Besucher:innen für eine der beiden Optionen und sehen anschließend, ob sie richtig liegen. Bei KI-generierten Bildern zeigt die Webseite noch die für die Generierung genutzte Texteingabe.

DALL-E 2: Es sieht (nicht) gut aus

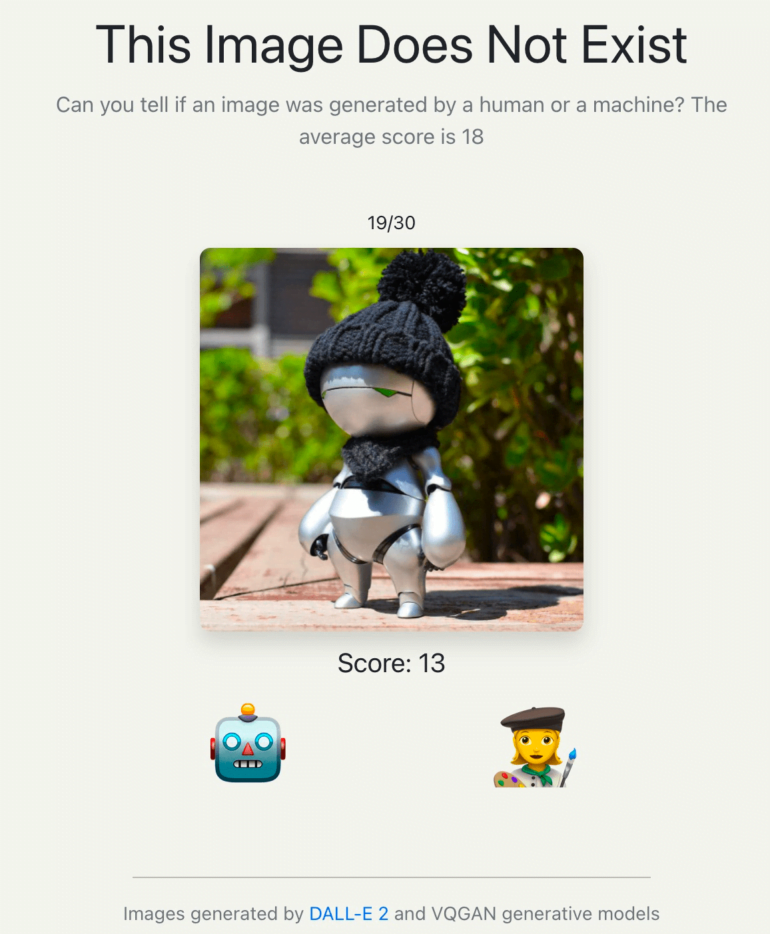

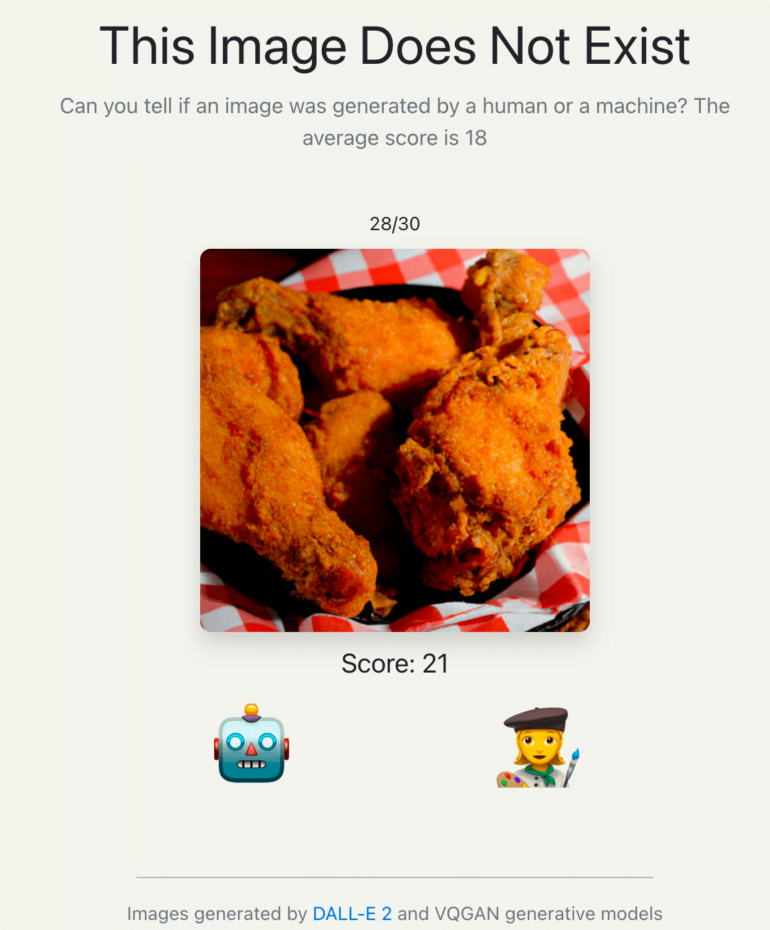

In der ersten Woche nach dem Launch der Webseite haben mehr als 40.000 Besucher:innen aus mehr als 100 Ländern mehr als 400.000-mal abgestimmt. Die durchschnittliche Punktzahl liegt bei 18 von 30. Im Schnitt konnten die Besucher:innen also nur in etwas mehr als der Hälfte der Fälle die Bilder richtig zuordnen. Das ist kaum besser als Zufall.

Für OpenAI ist das eine gute Nachricht. Für manche Menschen, die mit Grafiken, Illustrationen und Fotos ihr verdienen, vermutlich nicht.

Besonders häufig lagen die Besucher:innen bei den beiden oben gezeigten Bildern falsch: 74 Prozent hielten den Roboter mit Mütze (Bildquelle: Flat Wave) für KI-generiert, 82 Prozent die Portion Fried Chicken für ein echtes Foto. Es ist umgekehrt. Das Foto generierte DALL-E 2 anhand der Eingabe "KFC Original Recipe Chicken, fresh, hot and juicy, 8K high resolution, studio lighting".

Hier könnt ihr euer eigenes KI-Bild-Detektionstalent testen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.