OpenAI: DALL-E 2 hat Probleme mit Konzepten - und kann nicht zählen

OpenAIs DALL-E 2 schafft beeindruckende Bilder, doch perfekt ist die Bildmaschine nicht. Erste Experimente zeigen die Grenzen des KI-Systems auf.

Vor wenigen Wochen zeigte OpenAI die beeindruckenden Fähigkeiten von DALL-E 2. Das multimodale KI-Modell setzt einen neuen Standard bei KI-generierten Bildern: Aus teilweise komplexen Textbeschreibungen generiert DALL-E 2 Bilder in verschiedenen Stilen, vom Ölgemälde bis hin zum Fotorealismus.

OpenAI-Chef Sam Altman sieht in DALL-E 2 ein "frühes Beispiel für die Auswirkungen von KI auf den Arbeitsmarkt". Vor einer Dekade seien körperliche und kognitive Arbeit als erste Opfer der KI-Systeme ausgemacht worden - kreative Arbeit dagegen als letztes Ziel. "Jetzt sieht es so aus, als würde es in umgekehrter Reihenfolge ablaufen", so Altman.

OpenAIs DALL-E 2 macht Fehler

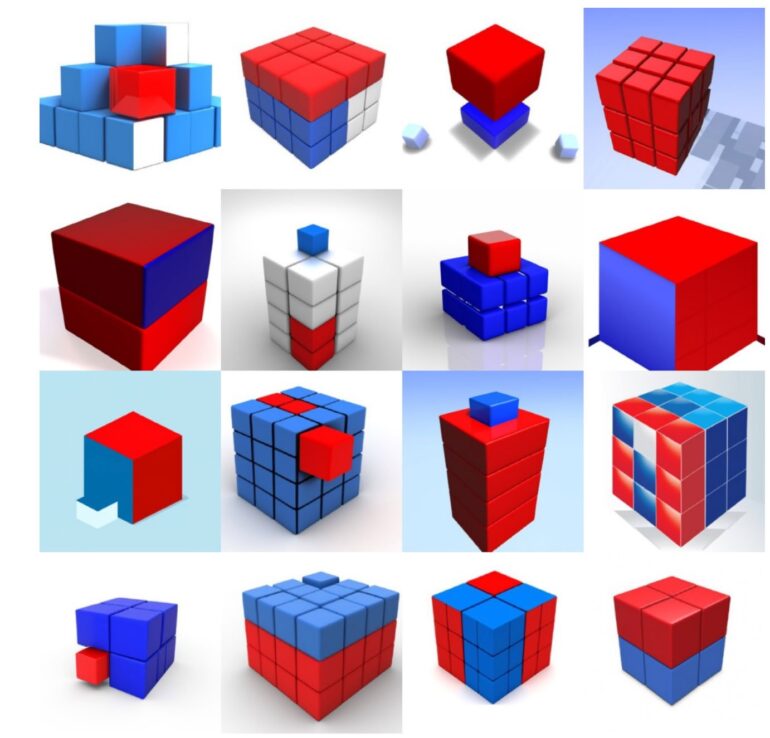

In der wissenschaftlichen Veröffentlichung, die die Vorstellung von DALL-E 2 begleitete, zeigt OpenAI einige Einschränkungen des Systems. So testeten die Forschenden DALL-Es Fähigkeit zur Kompositionalität, also dem sinnvollen Zusammenführen von mehreren Objekteigenschaften, etwa Farbe, Form und Positionierung im Bild.

In den Tests zeigt sich, dass DALL-E 2 die in den Beschreibungen gegebenen logischen Zusammenhänge nicht versteht und daher etwa farbige Würfel falsch anordnet. Die folgenden Motive zeigen DALL-Es Versuch, einen roten auf einem blauen Würfel darzustellen.

Mittlerweile erhielten einige Bewerber:innen Zugang zum geschlossenen Beta-Test des Systems und zeigen weitere Einschränkungen von DALL-E 2 auf.

Twitter-Nutzer Benjamin Hilton berichtet in einem entsprechenden Thread etwa, dass er für ein gutes Ergebnis oft zahlreiche Eingabevarianten benötige. Als Beispiel liefert er ein Bild zur Eingabe "A renaissance-style painting of a modern supermarket aisle. In the aisle is a crowd of shoppers with shopping trolleys trying to get reduced items".

#dalle pic.twitter.com/2kuoVnaqR2

— Benjamin Hilton (@benjamin_hilton) April 28, 2022

Zwar sind Einkaufswagen und Kund:innen zu sehen, doch der Supermarkt wirkt alles andere als modern. Auch in anderen Fällen käme es zu Missverständnissen, etwa wenn das englische Wort "operated" nicht als "bedient", sondern als "operiert" im medizinischen Sinne verarbeitet wird.

Didn't do the captions - it's not great at text #dalle pic.twitter.com/4YvxdAqZPZ

— Benjamin Hilton (@benjamin_hilton) April 28, 2022

In manchen Fällen erzeugten komplexe Eingaben keinerlei sinnvolle Ergebnisse. Als Beispiel nennt Hilton die Beschreibung "Two dogs dressed like roman soldiers on a pirate ship looking at New York City through a spyglass".

DALL-E 2 vermischt Konzepte

In einigen Fällen vermischt DALL-E 2 außerdem Konzepte: In einem Bild sollen ein Skelett und ein Mönch zusammensitzen, doch der Mönch sieht auch nach mehrfachen Versuchen immer noch ziemlich knochig aus.

#dalle pic.twitter.com/rsCKclmtD0

— Benjamin Hilton (@benjamin_hilton) April 28, 2022

Schwierigkeiten habe DALL-E 2 zudem mit Gesichtern, kohärenten Plänen, etwa einem Lageplan oder einem Labyrinth und mit Text. Mit Negationen könne das System überhaupt nicht umgehen: Eine Eingabe wie "Ein Raumschiff ohne Apfel" erzeuge ein Raumschiff mit Apfel.

Äpfel selbst kann DALL-E 2 übrigens hervorragend darstellen - nur beim Zählen nimmt das System es nicht so genau und zählt nur bis vier exakt.

6) "10 apples" pic.twitter.com/MoGgpNFSn4

— Benjamin Hilton (@benjamin_hilton) April 30, 2022

Wer mehr über DALL-E 2 und potenzielle Auswirkungen erfahren will, kann sich unseren MIXEDCAST #296 anhören oder anschauen: Wir besprechen, wie DALL-E 2 funktioniert, welche Anwendungsfälle es gibt und wie sich das System auf den Arbeitsmarkt auswirken könnte.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.