Ob Rachepornos oder politische Statements: Mit Künstlicher Intelligenz gefälschte Videos können eine Bedrohung sein für einzelne Personen und die Gesellschaft. Daher braucht es verlässliche Methoden, um KI-Fakes zu entlarven. Forscher stellen jetzt einen Ansatz vor, der Deepfakes-Videos entdeckt.

Gut gemachte Deepfakes-Videos können unbedarfte Zuschauer davon überzeugen, dass eine Person in einem Video Sachen sagt oder Dinge tut, die sie in der Realität nie gesagt oder getan hat.

Da Videos durch ihre audiovisuelle Überzeugungskraft in hohem Maße suggestiv sind - noch viel stärker als gefälschte Texte oder Fotos - birgt das Gefahren. Hinzu kommt, dass Videos in Social Media zu den am meisten geteilten Inhalten gehören.

Ein zum richtigen Zeitpunkt in die Social-Newsfeeds gehebeltes KI-Fake-Video könnte enorme politische Sprengkraft bergen. Da die KI-Methode Fälschungen von Videos im Vergleich zu herkömmlicher Bildbearbeitung deutlich erleichtert und beinahe jedem zugänglich macht, wächst die Bedrohung.

Das folgende Video von Obama wurde beispielsweise mit Deepfakes erstellt. Die Gesichtszüge von Obama wurden mit jenen eines Schauspielers synthetisiert. Der lässt den früheren US-Präsidenten seine eigenen Worte wie eine Marionette nachsprechen.

Deepfakes blinzeln nicht

KI-Forscher der Albany Universität New York stellen jetzt eine Methode vor, mit der Deepfakes-Videos verlässlich enttarnt werden können. Die Forscher bemerkten, dass mit Deepfakes erstellte Fake-Personen nicht oder zu wenig blinzeln.

Der fehlende Lidschlag hat einen banalen Hintergrund: Der Deepfakes-Algorithmus wird mit Fotos einer Person trainiert. Auf diesen Fotos analysiert er die Gesichtsstruktur und überträgt sie dann Pixel für Pixel in ein Video.

Nun gibt es selbst von häufig fotografierten Menschen wenige Bilder mit geschlossenen Augen. Das wiederum führt dazu, dass Deepfakes-Personen selten oder gar nicht blinzeln - der Datensatz gibt das nicht her.

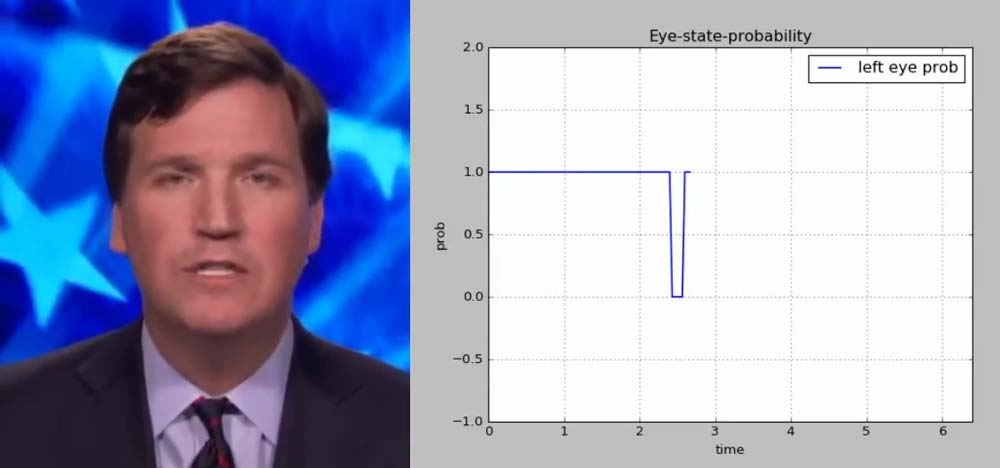

Die Forscher entwickelten auf Basis dieser Erkenntnis eine Anti-Deepfakes-KI, die Augen in Videos erfasst und den Lidschlag zählt. Sie trainierten ihre KI mit vielen Bildern von Menschen mit geöffneten und geschlossenen Augen.

Bei ersten Testläufen konnte die Gegner-KI Deepfakes-Fälschungen mit einer Verlässlichkeit von 95 Prozent entlarven. Die Forscher räumen allerdings ein, dass dies nur ein Zwischenergebnis sei. Der Wettstreit zwischen Fälschern und Ermittlern sei wie ein Schachspiel. Auch Deepfakes könne mit Fotos von geschlossenen Augen das Blinzeln lernen.

"Menschen, die die Öffentlichkeit mit Fake-Videos täuschen wollen, werden besser darin - und wir und die Tech-Gemeinschaft müssen neue Wege finden, diese Fälschungen zu entlarven", schreiben die Forscher.

Kürzlich stellte Facebook ein KI-System vor, das auf Fotos geschlossene Augen nachträglich öffnen kann.