Für viele Künstliche-Intelligenz-Forscher ist der Schritt von einem Spezialsystem hin zu einem universell anwendbaren Algorithmus wohl der größte vorstellbare Durchbruch. Die Fähigkeit zu Multitasking könnte ein Schritt in diese Richtung sein.

In einem Forschungspapier stellen KI-Forscher von Googles Deepmind ein neues Multitasking-Verfahren für maschinelles Lernen vor. Durch dieses kann ein einzelnes, vorkonfiguriertes KI-System eigenständig lernend eine Sammlung verschiedener Aufgaben lösen anstatt nur eine einzelne Aufgabe.

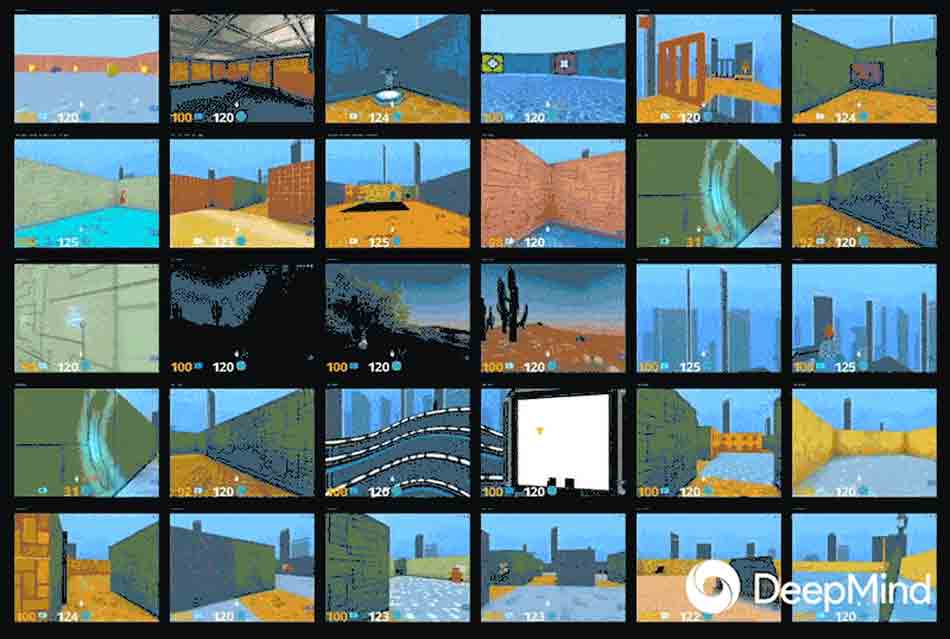

Die Forscher ließen die Künstliche Intelligenz bis zu 57 speziell fürs KI-Training optimierte Videospiele gleichzeitig spielen, mit dem Ziel, dass sie in einem Spiel erlangtes Wissen auf ein anderes überträgt und so insgesamt im Verhältnis zur Datenmenge und Trainingsdauer effizienter lernt. Das System funktioniert so ähnlich, wie wenn das Wissen von 57 Computer-Spielern in einem zentralen Gehirn aufgefangen und verarbeitet würde.

Laut Deepmind ist der Multitasking-Ansatz ein Erfolg: Das Transferlernen soll bis zu zehn Mal effizienter funktionieren als herkömmliche Lernverfahren und bei fast linearer Daten- und Ressourceneffizienz auf tausende Systeme skalieren können. Algorithmen könnten so zukünftig schneller und effizienter trainiert werden. Die Forscher erwarten, dass das Multitasking-Lernen Forschung an "neuen Herausforderungen" ermöglicht.