Deepminds "Force Prompting" bringt physikalische Kräfte in KI-generierte Videos

Ein Forschungsteam aus Brown University und Deepmind zeigt, dass Videomodelle physikalisch plausible Bewegungen erzeugen können. Dafür reichen künstlich erzeugte Trainingsdaten.

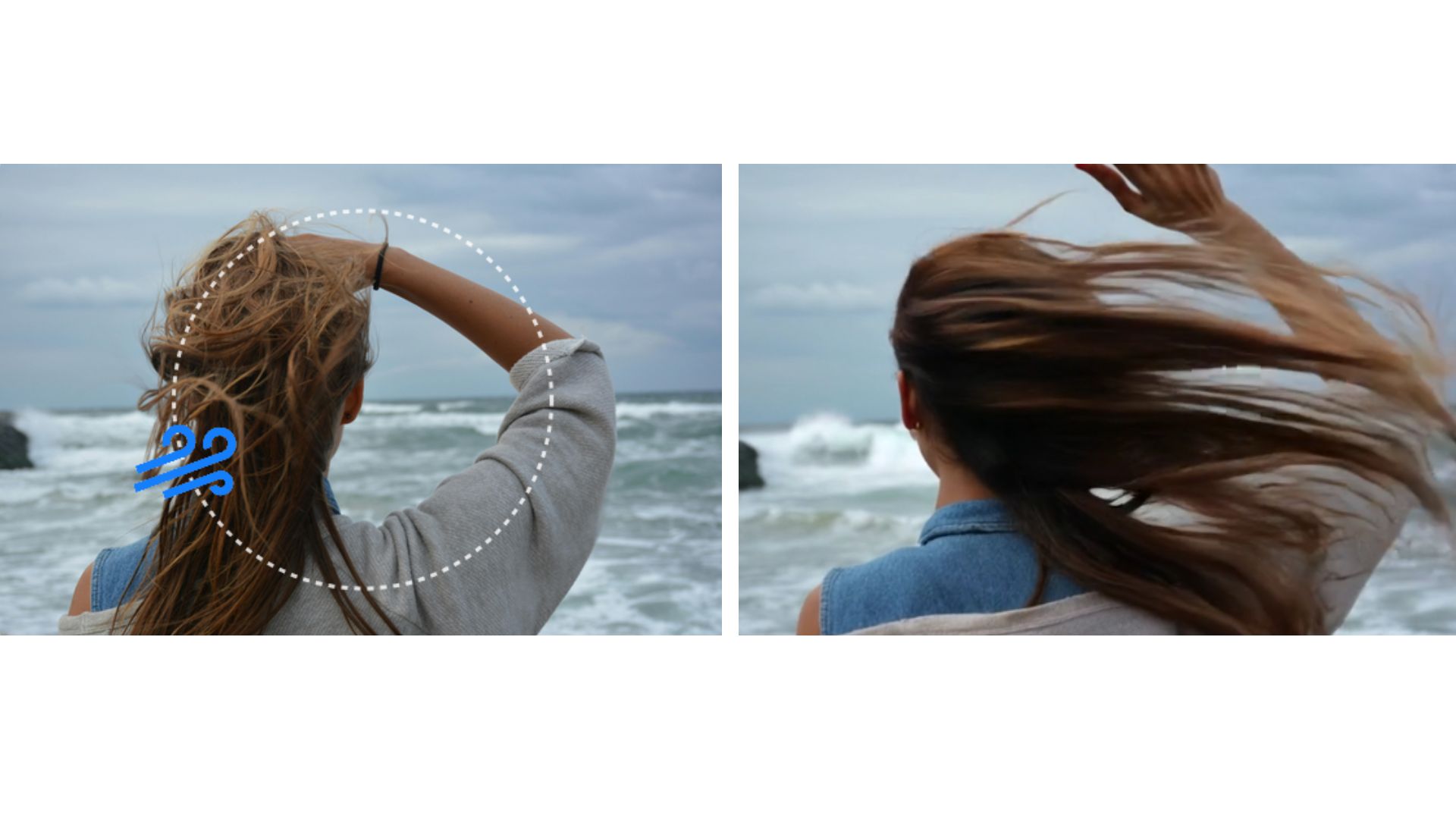

Mit dem sogenannten "Force Prompting" lassen sich generative Videomodelle durch physikalische Impulse wie Wind oder punktuelle Stöße steuern. Das System erzeugt daraus Bewegungssequenzen, die für menschliche Beobachter:innen realistisch wirken. Dabei kommen weder 3D-Modelle noch Physiksimulatoren zum Einsatz. Die Modelle lernten die gewünschte Reaktion allein durch eine begrenzte Menge synthetischer Trainingsdaten.

Kraftvektoren als Steuerbefehl

Das Modell unterscheidet zwischen globalen Kräften wie Wind und lokalen Kräften wie einem gezielten Stoß. Beide Varianten werden durch Richtung und Stärke beschrieben. Globale Kräfte wirken gleichmäßig auf das gesamte Bild, lokale Kräfte auf einen bestimmten Punkt. Die Steuerinformationen werden als Vektorfeld in das Modell eingespeist und in Bewegung übersetzt. Auf der Projektseite finden sich mehrere interaktive Demos für beide Kraftarten.

Als Basis dient das Videomodell CogVideoX-5B-I2V. Es wurde mit einem ControlNet-Modul erweitert, das die physikalischen Steuerdaten verarbeitet. Diese Signale werden in die Transformer-Architektur eingespeist. Das Modell erzeugt 49 Bilder pro Video und wurde innerhalb eines Tages auf vier Nvidia-A100-GPUs trainiert.

Trainiert mit Flaggen, Bällen und künstlichem Wind

Die Trainingsdaten wurden vollständig synthetisch erzeugt. Für globale Kräfte entstanden 15.000 Videos mit wehenden Flaggen unter variierenden Windbedingungen. Für lokale Kräfte wurden 12.000 Videos mit rollenden Bällen und 11.000 Videos mit durch Stöße bewegten Blumen erstellt. In den automatisch generierten Textbeschreibungen wurden gezielt Begriffe wie Wind oder Blasen verwendet, um die physikalischen Zusammenhänge im Modell zu verankern.

Hier sind drei Flaggen-Szenen bei verschiedenen Windstärken zu sehen. Die Videos sind mit KI generiert. | Video: Gillman et al.

Die Szenen wurden variiert, wobei Farben, Lichtquellen, Hintergründe, Kamerawinkel, Windrichtung und Stoßwinkel zufällig kombiniert wurden. Anschließend wurden die Kräfte von den simulierten 3D-Szenen in zweidimensionale Bildkoordinaten projiziert.

Das Modell verarbeitet ein Eingabetripel aus Text, Startbild und physikalischem Steuerimpuls. Für globale Kräfte wird ein flächendeckendes Vektorfeld erzeugt. Lokale Kräfte werden durch ein sich bewegendes Signal dargestellt, das Richtung, Ort und Stärke der Kraft kodiert.

Intuitive Physik mit wenigen Beispielen

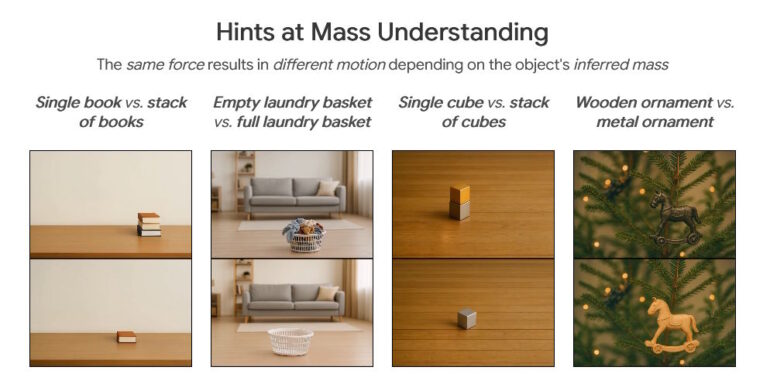

Trotz der begrenzten Datenmenge zeigt das Modell eine bemerkenswerte Generalisierungsfähigkeit. Es überträgt die gelernte Bewegung auf neue Objekte, Materialien und Szenarien. Auch grundlegende physikalische Prinzipien wie das Masseverhalten werden korrekt umgesetzt. So bewegen sich leichtere Objekte bei gleicher Kraft weiter als schwerere.

In Vergleichsstudien bevorzugten Testpersonen die Ergebnisse von Force Prompting gegenüber textbasierten oder bewegungspfadgesteuerten Baselines. Auch im direkten Vergleich mit PhysDreamer, einem Modell mit echter Physiksimulation, schnitt Force Prompting bei Krafttreue und Bewegungseindruck besser ab. PhysDreamer lieferte lediglich eine etwas höhere Bildqualität.

Ablationsstudien zeigen, dass die Vielfalt der Trainingsdaten entscheidend für die Generalisierungsfähigkeit ist. Fehlen Hintergrundvarianten oder zusätzliche Objekte, könne das Modell Kräfte schlechter lokalisieren und Bewegungen nicht zuverlässig trennen. Auch der Verzicht auf kraftbezogene Begriffe in den Texten führte zu deutlich schlechteren Ergebnissen.

Weitere Tests zeigten, dass das Modell gelernt hat, Objekte als Ganzes zu erkennen. Ein Stoß an einer beliebigen Stelle eines Objekts führt dazu, dass es sich komplett bewegte. Auch stilistische Eigenschaften des Ausgangsbilds wie Tiefenschärfe oder Lichtverhältnisse blieben während der Bewegung erhalten.

Realistisch, aber kein Ersatz für echte Simulation

Force Prompting zeigt zwar interessante Ergebnisse, ist laut den Forschenden aber kein Ersatz für präzise physikalische Simulation. In komplexen oder ungewöhnlichen Szenarien komme es zu Fehlern. Beispielsweise bewegte sich Rauch bei Wind nicht oder menschliche Arme verhielten sich wie Stoff. Die Methode liefere jedoch eine effiziente Möglichkeit, physikalisch plausible Interaktionen in KI-generierten Videos zu erzeugen.

Erst kürzlich betonte Deepmind-CEO Demis Hassabis, dass moderne KI-Videomodelle wie Veo 3 zunehmend physikalische Gesetzmäßigkeiten erfassen – ein zentraler Schritt auf dem Weg zur allgemeinen künstlichen Intelligenz.

Laut Hassabis gehen solche Modelle über die bloße Bild- oder Textverarbeitung hinaus, da sie die zugrunde liegende physische Struktur der Welt erfassen und intuitive Physik auf bemerkenswerte Weise modellieren. Für Hassabis deutet dies auf ein tieferes Verständnis der Realität hin. Dieses Realitätsverständnis soll wiederum durch Simulationen ermöglichen, KI-Systeme zu trainieren, die aus Erfahrungen statt nur aus Daten lernen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.