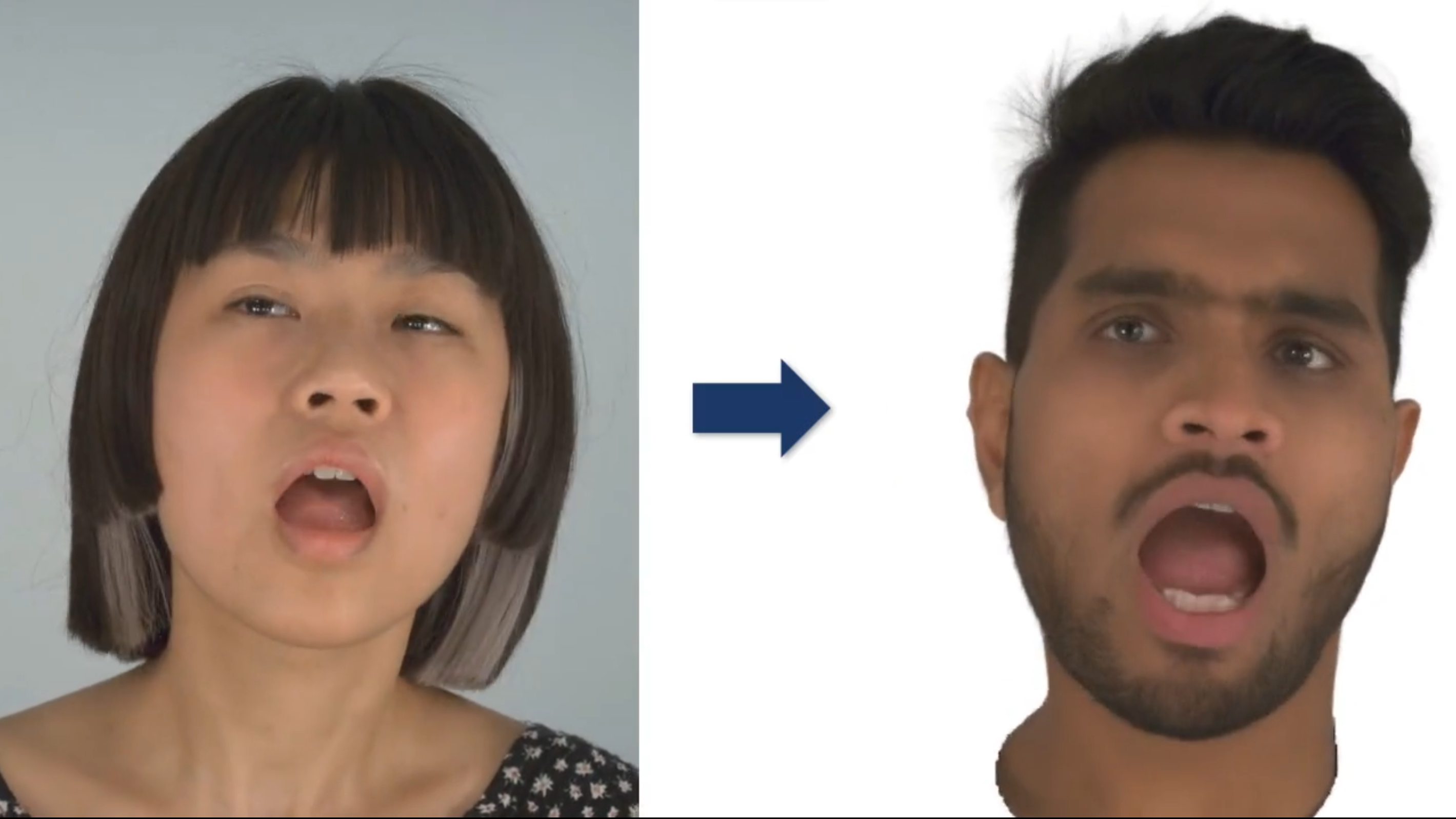

Forschende der Technischen Universität München haben DiffusionAvatars entwickelt, eine Methode, um qualitativ hochwertige 3D-Avatare mit realistischen Gesichtsausdrücken zu erstellen.

Das System wurde mit RGB-Videos und 3D-Meshes von menschlichen Köpfen trainiert. Nach dem Training ist das System in der Lage, Avatare zu animieren, sowohl durch die Übernahme von Animationen aus den Eingabevideos als auch durch die gezielte Generierung von Gesichtsausdrücken über eine einfache Steuerung.

DiffusionAvatars kombiniert die Bildsynthesefähigkeiten von 2D-Diffusionsmodellen mit der Konsistenz von neuronalen 3D-Meshes. Für letztere verwendet DiffusionAvatars das sogenannte "Neural Parametric Head Models" (NPHM), um die Geometrie des menschlichen Kopfes vorherzusagen. Nach Angaben des Teams liefert diese Modelle bessere Geometriedaten als herkömmliche neuronale 3D-Modelle.

DiffusionAvatars hat zahlreiche Anwendungen

Dem Team zufolge generiert DiffusionAvatars zeitlich konsistente und visuell ansprechende Videos für neue Posen und Gesichtsausdrücke einer Person und übertrifft damit bestehende Ansätze.

Die Technologie könnte in Zukunft in verschiedenen Bereichen eingesetzt werden, beispielsweise in VR/AR-Anwendungen, immersiven Videokonferenzen, Spielen, Filmanimationen, beim Sprachenlernen oder als virtueller Assistent. Unternehmen wie Meta und Apple forschen ebenfalls an solchen KI-generierten, realistischen Avataren.

Allerdings hat die Technologie auch ihre Grenzen: DiffusionAvatars bezieht derzeit die Beleuchtung in die generierten Bilder ein und bietet keine Kontrolle über die Belichtungseigenschaften. Dies stellt ein Problem für Avatare in realistischen Umgebungen dar. Außerdem ist die aktuelle Architektur noch rechenintensiv und so aktuell nicht für Echtzeitanwendungen geeignet.

Mehr Informationen gibt es auf der DiffusionAvatars-Projektseite.