DreaMoving: Alibaba zeigt TikTok Generator

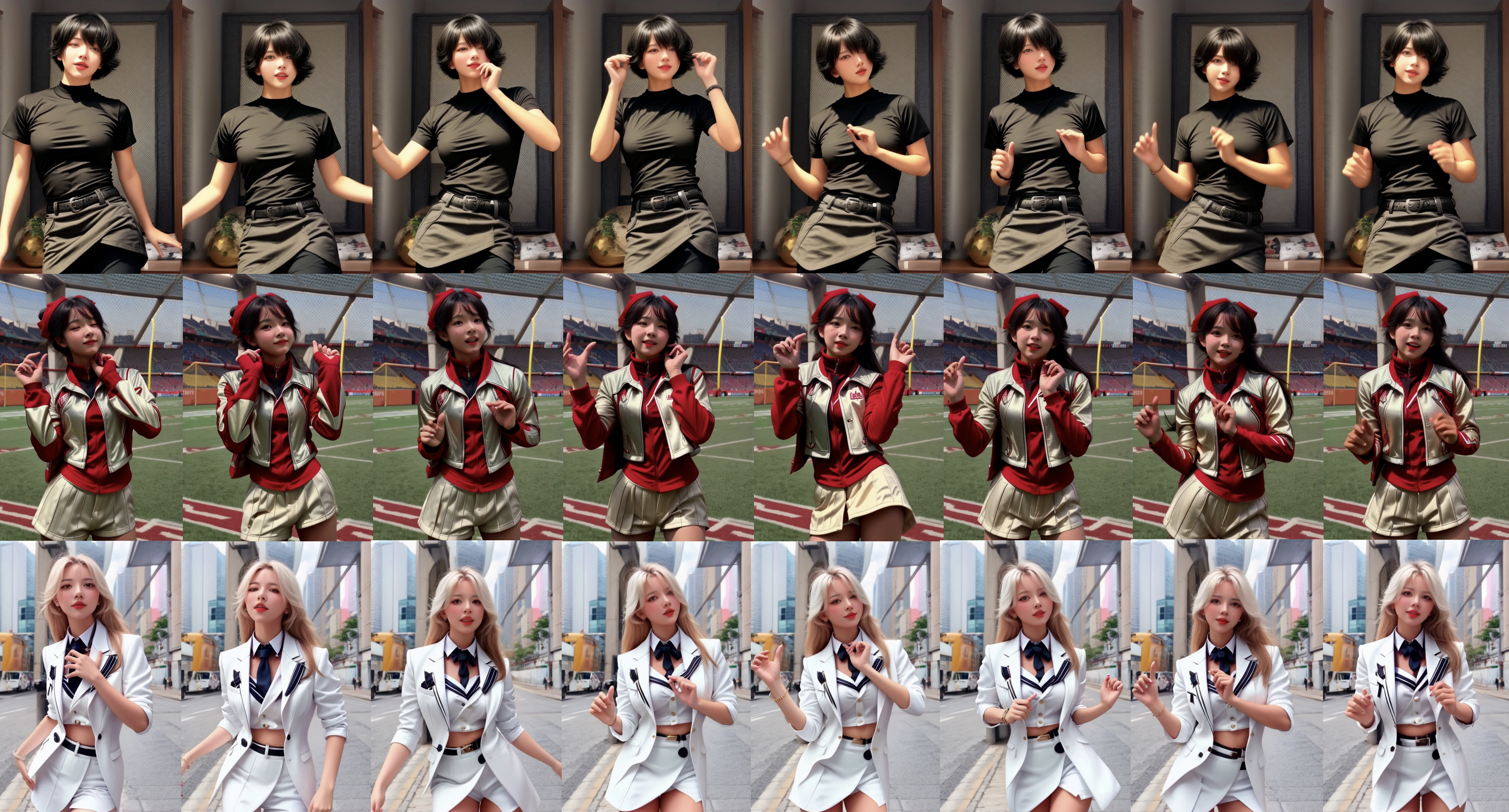

Alibaba zeigt einen neuen TikTok-Generator: DreaMoving kann personalisierte Tanzvideos per Bild- oder Textprompt erstellen.

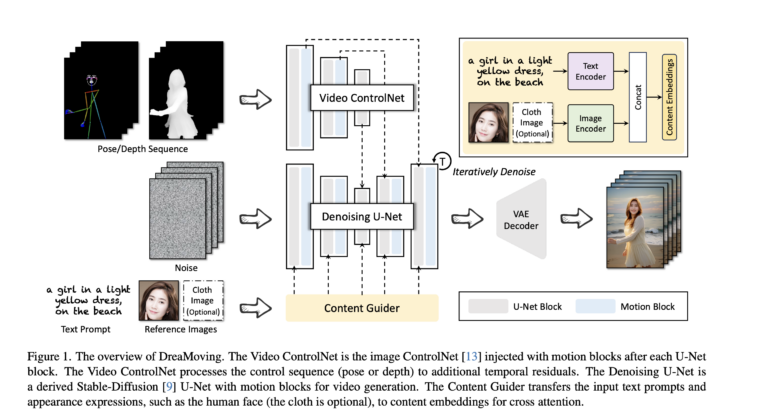

Das System basiert auf Diffusionsmodellen und nutzt unter anderem Video ControlNet und einen Content Guider. Das Video ControlNet steuert die Generierung entlang der vorgegebenen Animation. Der Content Guider ist für die Steuerung des Inhalts der generierten Videos verantwortlich, einschließlich des Aussehens von Personen und Hintergründen.

DreaMoving integriert zusätzlich sogenannte Bewegungsblöcke sowohl in das Denoising U-Net als auch in das ControlNet, um die zeitliche Konsistenz und Bewegungstreue zu verbessern. Benutzer können Text- oder Bildhinweise verwenden, um das gewünschte Aussehen und den Hintergrund des Videos zu steuern.

DreamMoving lernt aus 1.000 Tanzvideos

Das DreaMoving-System wurde mit über 1.000 Tanzvideos trainiert, die in kurze Clips von 8 bis 10 Sekunden Länge unterteilt wurden, um kontinuierliche Bilder ohne Übergänge und Spezialeffekte zu gewährleisten. Die einzelnen Bilder der Clips wurden für das Training zusätzlich mit MiniGPT-v2-Beschreibungen versehen, um das für Text-Steuerung erforderliche multimodale Training zu ermöglichen.

Video: Alibaba

Video: Alibaba

Video: Alibaba

Durch das Training und die angepasste Architektur ist DreaMoving in der Lage, realistische Videos aus Texteingaben, Bildern oder einer Kombination davon zu erstellen. Das System kann so beispielsweise Videos einer bestimmten Person in einem bestimmten Kleidungsstück generieren, die der Benutzer via Bild zur Verfügung stellt.

Video: Alibaba

Neben DreamMoving hat Alibaba kürzlich ein ähnliches System namens Animate Anyone vorgestellt, das Videos von animierten Personen erstellen kann, die nicht nur tanzen. Ein ähnliches System gibt es mit MagicAnimate auch von der TikTok-Firma Bytedance.

Weitere Beispiele und Informationen finden sich auf der Projektseite von DreaMoving. Auf HuggingFace gibt es auch eine Demo, bei der eigene Gesichter und Animationen hochgeladen oder aus einer Vorauswahl ausgewählt werden können.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.