Elevenlabs stellt neue KI-Sprach-Agenten vor

Elevenlabs hat Version 2.0 seiner Conversational AI vorgestellt. Die KI-Agenten können nun gleichzeitig Sprache und Text verarbeiten und sollen natürlichere Interaktionen ermöglichen.

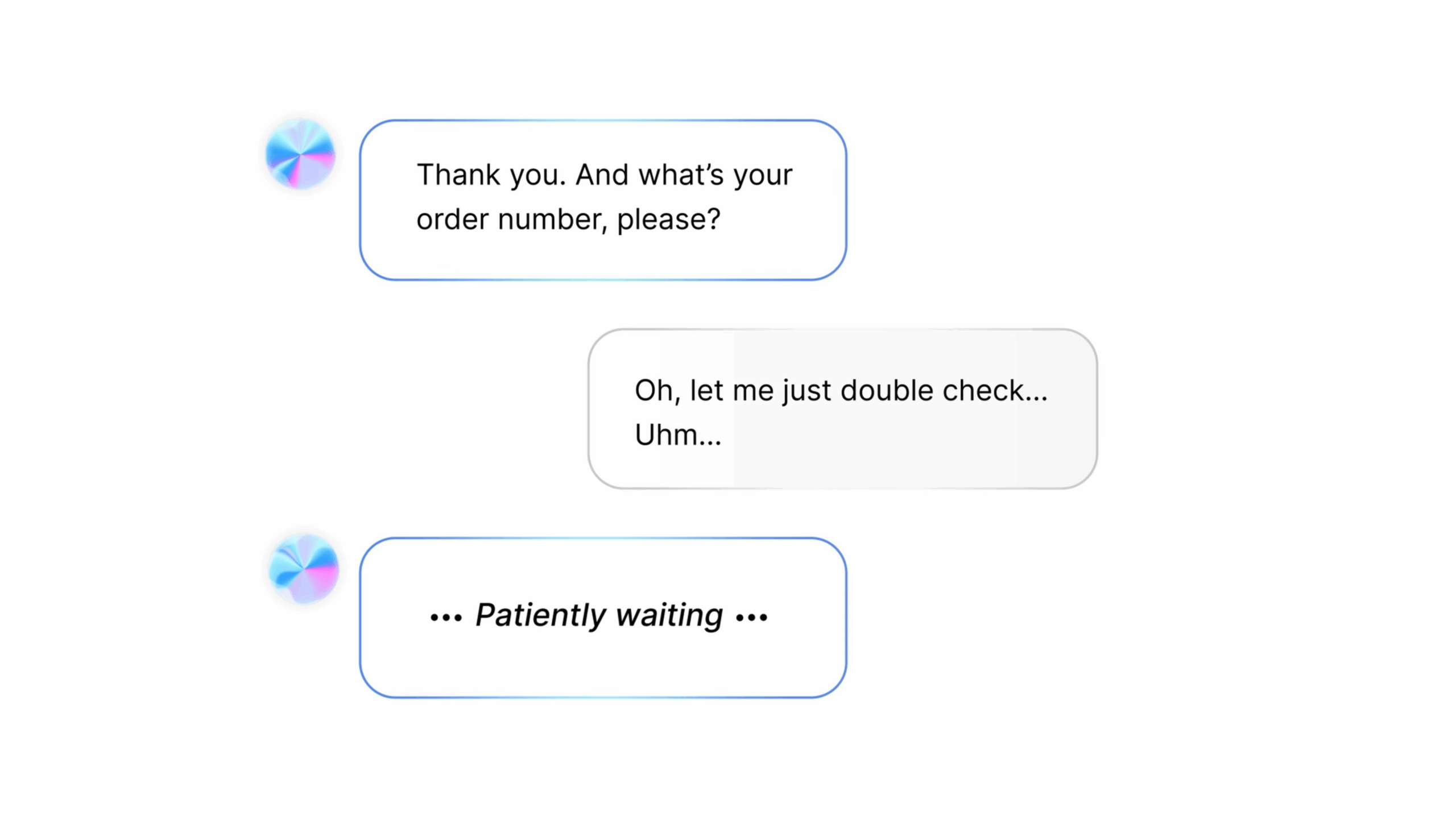

Im Zentrum der Neuerungen steht ein neues Modell für Gesprächsverläufe, das laut Elevenlabs Gesprächszeichen wie Pausen oder Fülllaute wie "um" oder "ah" in Echtzeit analysiert. Ziel ist es, den Gesprächsfluss realistischer zu gestalten. Der Agent erkennt, wann er unterbrechen darf oder besser schweigt, etwa, wenn ein Nutzer kurz innehält, um Informationen zu prüfen oder nachzuschlagen.

Während in der Vorversion noch manuell zwischen Sprachen gewechselt werden musste, erkennt die neue Plattform automatisch die gesprochene Sprache und antwortet entsprechend. Das ermöglicht durchgängige Gespräche in mehreren Sprachen innerhalb einer einzigen Interaktion.

Gleichzeitig unterstützt das System nun auch multimodale Kommunikation: Agenten können über Sprache, Text oder beides gleichzeitig mit Nutzern interagieren. Laut Elevenlabs führt diese Fähigkeit zu flüssigeren Dialogen, insbesondere in Situationen, in denen Benutzer zwischen Sprache und Text wechseln oder beides kombinieren.

KI-Agenten mit spezifischem Unternehmenswissen

Eine weitere Kernfunktion ist die Integration von Retrieval-Augmented Generation (RAG) direkt in die Voice-Agent-Architektur. Dies ermögliche den Zugriff auf spezifische Unternehmensdatenbanken mit "minimaler Latenz und maximaler Privatsphäre", heißt es in der Ankündigung.

Als Anwendungsbeispiele nennt Elevenlabs medizinische Assistenten, die Behandlungsrichtlinien abrufen, oder Support-Agenten mit Zugriff auf aktuelle Produktinformationen.

Laut Elevenlabs ermöglicht eine einheitliche Agentendefinition, dass Dialogverhalten, Wissenszugriff und Kommunikationskanäle zentral gesteuert werden können. Dadurch lassen sich Kundenserviceprozesse leichter automatisieren und die Nutzererfahrung verbessern.

Mit dem neuen Feature "Batch Calling" können Unternehmen automatisierte Massenanrufe durchführen – etwa für Warnmeldungen, Umfragen oder personalisierte Nachrichten. Die Plattform unterstützt eingehende und ausgehende Anrufe sowie die vollständige Integration in SIP-Trunking-Systeme.

Relevant für Unternehmenskunden dürften die neuen Compliance-Features sein. Version 2.0 ist laut Elevenlabs vollständig HIPAA-konform, was den Einsatz im Gesundheitswesen ermöglicht. Zusätzlich bietet das Unternehmen optional eine EU-Datenresidenz an, um Datensouveränitäts-Anforderungen zu erfüllen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.