Entwickler nutzen KI-Tools mehr denn je, vertrauen ihnen aber immer weniger

KI-generierter Code ist oft "fast richtig, aber nicht ganz" - eins der größten Problem für Entwickler:innen weltweit. Eine aktuelle Erhebung zeigt, dass viele mehr Zeit mit dem Debugging von KI-Output verbringen als erwartet und bei kritischen Tasks lieber auf menschliche Expertise setzen.

Nur noch 33 Prozent der Entwickler:innen vertrauen der Genauigkeit von KI-generierten Code-Outputs, wie die neue Stack Overflow Developer Survey 2025 zeigt. Im Vorjahr waren es noch 43 Prozent.

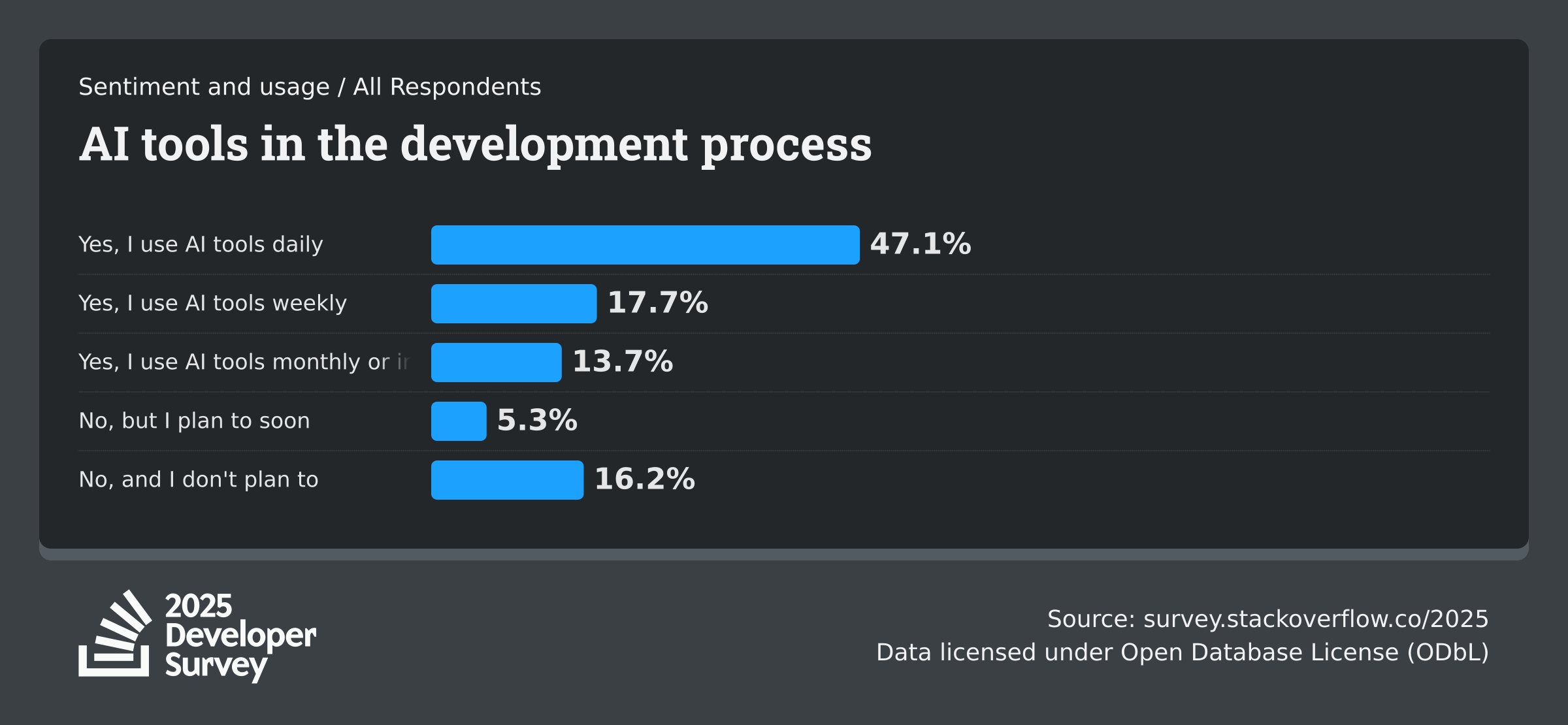

Gleichzeitig steigt die Nutzung weiter an: 84 Prozent der befragten knapp 50.000 Entwickler:innen nutzen KI-Tools oder planen diese einzusetzen; im Vorjahr waren es noch 76 Prozent. Die Grundstimmung sinkt jedoch: 2023 und 2024 waren es noch mehr als 70 Prozent, die KI-Tools positiv gegenüberstanden. 2025 sind es nur noch 60 Prozent.

"Fast richtig" ist das größte Problem

Die Zahlen der Stack-Overflow-Umfrage sprechen eine deutliche Sprache. 46 Prozent der Entwickler:innen misstrauen der Genauigkeit von KI-Tools, während nur drei Prozent den Outputs "hochgradig" vertrauen. Besonders erfahrene Entwickler:innen zeigen sich skeptisch: 20 Prozent von ihnen misstrauen KI-Outputs "hochgradig", während nur rund drei Prozent hochgradiges Vertrauen äußern.

Professionelle Entwickler:innen stehen KI-Tools mit 61 Prozent positiver Einstellung noch etwas optimistischer gegenüber als Anfänger:innen, die nur zu 53 Prozent eine positive Haltung zeigen. Dabei nutzt etwa die Hälfte der professionellen Entwickler:innen KI-Tools täglich, 18 Prozent wöchentlich.

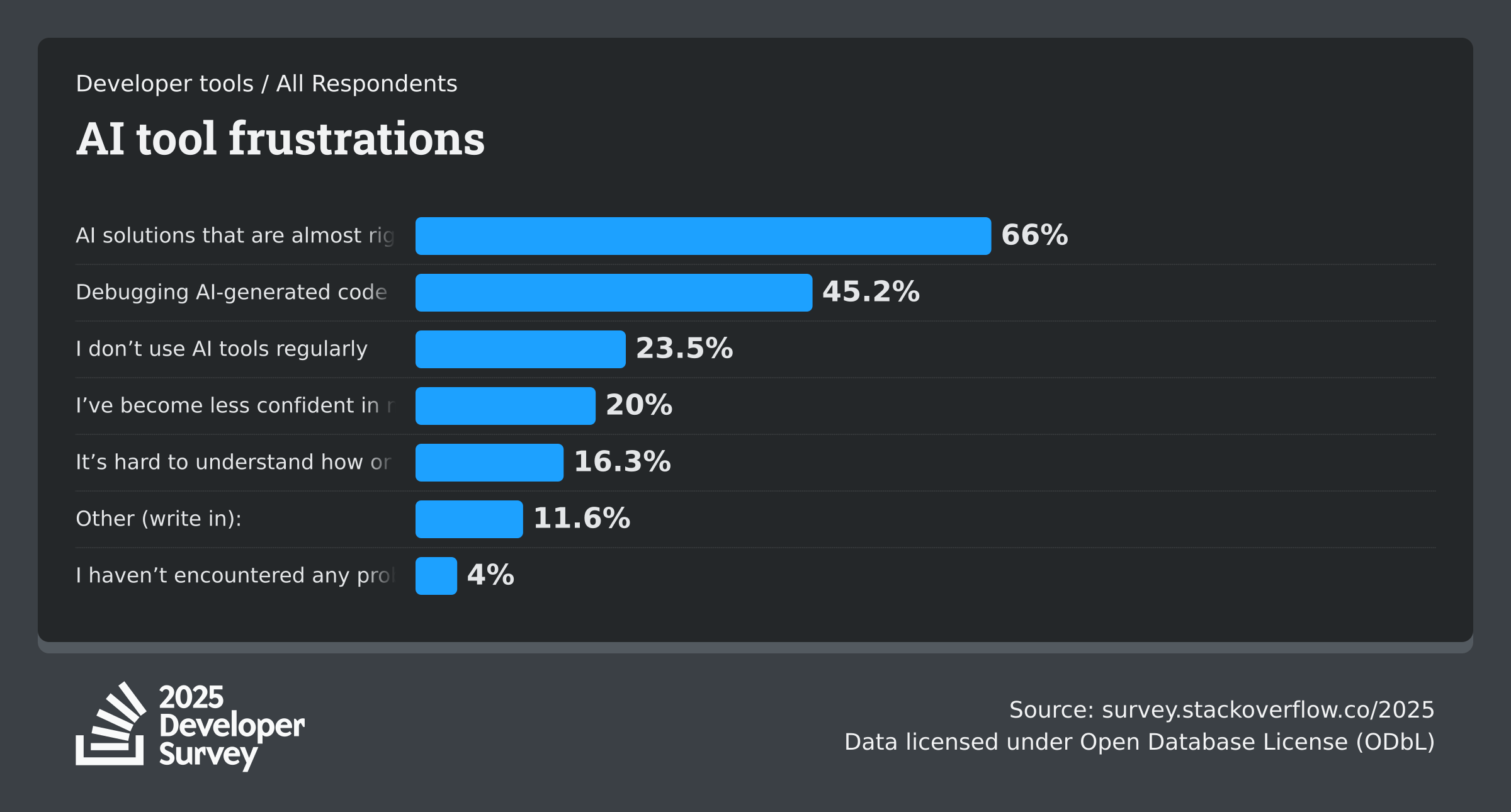

Das Hauptproblem liegt laut 66 Prozent der Befragten bei "KI-Lösungen, die fast richtig sind, aber nicht ganz". Das führt zum zweitgrößten Frustrationspunkt: 45 Prozent berichten, dass sie mehr Zeit damit verbringen, KI-generierten Code zu debuggen als erwartet. 20 Prozent geben an, durch KI-Tools weniger Vertrauen in ihre eigenen Problemlösungsfähigkeiten entwickelt zu haben.

Bei komplexen Aufgaben zeigt sich die Schwäche besonders deutlich. Nur 4,4 Prozent der Entwickler:innen attestieren KI-Tools eine sehr gute Performance bei komplexen Tasks, während 17,6 Prozent die Leistung als "sehr schlecht" bewerten. Weitere 22 Prozent bezeichnen KI-Tools als "schlecht" bei der Lösung komplexer Aufgaben.

Widerstand bei kritischen Aufgaben

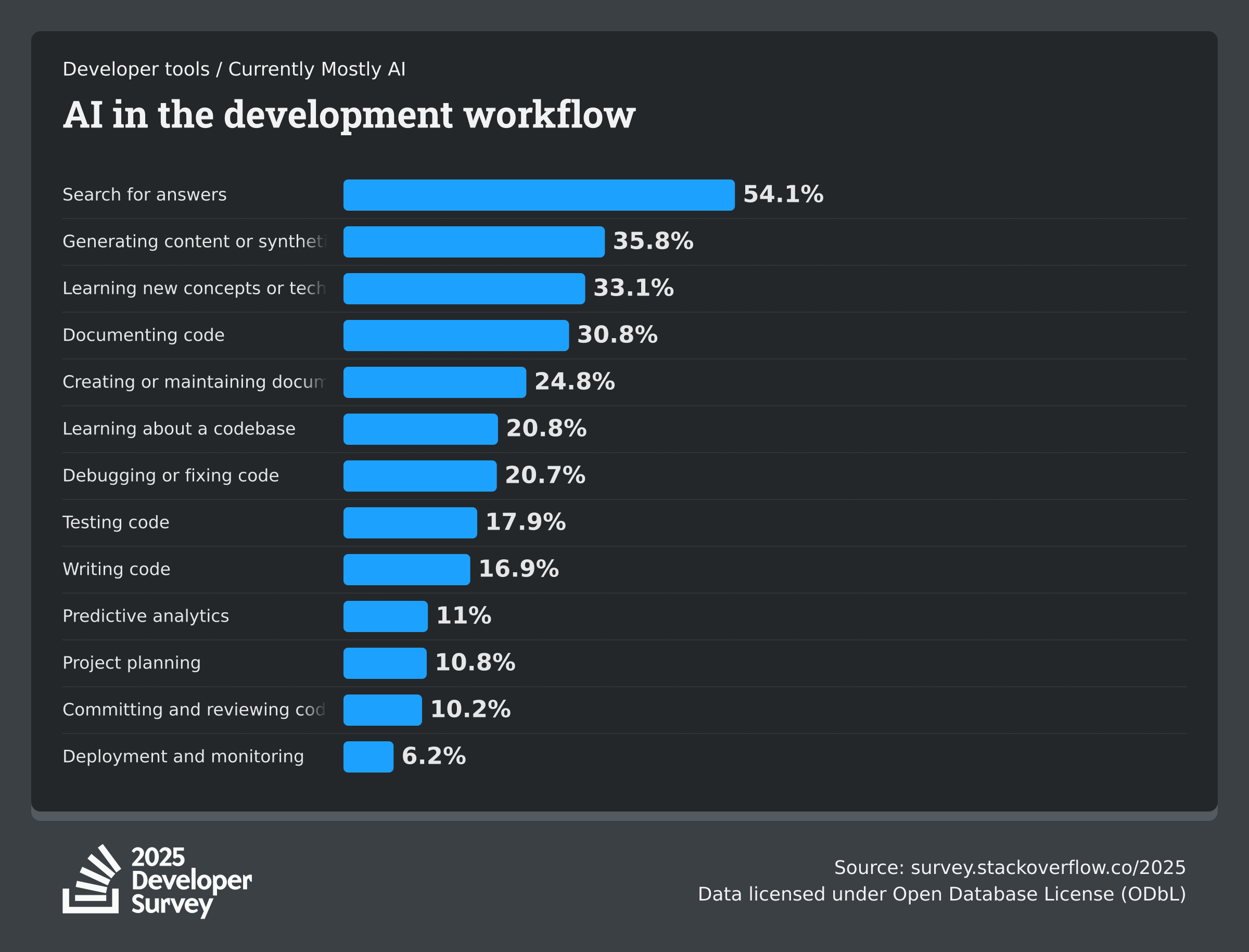

Die Skepsis zeigt sich besonders bei systemkritischen Aufgaben. Laut der Umfrage planen 76 Prozent der Befragten nicht, KI für Deployment und Monitoring einzusetzen. Bei der Projektplanung wollen 69 Prozent auf KI verzichten. Auch wenn es darum geht, Code zu committen und zu reviewen, zeigen sich viele zurückhaltend.

Die Bereiche, in denen Entwickler:innen KI am ehesten einsetzen oder einsetzen wollen, betreffen weniger kritische Tätigkeiten, etwa um nach im Internet nach Antworten zu suchen, synthetischen Content zu generieren, Code zu dokumentieren oder Dokumentationen zu warten oder erstmals eine neue Codebasis kennenzulernen.

KI-Agenten bisher nicht im Mainstream

Die Umfrage zeigt auch, dass KI-Agenten bisher nicht im Mainstream angekommen sind. 52 Prozent der Entwickler:innen nutzen entweder keine Agenten oder bleiben bei einfacheren KI-Tools. 38 Prozent planen nicht, KI-Agenten einzubinden, während nur 14 Prozent sie täglich einsetzen.

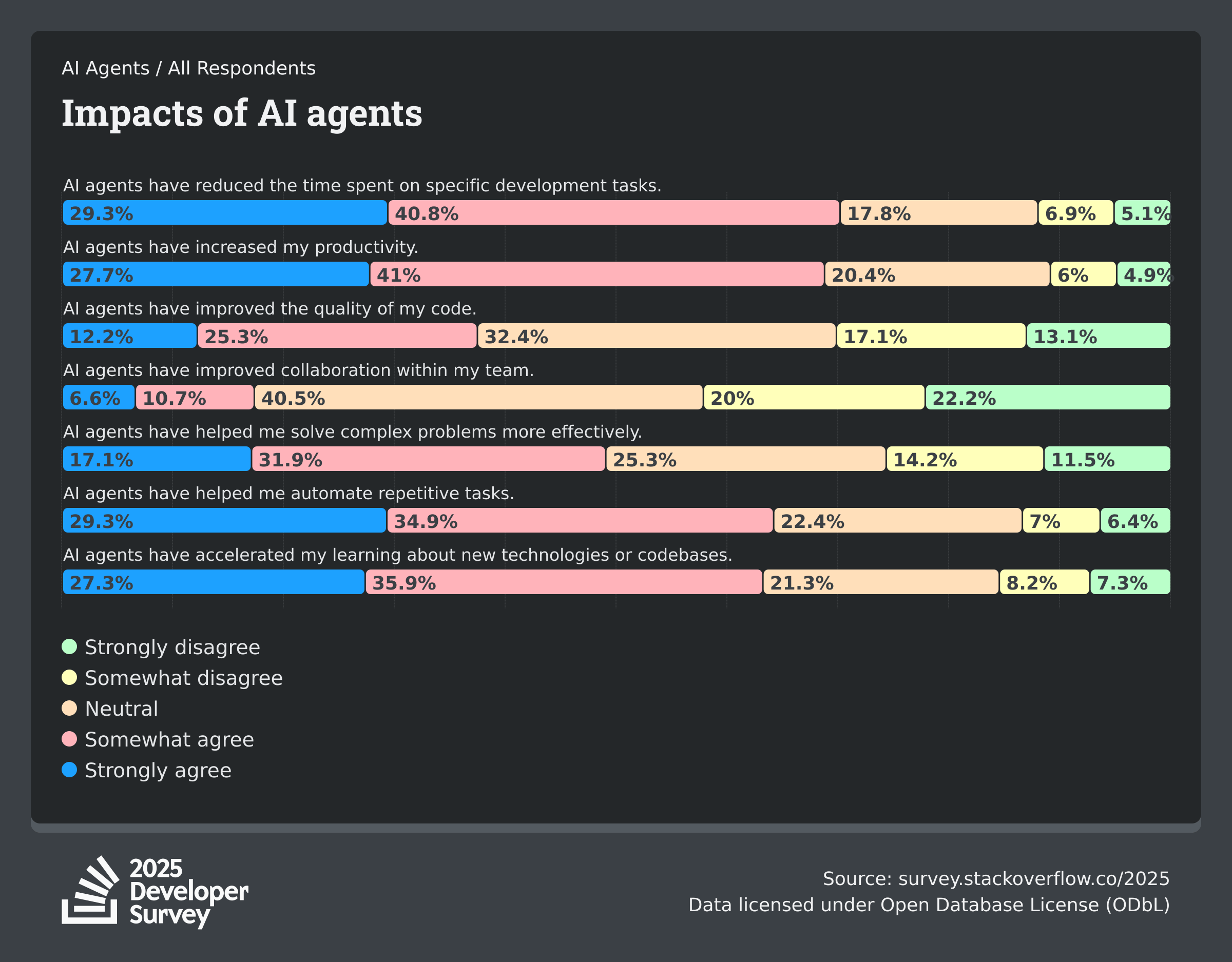

Wer Agenten nutzt, berichtet von Vorteilen: 70 Prozent der Nutzer:innen sagen, dass Agenten dabei helfen, Zeit für spezifische Entwicklungsaufgaben zu reduzieren, 69 Prozent berichten, dass sie ihre Produktivität steigern konnten. Allerdings sehen nur 17 Prozent, dass sich die Zusammenarbeit im Team verbessert hat.

Die Bedenken bleiben groß: 87 Prozent aller Befragten sorgen sich um die Genauigkeit der Informationen, die Agenten bereitstellen, 81 Prozent äußern Sicherheits- und Datenschutzbedenken. Mehr als die Hälfte gibt an, dass die Kosten bestimmter KI-Plattformen sie davon abhalten, diese zu nutzen.

In einer Zukunft mit fortgeschrittener KI würden drei Viertel der Entwickler:innen immer noch einen Menschen um Hilfe bitten, "wenn sie den KI-Antworten nicht vertrauen". 62 Prozent würden bei ethischen oder Sicherheitsbedenken menschliche Expertise suchen, etwa gleich viele, wenn sie etwas vollständig verstehen wollen.

Das sogenannte "Vibe Coding" hat sich bisher nicht durchgesetzt. 72 Prozent der Befragten praktizieren es nicht, weitere fünf Prozent lehnen es ausdrücklich ab. Nur zwölf Prozent antworten mit einem klaren "Ja".

Tool-Landschaft wird von den Großen dominiert

Bei den genutzten Tools dominieren die bekannten Namen: 82 Prozent der Entwickler:innen, die mit KI-Agenten arbeiten, nutzen ChatGPT, gefolgt von GitHub Copilot mit 68 Prozent und Google Gemini mit 47 Prozent. Claude Code verwenden 41 Prozent, Microsoft Copilot 31 Prozent.

Bei den Orchestrierungs-Tools führt Ollama mit 51 Prozent, gefolgt von LangChain mit 33 Prozent. Um KI-Agenten zu überwachen und abzusichern, setzen 43 Prozent auf Grafana und Prometheus, 32 Prozent auf Sentry.

52 Prozent der Entwickler:innen berichten, dass KI-Tools und Agenten ihre Produktivität positiv beeinflusst haben. 16 Prozent sagen, die Tools hätten ihre Entwicklungsarbeit "in großem Ausmaß" verändert, weitere 35 Prozent berichten von "etwas" Veränderung.

Nach wie vor bleibt Coding einer der spannendsten Bereiche, in denen generative KI spürbare Auswirkungen hat. Hersteller wie OpenAI und Google verbessern ihre Modelle stetig für genau diesen Anwendungsfall und bringen Agenten auf den Markt, die eigenständig Änderungen an Projekten vornehmen können.

Wer über die letzten Jahre Sprachmodelle jedoch nur punktuell zum Programmieren verwendet hat, bei dem könnte sich ein veraltetes Bild der tatsächlichen Fähigkeiten eingebrannt haben. Unternehmen stehen nun vor der großen Herausforderung, einerseits das verlorene Vertrauen marketingtechnisch zurückzugewinnen, andererseits ihre Modelle jedoch auch so weit zu verbessern, dass sie im Alltag einen echten Unterschied machen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.