Europas KI-Dilemma: Zwischen Sicherheitsanspruch und Innovationsbremse

Die Europäische Union hat sich ein ambitioniertes Ziel gesetzt: Mit dem AI-Act will sie einen globalen Goldstandard für künstliche Intelligenz schaffen.

Brüssel sieht sich in der Rolle eines globalen Vorreiters, der einen rechtlichen Rahmen schafft, der weltweit als Referenz dienen soll und die Grundrechte der Bürger schützt. Die Regeln der EU stehen damit in einem fundamentalen Gegensatz zu den Plänen der Trump-Administration, die im Rahmen ihres jüngst vorgestellten KI-Aktionsplans plant, zahlreiche bestehende Auflagen abzubauen.

Wie man sich in Europa die praktische Umsetzung des AI-Acts vorstellt, kann in dem zwischenzeitlich veröffentlichten „Code of Practice for General-Purpose AI Models“ nachvollzogen werden. Der Code ist ein freiwilliges, aber rechtlich bedeutsames Instrument, das sich an Anbieter von KI-Modellen richtet und diesen eine Möglichkeit eröffnet, den umfangreichen rechtlichen Anforderungen an diese Angebote aus den Artikeln 53 und 55 des AI-Acts nachzukommen.

Der Kodex implementiert ein zweistufiges Regulierungssystem: Alle Anbieter unterliegen Transparenz- und Urheberrechtsanforderungen, während Anbieter von Modellen mit systemischen Risiken zusätzlichen Sicherheitsbestimmungen unterworfen sind. Wer sich den Regelungen nicht unterwirft, was etwa Meta angekündigt hat, muss eigene Compliance-Regelungen entwickeln und umsetzen.

Dokumentation als Selbstzweck

Inhaltlich bestätigt der Kodex die Kritiker des AI-Acts in vielen Punkten: Denn der Code ist in seiner Ausgestaltung ein Paradebeispiel für eine gut gemeinte, aber schlecht umgesetzte Überregulierung. Er droht, durch exzessive Bürokratie, rechtliche Unsicherheit und unverhältnismäßige Dokumentationsanforderungen genau das zu verhindern, was er fördern soll: eine florierende, innovative und global wettbewerbsfähige KI-Landschaft in Europa.

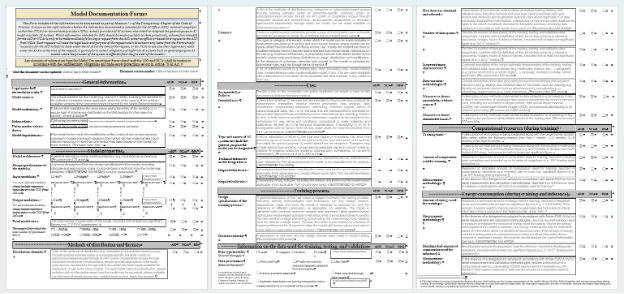

Der Kodex selbst ist in drei Teile eingeteilt. Das Transparenzkapitel soll sicherstellen, dass nachgelagerte Anbieter und Behörden ein klares Verständnis von KI-Angeboten erhalten. In der Praxis dürfte es sich jedoch eher als ein Instrument des Mikromanagements manifestieren, das den Aufwand für Entwickler in die Höhe treibt. Das Herzstück des Kapitels ist die „Model Documentation Form“, eine detaillierte mehrseitige Vorlage, die Anbieter ausfüllen müssen.

Besonders aufschlussreich ist die Aufteilung der Informationspflichten. Eine Analyse der Dokumentationsvorlage zeigt, dass viele der am aufwändigsten zu erhebenden Datenpunkte – wie die exakte Parameteranzahl, die detaillierte Trainingszeit oder der genaue Rechenaufwand – exklusiv für das AI Office der Europäischen Kommission und die nationalen zuständigen Behörden bestimmt sind.

Sieg der Urheberrechtslobbyisten

Das Urheberrechtskapitel des Code of Practice, ebenfalls für alle GPAI-Modelle maßgeblich, versucht, den gordischen Knoten im Spannungsfeld zwischen der Notwendigkeit massiver Datenmengen für das KI-Training und dem Schutz geistigen Eigentums zu durchschlagen. Das Ergebnis ist eine Lösung, die diesen Konflikt einseitig zugunsten der Rechteinhaber auflöst und auch nicht zu mehr Rechtssicherheit führen wird.

So widmet sich der Kodex der Frage, wie das Opt-Out eines Rechteinhabers zur Erfassung der eigenen Inhalte durch die KI-Anbieter gestaltet werden muss – ein hochumstrittener Punkt, der auch Gegenstand von Gerichtsverfahren ist. Genannt wird explizt die Verwendung des Robot Exclusion Protocol (robots.txt). Im Übrigen sollen aber auch „state of the art“-Maßnahmen reichen, die bei Rechteinhabern „weitverbreitet“ seien. Was das genau sein soll, bleibt völlig offen und wird die Gerichte noch lange beschäftigen.

Risikominderung für urheberrechtsverletzende Outputs

Für KI-Anbieter noch problematischer ist die Regelung, die von Anbietern verlangt, technische Schutzmaßnahmen zu implementieren, um zu verhindern, dass ihre Modelle urheberrechtlich geschützte Trainingsinhalte „in verletzender Weise reproduzieren“.

Diese Forderung ignoriert die fundamentale Natur moderner KI-Systeme. Zuverlässig zu verhindern, dass ein Modell Fragmente seiner Trainingsdaten reproduziert, ist technisch extrem anspruchsvoll, wenn nicht gar unmöglich, ohne die Leistungsfähigkeit und Kreativität drastisch zu beschneiden. Diese Vorschrift bürdet den Entwicklern eine technische Last und ein kaum kalkulierbares Haftungsrisiko für die unvorhersehbaren Outputs ihrer Modelle auf. Hinzu kommt auch, dass der AI Act eine solche Verpflichtung nicht explizit enthält.

Ein Labyrinth aus Prozessen und Pflichten

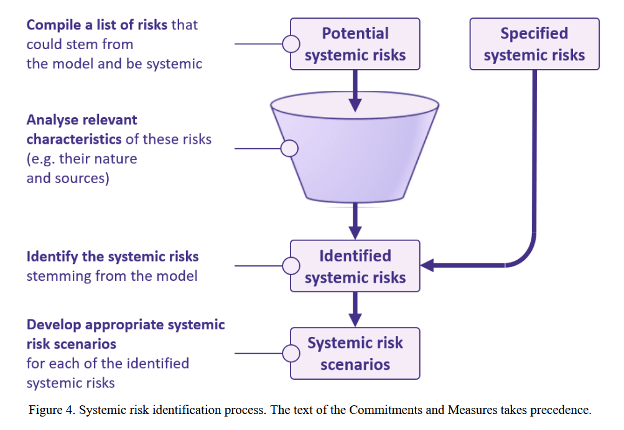

Noch höher hängen die Trauben im Kapitel Sicherheit und Systemrisiken, das sich an die Anbieter der leistungsstärksten KI-Angebote richtet. Wer darunter fällt, ist bisher nicht abschließend geklärt, aber hierzu gehören wohl die aktuellen Modelle von Anthropic, OpenAI, Google, X und Meta, aus Europa möglicherweise Mistral.

Das 40-seitige „Safety and Security Chapter“ bildet das Herzstück des Versuchs, die Risiken dieser leistungsfähigen KI-Modelle zu beherrschen. Dabei konstruiert das Papier ein bürokratisches Labyrinth aus Prozessen, Dokumentationspflichten und vagen Definitionen, das selbst für die großen US-amerikanischen Unternehmen mit einem Heer von Mitarbeitern in den Compliance-Abteilungen eine Herausforderung darstellt. Für KMUs und Start-ups wird hier eine schier unüberwindbare Hürde konstruiert.

So verlangt der erste Passus von jedem Anbieter eines Modells mit systemischem Risiko die Erstellung, Implementierung und kontinuierliche Aktualisierung eines umfassenden "Safety and Security Frameworks". Dieses Framework ist keine einfache Richtlinie, sondern ein komplexes System aus ineinandergreifenden Prozessen. In der Umsetzung dürfte eine Kaskade von Prozessen entstehen, die den gesamten Lebenszyklus eines KI-Systems abdecken, die Ressourcen binden und die Entwicklungsgeschwindigkeit drastisch reduzieren.

"Independent External Evaluators": Eine zusätzliche Hürde

Als wäre die interne Last nicht schon groß genug, verpflichtet der Code die Anbieter zusätzlich, unabhängige externe Gutachter für die Modellevaluierung hinzuzuziehen. Dieser Schritt erhöht nicht nur die Kosten und den Zeitaufwand für die Markteinführung erheblich, sondern wirft auch eine entscheidende praktische Frage auf: Woher soll eine ausreichende Anzahl an hoch qualifizierten und tatsächlich unabhängigen Experten kommen? Auch findet sich eine solche Pflicht zur Einschaltung von externen Gutachtern an keiner Stelle im AI Act.

Ein ernüchterndes Ergebnis

Die Analyse des Kodex führt zu einem ernüchternden Ergebnis: Der gut gemeinte Versuch, eine vertrauenswürdige und sichere KI zu schaffen, hat zu einem bürokratischen Overkill geführt. Die Balance zwischen der Absicherung von Risiken und der Ermöglichung von Chancen ist dabei verloren gegangen.

Europa steht am Scheideweg zwischen seinem Prinzip der „Vertrauenswürdigen KI“ und der harten Realität des globalen Technologiewettbewerbs. Natürlich ist es wichtig, dass KI-Modelle nicht ungezügelt Schaden anrichten oder Rechte verletzen können. Doch der Regulierungsüberschuss – von lückenloser Protokollierung über dauernde Gefahrenfahndung bis zur pedantischen Datenethik – wird dazu führen, dass wichtige KI-Innovationen Europa meiden.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.