Ex-OpenAI-Forscher übt scharfe Kritik an OpenAIs Super-KI-Sicherheit

Jan Leike, ehemaliger Leiter der Abteilung für KI-Ausrichtung und Sicherheit von Superintelligenzen bei OpenAI, übt scharfe Kritik an seinem ehemaligen Arbeitgeber wegen mangelnder Sicherheitsprioritäten und -prozesse.

Jan Leike, bis vor Kurzem Leiter der Abteilung für KI-Ausrichtung und Superintelligenz-Sicherheit bei OpenAI, hat gestern seinen Rücktritt vom Unternehmen bekannt gegeben. Kurz zuvor hatte bereits der renommierte KI-Forscher, Mitbegründer und KI-Sicherheitsguru Ilya Sutskever das Unternehmen verlassen.

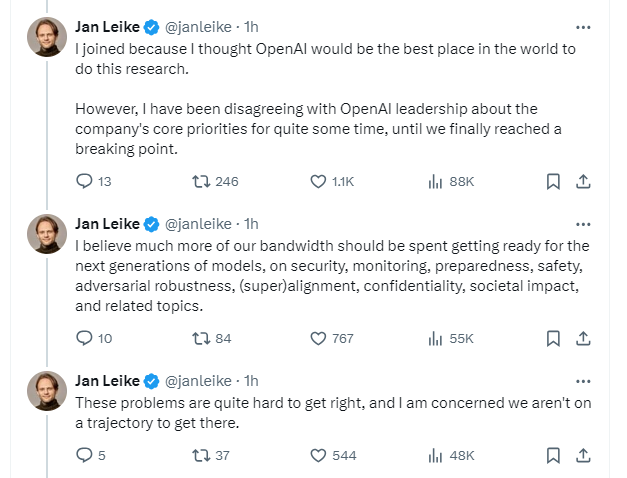

In einem langen Thread auf X übt Leike nun scharfe Kritik an der Sicherheitskultur von OpenAI.

Leike kam zu OpenAI, weil er glaubte, dass es der weltweit beste Ort für KI-Sicherheitsforschung speziell für Super-Intelligenz sei.

Doch schon seit einiger Zeit gab es Meinungsverschiedenheiten mit der Leitung von OpenAI über die Kernprioritäten des Unternehmens, bis schließlich ein Punkt erreicht war, "an dem es nicht mehr ging", so Leike.

Der Sicherheitsforscher ist überzeugt, dass OpenAI viel mehr Rechenbandbreite für die Vorbereitung auf und Sicherheit der nächsten Generationen von KI-Modellen aufwenden müsse.

Bei der Ankündigung des Teams für die Ausrichtung einer Super-KI im letzten Sommer sagte OpenAI, dass es dem Sicherheitsteam 20 Prozent der zu diesem Zeitpunkt verfügbaren Rechenleistung zur Verfügung stellen würde. Offenbar wurde das Versprechen nicht gehalten.

KI-Sicherheit sei eine große Herausforderung und Leike ist besorgt, dass OpenAI nicht auf dem richtigen Weg sei, um dorthin zu gelangen.

"Die Entwicklung von Maschinen, die intelligenter sind als der Mensch, ist ein gefährliches Unterfangen. OpenAI übernimmt im Namen der gesamten Menschheit eine enorme Verantwortung", schreibt Leike.

In den vergangenen Monaten habe sein Team "gegen den Wind gesegelt". Manchmal habe man um Rechenleistung kämpfen müssen. Es sei immer schwieriger geworden, diese entscheidende Forschung durchzuführen.

Sicherheitskultur und -prozesse hinken den "schönen neuen Produkten" hinterher, so Leike. Es sei höchste Zeit, sich intensiv mit den Auswirkungen einer allgemeinen künstlichen Intelligenz auseinanderzusetzen.

Das Ausscheiden von Sutskever und Leike passt zu früheren Gerüchten, dass sich bei OpenAI eine Strömung gegen eine zu starke Kommerzialisierung generativer KI und ein zu schnelles Wachstum entwickelt habe.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.