Explainpaper: GPT-3-App erklärt komplexe Wissenschaft in einfachen Worten

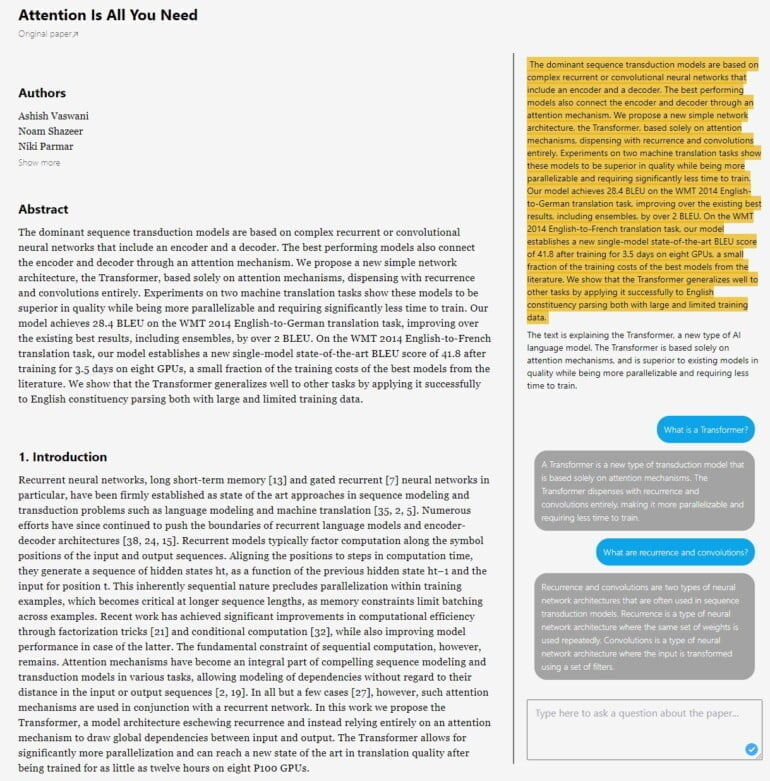

Die GPT-3 basierte Web-App Explainpaper macht genau das, was der Name verspricht: Sie erklärt komplexen wissenschaftlichen Jargon in einfachen Worten.

Die Idee zu Explainpaper hatte Mitentwickler Aman Jha laut eigenen Angaben beim Studium eines komplizierten Papers aus den Neurowissenschaften. Testweise simulierte er per GPT-3-Prompt ein Gespräch zwischen einem angehenden Forscher und einer Expertin zu Brain-Computer-Interfaces.Die dabei von GPT-3 generierten Erklärungen sind leichter zu verstehen als der Forschersprech in der Fachliteratur: "GPT-3 ist der beste Freund eines angehenden Forschers", schreibt Aman Jha daraufhin.

Explainpaper erklärt Paper

Gemeinsam mit seiner Kollegin Jade brachte er die Webseite explainpaper ins Netz. Hier können Nutzer:innen ein Paper hochladen und in einer Weboberfläche einzelne Sätze oder Absätze markieren, die GPT-3 dann verkürzt in anderen, im Optimalfall einfacheren Worten beschreibt. Über eine Chat-Funktion können Nutzer:innen vertiefende Fragen stellen.

Mathematische Funktionen kann die aktuelle Version noch nicht erklären, dieses Feature soll aber nachgereicht werden. Für die Umsetzung verwendet das Team GPT-3 davinci-002 über die Plattform everyprompt. Das GPT-3-Modell soll zukünftig mit mehr als 100.000 explainpaper-Daten feinjustiert werden. Die Daten wurden seit dem Launch der Seite erhoben.

Mehr als 113.000 generierte Erklärungen seit dem Start

Das Konzept kommt gut an: Seit dem Start der Seite im Oktober bis Anfang November generierten mehr als 3.700 Nutzer:innen über 113.000 Erklärungen und luden fast 10.000 Paper hoch.

Einen Haken hat explainpaper jedoch: GPT-3 gibt zum Teil unvollständige Verkürzungen oder schlicht falsche Begründungen und Erklärungen aus. Das kann gerade beim Lernen neuer Informationen ein Problem sein, denn hier fehlt dem Lernenden die Erfahrung, Ungereimtheiten und Fehler zu erkennen.

Jha und Jade wollen diesem Problem mit zwei neuen Funktionen begegnen: Nutzerbewertungen dienen dem System zukünftig als Feedback-Schleife. Zudem soll GPT-3 über eine Vertrauensmetrik anzeigen, wie sicher sich das System bei einer Antwort oder Zusammenfassung ist.

"Es ist möglich, dass GPT-3 eine Antwort generiert, die leicht daneben liegt. Wir stellen sicher, dass die Prompt eine Menge Kontext hat, mit dem wir arbeiten können", sagt mir Jha.

Dass GPT-3 noch im Jahr 2019 existiert, dort endete das Training des großen Sprachmodells, ist laut Jha hingegen "kein allzu großes" Problem: GPT-3 könne die Punkte des Papiers verstehen und nutze sein Hintergrundwissen über die Welt, um neue Erkenntnisse in einfacheren Worten zu erklären.

Das große Ziel des Projekts sei es, mehr Menschen für Wissenschaft zu begeistern. Der Gründer und die Gründerin arbeiten derzeit an einer Pro-Version der Software, die für 10 US-Dollar im Monat einige Komfortfunktionen bringt, etwa das Abspeichern eines Papers samt der markierten Stellen und Erklärungen. Auch der PDF-Reader soll verbessert und das Modell für akkuratere Antworten feingetunt werden.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.