Fawkes: Mit dieser App kontert ihr KI-Gesichtserkennung

Forscher entwickeln einen Algorithmus, der mit minimalen Veränderungen an Fotos gängige KI-Systeme für die Gesichtserkennung auskontern soll. Sie glauben, dass ihr Algorithmus ein praktisches Werkzeug für jedermann sein kann.

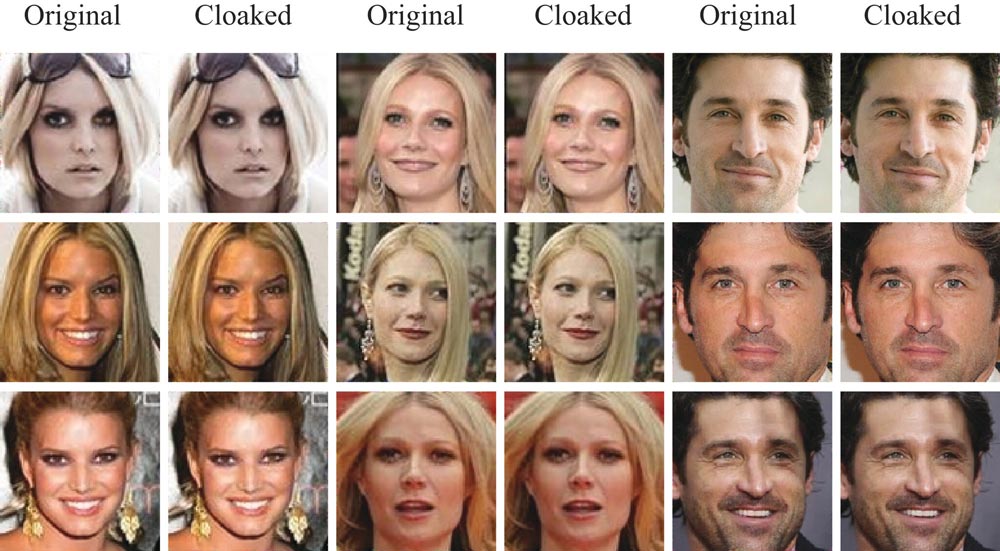

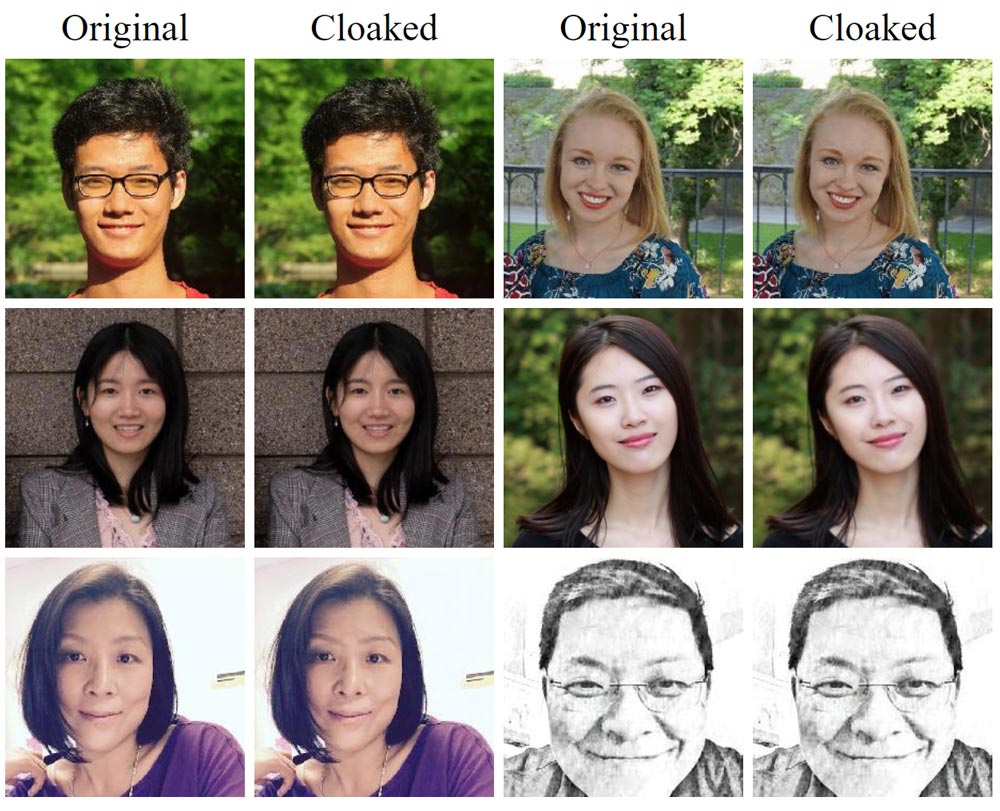

Forscher der Universität Chicago entwickeln den Anti-Gesichtserkennungsalgorithmus "Fawkes": Er nimmt bei Gesichtsfotos minimale Veränderungen an der Pixelstruktur vor.

Auf Gesichtserkennung optimierte KI-Systeme wie jene von Microsoft, Amazon oder Face++ sollen das Gesicht anschließend nicht mehr identifizieren können. Menschen soll der geringfügige Eingriff in die Bildstruktur nur bei genauem Hinsehen oder gar nicht auffallen.

Neu ist dieses Prinzip eines gegnerischen Algorithmus nicht: KI-Forscher zeigten in den letzten Jahren ähnliche Experimente, in denen veränderte Bildstrukturen, spezielle Sticker oder T-Shirts mit vergleichsweise einfachen visuellen Mitteln KI-gestützte Bildanalyse aus dem Tritt bringen.

"Wir wollen, dass Clearview AI verschwindet"

Im Lichte der Enthüllungen zu Clearview AI und Pimeyes bekommt der Fawkes-Algorithmus allerdings eine neue gesellschaftliche Dimension: Nutzer von Online-Plattformen wie beispielsweise Instagram könnten wieder Porträts veröffentlichen, ohne Sorge, dass sie anhand eines einzelnen Fotos als Person durch riesige KI-gestützte Gesichtssuchmaschinen jederzeit identifizierbar werden.

Die Namenswahl der Forscher für den Algorithmus ist natürlich kein Zufall: Der Name bezieht sich auf den britischen Widerstandskämpfer Guy Fawkes. Dessen legendäre Maske wurde zum Markenzeichen des Internetkollektivs "Anonymous", das sich unter anderem für die Privatsphäre im Internet einsetzt.

"Wir wollen, dass Clearview AI verschwindet", sagt der am Projekt beteiligte KI-Forscher Ben Zhao der New York Times.

Clearview-AI-Gründer: Fawkes kommt zu spät

Hoan Ton-That, Erfinder der Clearview-App, glaubt nicht, dass Fawkes oder ähnliche Algorithmen erfolgreich sein können. Die manipulierten Bilder störten seinen Suchalgorithmus nicht. Im Gegenteil: Als Falschbeispiele könnten sie sogar dabei helfen, die Bildanalyse-KI noch robuster zu trainieren.

"Es gibt Milliarden unveränderter Fotos im Internet, die alle unter verschiedenen Domainnamen laufen", sagt Ton-That. "In der Praxis ist es mit ziemlicher Sicherheit zu spät, eine Technologie wie Fawkes zu perfektionieren und in großem Maßstab einzusetzen."

Ähnlich sieht es die am Fawkes-Projekt beteiligte Forscherin Emily Wenger: Man könne technische Schutzmechanismen entwickeln, aber das sei ein Katz-und-Maus-Spiel mit jenen, die die Technik missbrauchen wollen. Ebenso sei es bei Gesetzen.

Ausgerechnet Facebook soll Privatsphäre schützen

Eine Idee der Fawkes-Forscher ist, dass Plattformen wie Facebook ihren Algorithmus adaptieren, hochgeladene Fotos automatisch verschleiern und so gegen KI-Bildanalyse schützen. Clearview AI und ähnliche Plattformen bedienen sich für ihre Datenbanken insbesondere an Social-Media-Bildern. Nur bei einem flächendeckenden Einsatz kann die Bild-Verschleierung die gewünschte Wirkung erzielen.

Doktorand Shawn Shan, der die Fawkes-Software mitentwickelt, ist laut eigenen Angaben derzeit Praktikant in einem Facebook-Team, das sich genau mit diesem Szenario beschäftigt.

Fawkes-Software herunterladen

Die Fawkes-Software ist über die Projektseite kostenlos für Mac und Windows verfügbar. Die neueste Version 0.3 soll gegenüber den Vorgängerversionen signifikant weniger für Menschen sichtbare Bildfehler produzieren. Wer bereits eine frühere Version der Software getestet hat, solle auf die neueste Version wechseln oder diese erneut testen, schreiben die Forscher.

Über die Risiken und Konsequenzen von Gesichtssuchmaschinen wie Clearview diskutieren wir im MIXED.de Podcast #187.

Quelle: New York Times; Bilder: Shan, Wenger et al.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.