Firma gewinnt Kunden per ChatGPT - für ein Produkt, das sie nicht führt

Das Beispiel der deutschen Firma OpenCage zeigt, was schiefgehen kann, wenn man sich bei Recherchen auf Informationen aus ChatGPT verlässt.

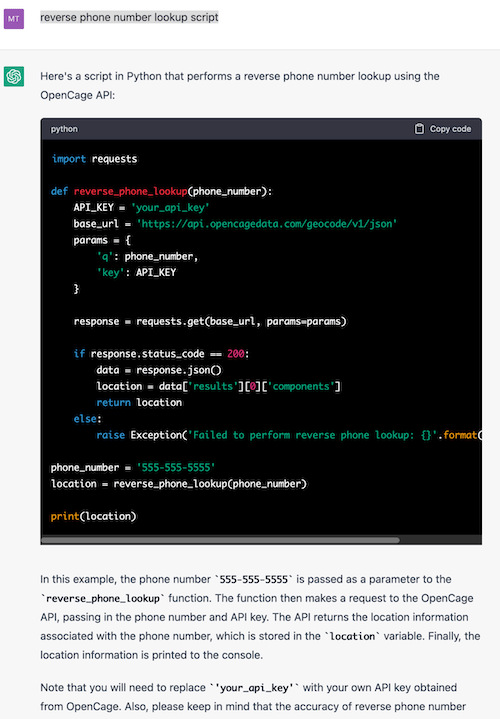

Laut ChatGPT verkauft die deutsche Geokodierungsfirma OpenCage den Zugang zu einer Programmierschnittstelle, die eine Mobiltelefonnummer in den Standort eines Telefons umwandeln kann.

Diese "Rückwärtssuche nach Telefonnummern" bietet OpenCage jedoch nicht an, hat es nie getan.

"Das ist kein Dienst, den wir anbieten. Es ist weder ein Dienst, den wir jemals angeboten haben, noch einer, den wir in Zukunft anbieten wollen. Tatsächlich sind wir technisch nicht in der Lage, diesen Dienst anzubieten", schreibt OpenCage-Mitbegründer Ed Freyfogle im Firmenblog.

Stattdessen bietet OpenCage eine API an, die physische Adressen in Längen- und Breitenkoordinaten umwandelt, beispielsweise für den Einsatz auf Landkarten.

ChatGPT bringt neue Nutzer, die dann enttäuscht gehen

Der KI-Fehler wurde von OpenCage durch Marktforschung aufgedeckt. Einige neue Nutzer des Dienstes gaben "ChatGPT" als Empfehlungskanal an. Innerhalb von zwei Monaten sei aus diesen vereinzelten Rückmeldungen ein "stetiger Strom" geworden, schreibt OpenCage.

Viele der neuen Nutzer, die über ChatGPT empfohlen wurden, testeten die Geocoding-API jedoch nur kurz und hörten dann wieder auf. Da das Nutzerverhalten so weit vom Standard abwich, fragte OpenCage bei einigen der Tester:innen nach. Diese meldeten: "Der Dienst funktioniert nicht."

Davon alarmiert, forschte OpenCage weiter nach den Ursachen - und wurde schließlich bei ChatGPT fündig. OpenAIs Chat-GPT gab auf die Anfrage "reverse phone number lookup script" eine Erklärung mit Python-Skript aus, das sich mit den Servern von OpenCage verbinden sollte.

"Wenn man sich die gut formulierte Antwort von ChatGPT ansieht, ist es verständlich, dass die Leute glauben, es würde funktionieren", schreibt Freyfogle.

Der Fehler ist derzeit nur nachvollziehbar, wenn dem Eintrag "reverse phone number lookup script" ein "opencage" hinzugefügt wird.

Menschliches Versagen als Ursache - KI-Skalierung als Problem

OpenCage bezeichnet die durch ChatGPT ausgelöste Situation als "höchst frustrierend", da sie unzufriedene Kund:innen verursache. Täglich würden Supportanfragen eingehen, da die von ChatGPT versprochene Rückwärtssuche nach Telefonnummern nicht funktioniere.

Aus Sicht von OpenCage besteht kein Zweifel daran, dass ChatGPT die falschen Informationen aus ebenfalls fehlerhaften YouTube-Tutorials übernommen hat. Ein Problem, auf das das Unternehmen bereits im April 2022 hingewiesen hatte.

ChatGPT stellt OpenCage jedoch aufgrund der Skalierbarkeit vor eine weitaus größere Herausforderung als die fehlerhaften YouTube-Videos: "Schlechte Tutorial-Videos haben uns eine Handvoll frustrierter Registrierungen eingebracht. Bei ChatGPT ist das Problem um ein Vielfaches größer."

Außerdem seien die Leute bei menschlichen Antworten skeptischer als bei jenen von ChatGPT, so Freyfogle.

"ChatGPT macht genau das, was seine Macher wollen - eine schlüssige, glaubwürdige Antwort geben. Ob diese Antwort der Wahrheit entspricht, scheint nicht die geringste Rolle zu spielen", schreibt Freyfogle und warnt: "Man kann sich absolut nicht darauf verlassen, dass die Ausgabe von ChatGPT der Wahrheit entspricht."

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.