Forscher identifizieren Schlüsselfaktoren für Reasoning-Fähigkeiten von KI-Modellen

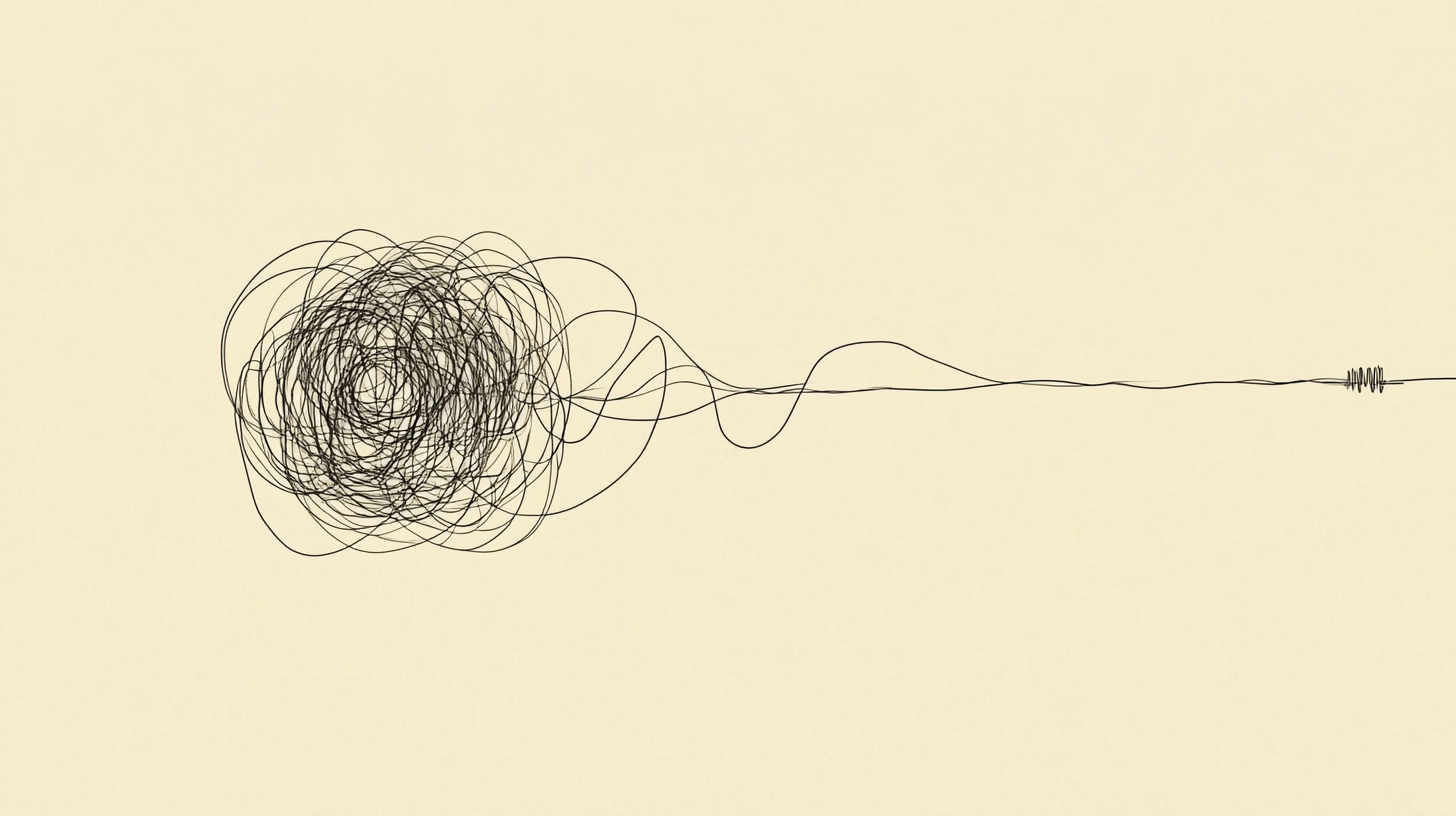

Eine systematische Untersuchung zeigt, durch welche Methoden die langen Gedankenketten der Reasoning-Modelle entstehen. Die Ergebnisse liefern praktische Hinweise für die Optimierung von Trainingsstrategien.

Forscher von IN.AI, der Tsinghua University und der Carnegie Mellon University haben umfangreiche Experimente mit überwachtem Feintuning (SFT) und Reinforcement Learning (RL) durchgeführt, um die Schlüsselfaktoren zu identifizieren, die es den Modellen ermöglichen, solche langen Gedankenketten zu lernen.

Die Studie kommt zu vier Hauptergebnissen: Erstens vereinfacht SFT das Training und verbessert die Effizienz, ist aber nicht zwingend notwendig. Dies bestätigt die Ergebnisse von Deepseks R1-Zero. Das Team verwendete Llama-3.1-8B und Qwen2.5-7B-Math als Basismodelle und trainierten sie mit langen und kurzen Gedankengängen. Die Ergebnisse zeigten, dass SFT mit langen Gedankengängen eine höhere Leistungsgrenze erreichen kann als mit kurzen. Außerdem erleichterte SFT mit langen Gedankengängen weitere RL-Verbesserungen, während kurze Gedankengänge dies nicht taten.

Zweitens: Die Denkfähigkeiten wachsen tendenziell mit zunehmender Rechenleistung während des RL, aber ihre Entwicklung ist nicht garantiert. Die Experimente zeigten, dass die Gedankenlänge unter RL-Training nicht immer stabil wächst. Daher ist die Wahl des Belohnungsdesigns entscheidend für ein stabiles Wachstum der Gedankenlänge.

Drittens ist die Skalierung von verifizierbaren Belohnungssignalen für RL zentral: Das Team untersuchte die Verwendung von Daten mit verrauschten, aus dem Web extrahierten Lösungen, um verifizierbare Belohnungssignale für RL zu skalieren. Sie experimentierten mit dem WebInstruct-Datensatz und verglichen regelbasierte und modellbasierte Verifizierer sowie Prompt-Filter-Methoden. Die Ergebnisse zeigten, dass der regelbasierte Verifier am besten nach der Filterung des Promptsets für kurze Antworten funktioniert. Die Verwendung von verrauschten, aber vielfältigen Daten zeigte besonders großes Potenzial und verbesserte die Leistung in Out-of-Distribution-Benchmarks im Vergleich zu Modellen, die mit annotierten, verifizierten Daten trainiert wurden.

Viertens sind Kernfähigkeiten wie Fehlerkorrektur in den Basismodellen vorhanden, aber sie über RL für komplexe Aufgaben zu hervorzubringen, erfordert erhebliche Rechenleistung.

Größere Modelle könnten komplexere Denkfähigkeit beinhalten

Die Studie deutet darauf hin, dass Anreize für Verhaltensweisen wie das erneute Überprüfen von Lösungen teilweise bereits während des Pre-Trainings erlernt worden sein könnten. Die Forscher fanden Hinweise darauf, dass langes Denken seinen Ursprung im menschlichen Dialog in Internet-Diskussionsforen haben könnte. RL leitet das Modell wahrscheinlich in erster Linie dazu an, bereits während des Pre-Trainings verinnerlichte Fähigkeiten zu rekombinieren.

Die Forscher glauben auch, dass die Modellgröße der Hauptfaktor ist, der die Entwicklung komplexer Denkfähigkeiten in kleineren Modellen einschränkt. Zukünftige Forschung des Teams könnte RL daher mit einem größeren Basismodell untersuchen. Die RL-Infrastruktur sei jedoch im Open-Source-Bereich gerade erst am Anfang.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.