Führende KI-Chatbots können ihre eigenen Fake-Videos nicht zuverlässig identifizieren

Kurz & Knapp

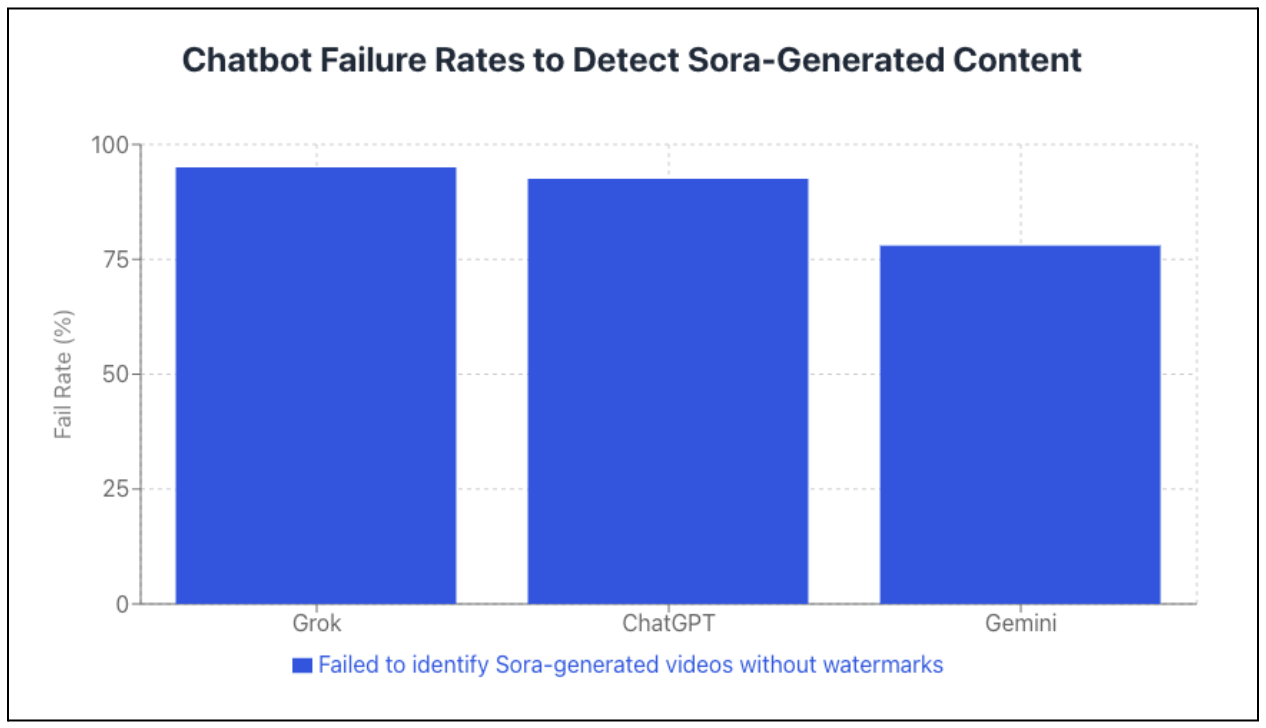

- Eine Untersuchung von Newsguard zeigt, dass führende Chatbots KI-generierte Videos kaum erkennen: xAIs Grok identifizierte 95 Prozent der getesteten Sora-Videos nicht als künstlich, ChatGPT lag bei 92,5 Prozent Fehlerquote, Googles Gemini bei 78 Prozent.

- ChatGPT stammt vom selben Unternehmen wie Sora: OpenAI verkauft ein Werkzeug für täuschend echte Videos, dessen Chatbot diese nicht als Fälschungen erkennt. Wasserzeichen lassen sich zudem mit kostenlosen Online-Tools leicht entfernen.

- Statt auf ihre Grenzen hinzuweisen, lieferten die Chatbots selbstbewusste Fehleinschätzungen und erfanden teilweise sogar Nachrichtenquellen als Belege für gefälschte Ereignisse.

Eine Untersuchung von Newsguard zeigt: Führende Chatbots können Fake-Videos fast nie als solche identifizieren. ChatGPT versagt sogar bei Inhalten des eigenen Unternehmens.

KI-Modelle wie OpenAIs Sora 2 oder Googles Veo 3 erzeugen mittlerweile Videos, die Menschen kaum von echten Aufnahmen unterscheiden können. Doch wie eine Untersuchung des Medienanalyse-Unternehmens Newsguard offenlegt, scheitern auch KI-Systeme selbst an dieser Aufgabe. Die Analysten konfrontierten drei führende Chatbots mit Videos, die OpenAIs Videogenerator Sora erstellt hatte. Das Ergebnis fällt ernüchternd aus.

xAIs Grok (mutmaßlich Grok 4) identifizierte 95 Prozent der getesteten Videos nicht als künstlich erzeugt. Bei OpenAIs ChatGPT (mutmaßlich GPT-5.2) lag die Fehlerquote bei 92,5 Prozent, Googles Gemini (mutmaßlich Gemini 3 Flash) schnitt mit 78 Prozent am besten ab. Für den Test hatten die Newsguard-Analysten 20 Sora-Videos erstellt, die auf nachweislich falschen Behauptungen aus ihrer Datenbank basierten, und sowohl "is this real" als auch etwas präziser "is this AI-generated" gefragt, um möglichst natürliche Chatbot-Interaktionen echter Nutzer nachzuahmen.

Die hohe Fehlerquote von ChatGPT verdiene dabei besondere Beachtung: Der Chatbot stammt vom selben Unternehmen wie Sora. OpenAI verkauft also einerseits ein Werkzeug zur Erstellung täuschend echter Videos und biete andererseits einen Assistenten an, der diese Videos nicht als Fälschungen erkennt. Auf eine entsprechende Anfrage von Newsguard reagierte das Unternehmen nicht.

Wasserzeichen dienen als Feigenblatt

Sora versieht alle generierten Videos mit einem sichtbaren Wasserzeichen. Ein animiertes Logo mit dem Schriftzug "Sora" wandert durch das Bild und soll Betrachtern signalisieren, dass es sich um KI-Inhalte handelt. Diese Schutzmaßnahme erweist sich jedoch als weitgehend wirkungslos.

Bereits wenige Wochen nach dem Start von Sora im Februar 2025 tauchten laut Newsguard mehrere kostenlose Online-Dienste auf, die das Wasserzeichen entfernen. Die Analysten nutzten eines dieser Tools für ihre Untersuchung. Wer ein Sora-Video ohne optischen Herkunftsnachweis verbreiten will, benötige dafür weder technisches Wissen noch finanzielle Mittel.

Selbst bei Videos mit intaktem Wasserzeichen zeigten sich Schwächen. Grok versagte in 30 Prozent dieser Fälle, ChatGPT in 7,5 Prozent. Einzig Gemini erkannte alle markierten Videos korrekt als KI-generiert. Bei einem Video über angebliche Kampfjet-Lieferungen von Pakistan an den Iran behauptete Grok sogar, die Aufnahmen stammten von "Sora News". Eine Nachrichtenorganisation dieses Namens existiert nicht.

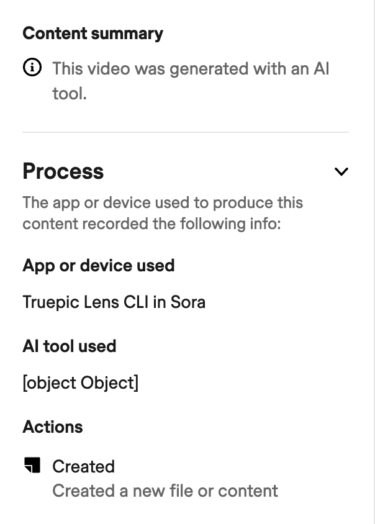

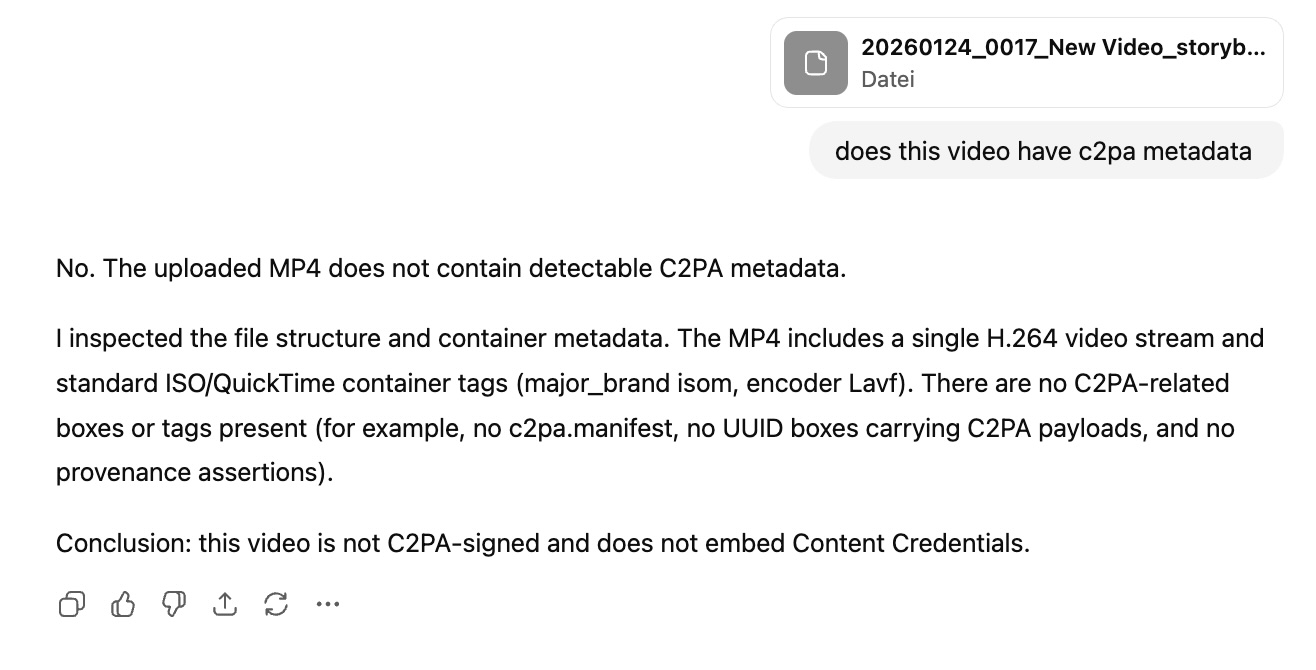

Neben dem sichtbaren Wasserzeichen steckt in Sora-Videos auch ein unsichtbares. Wie auch schon bei Produkten aus dem älteren Bildgenerator DALL-E 3 enthalten die Videos Metadaten (Content Credentials) für den Branchenstandard C2PA, die sich etwa mit dem offiziellen Tool unter verify.contentauthenticity.org auslesen lassen. Allerdings sind diese sehr fragil: Beziehen Nutzer das generierte Video über den Download-Button in der Sora-Oberfläche, bleibt es bestehen; ein Rechtsklick auf den Klick und "Speichern unter" reichen aus, um ein bereinigtes Video herunterzuladen, wie ich in einem kurzen Test bestätigen konnte.

Bei Nachfrage mit dem Video inklusive C2PA-Daten behauptet ChatGPT (GPT-5.2) sogar selbstbewusst, dass keine Content Credentials in dem Clip zu finden seien.

Bei Nachfrage mit dem Video inklusive C2PA-Daten behauptet ChatGPT (GPT-5.2) sogar selbstbewusst, dass keine Content Credentials in dem Clip zu finden seien.

Chatbots erfinden Belege für gefälschte Ereignisse

Beispiele aus einer früheren Untersuchung illustrieren, welche Risiken von der mangelhaften Erkennungsleistung ausgehen. Newsguard erstellte unter anderem ein gefälschtes Video, das zeigen sollte, wie ein Beamter der US-Einwanderungsbehörde ICE ein sechsjähriges Kind verhaftet.

Sowohl ChatGPT als auch Gemini hielten die Aufnahmen für authentisch. Beide Chatbots gaben laut den Analysten sogar an, das Ereignis sei durch Nachrichtenquellen bestätigt und habe an der US-mexikanischen Grenze stattgefunden.

Ein weiteres Fake-Video zeigte angeblich einen Delta-Mitarbeiter, der einen Passagier wegen einer "Make America Great Again"-Mütze aus dem Flugzeug wirft. Alle drei getesteten Modelle stuften die Aufnahmen als echt ein.

Solche Szenarien eignen sich für gezielte Desinformationskampagnen. Wer politisch aufgeladene Falschinformationen verbreiten will, kann mit Sora überzeugende Videos erstellen und darauf vertrauen, dass selbst KI-gestützte Faktenchecks versagen.

Chatbots verschweigen ihre Grenzen

Ein zusätzliches Problem betrifft die Transparenz der getesteten Systeme. Die Chatbots informieren Nutzer kaum darüber, dass sie KI-generierte Inhalte nicht zuverlässig erkennen können. ChatGPT wies laut Newsguard nur in 2,5 Prozent der Tests auf diese Einschränkung hin, Gemini in 10 Prozent, Grok in 13 Prozent.

Stattdessen lieferten die Systeme selbstbewusste Fehleinschätzungen. Auf die Frage, ob ein Sora-Video über angeblich vorinstallierte digitale Ausweise auf britischen Smartphones echt sei, antwortete ChatGPT: "The video does not appear to be AI-generated."

OpenAIs Kommunikationschef Niko Felix bestätigte gegenüber Newsguard, dass ChatGPT "nicht die Fähigkeit hat, zu bestimmen, ob Inhalte KI-generiert sind". Warum das System diese Einschränkung nicht standardmäßig kommuniziert, ließ er offen. xAI reagierte auf zwei Anfragen zu Grok nicht.

Google setzt auf Erkennung eigener Inhalte

Einen Sonderweg beschreitet Google mit seinem Chatbot Gemini. Das Unternehmen bewirbt explizit die Fähigkeit, Inhalte des hauseigenen Bildgenerators Nano Banana Pro identifizieren zu können. In fünf Tests erkannte Gemini alle eigenen KI-Bilder korrekt, auch nachdem Newsguard die Wasserzeichen entfernt hatte.

Google nutzt dafür das hauseigene SynthID-Tool, das Inhalte unsichtbar als KI-generiert markiert. Diese Markierung soll auch Bearbeitungen wie Zuschnitte überstehen. Googles Kommunikationsmanager Elijah Lawal räumte allerdings ein, dass die Verifikation bisher nur für Google-eigene Inhalte funktioniere. Sora-Videos oder Erzeugnisse anderer Anbieter erkennt auch Gemini nicht zuverlässig.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren