"Gehirn auf Chip": Neuer Neuronenprozessor für KI vorgestellt

KI-Anwendungen brauchen häufig viel Rechenleistung und Energie. Dank eines neuen Fertigungsverfahrens lässt sich eine alte Idee endlich umsetzen - und verspricht große Fortschritte bei der KI-Entwicklung.

Als Deepminds KI AlphaGo den weltbesten Go-Spieler Lee Sedol schlug, traten 1.920 Prozessoren und 280 Grafikkarten gegen ein menschliches Gehirn an. Wie viel Energie AlphaGo im Spiel genau verbrauchte, ist nicht bekannt. Schätzungen gehen auf Grund der Hardware von bis zu einem Megawatt aus. Sedols Gehirn begnügte sich mit etwa 20 Watt.

Der Vergleich zeigt, wie energiehungrig KI-Systeme sind – besonders, wenn sie auf Standard-Hardware laufen. Mit dem KI-Boom der letzten Jahre hat sich der Bedarf an KI-optimierter Hardware drastisch erhöht. Das Ergebnis sind für KI-Berechnungen optimierte Grafikkarten wie Nvidias Ampere A100 oder KI-Chips wie Googles TPU, die dank integrierter Matrix Multiply Unit viele parallele Operationen gleichzeitig ausführen kann.

Während Googles KI-Chip als eine Art GPU-Abkömmling verstanden werden kann, erkunden Forscher seit Jahrzehnten einen alternativen Weg zu energieeffizienten und leistungsstarken Rechensystemen: Sogenannte neuromorphische Computer, die sich an der Architektur des Gehirns orientieren, sollen in vielen Aufgaben die altbewährte von-Neumann-Architektur ablösen.

Mittlerweile gibt es entsprechende Hardware, etwa das schon 20 Jahre dauernde SpiNNaker-Projekt oder Intels Loihi-Chip, die beide mit gepulsten neuronalen Netzen experimentieren.

Mit Speicher und Widerstand zu mehr Effizienz

Eine weitere – und möglicherweise effizientere – Recheneinheit für KI sind Memristor-Chips. Der Memristor wurde bereits 1971 vom amerikanischen Mathematiker und Computerwissenschaftler Leon Chua beschrieben.

Statt neuronale Netze im Digitalen zu simulieren, bringen Ingenieure künstliche Neuronen – sogenannte Memristoren – direkt auf dem Computerchip unter. Der Name setzt sich aus dem englischen memory (Speicher) und resistor (elektrischer Widerstand) zusammen.

Der Memristor ersetzt andere Transistoren in einem Schaltkreis und ähnelt in seiner Funktionsweise einer biologischen Synapse. Er empfängt Signale von anderen Memristoren in Form von Ionen und sendet diese weiter an den nächsten Memristor.

Das erzeugte Signal variiert dabei je nach Stärke des ursprünglich empfangenen Signals. Damit kann ein einzelner Memristor verschiedene Zustände oder Werte annehmen und speichern. Da diese Funktionsweise an Synapsen im menschlichen Gehirn erinnert, eignet sich der Chip theoretisch besonders gut für KI-Anwendungen.

Aus Theorie wird Praxis

Mehr als 30 Jahre später entstand 2007 die erste stabile Version eines Hardware-Memristors. Der amerikanische Nanotechnologiespezialist Richard Stanley Williams baute ihn aus Titandioxid und Platin für das IT-Unternehmen Hewlett-Packard.

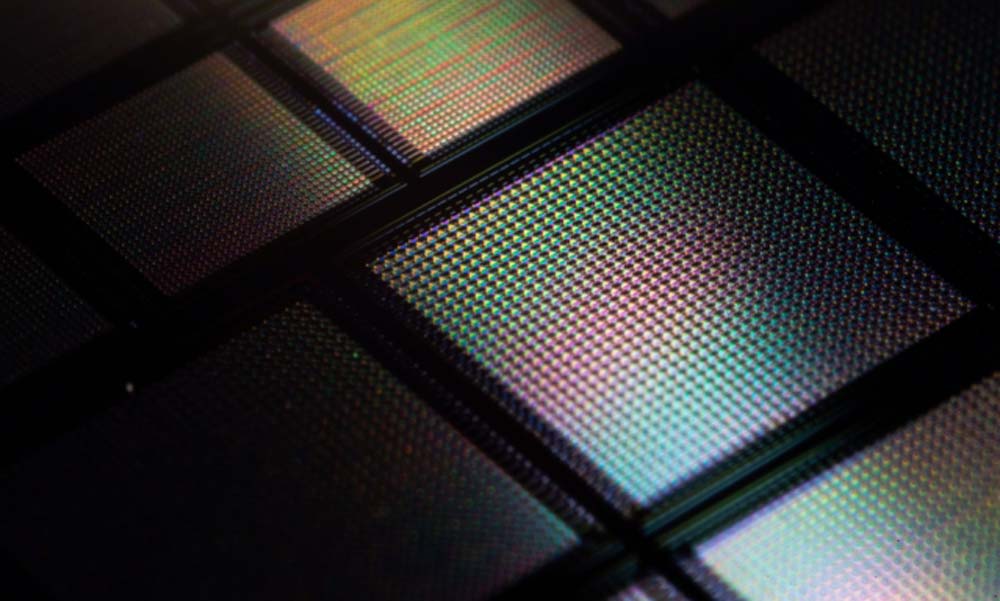

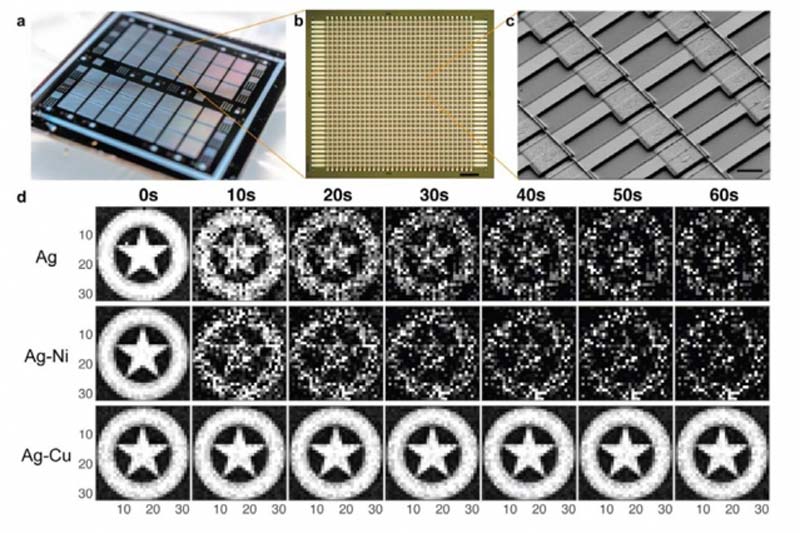

Im Sommer 2019 veröffentlichten Forscher der Universität Michigan den ersten programmierbaren Memristor-Computerchip für KI-Anwendungen. Insgesamt 5.832 Memristoren sind auf dem Chip verbaut.

Forschern des Massachusetts Institute of Technology (MIT) ist nun ein weiterer Fortschritt gelungen: Sie haben eine Methode entwickelt, mit der zehntausende Memristoren auf einen Chip verbaut werden können.

Zehntausende mechanische Synapsen auf einem Chip

Möglich wird dieses "Gehirn auf einem Chip", wie es das MIT beschreibt, durch die Fertigungsmethode Metallurgie: Die Forscher nutzen für die positive Elektrode des Memristors eine Legierung aus Kupfer und Silber. Der Materialwechsel erlaubt es, den Forschern die Chip-Architektur zu schrumpfen, ohne die durch Ionen übertragenen Signale zu verlieren.

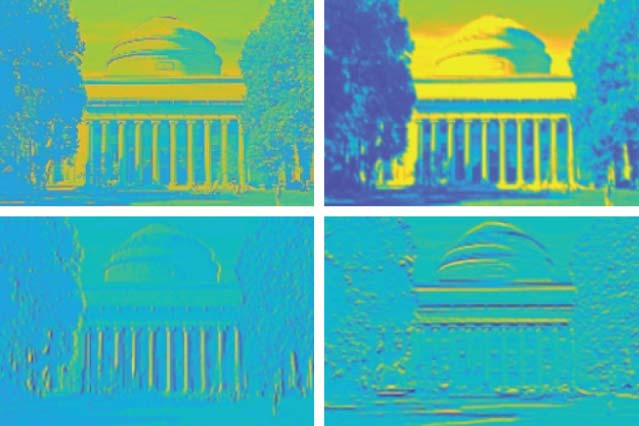

In ersten Test zeigten die Forscher, dass eine kleine Version des Chips einfache Graustufen-Bilder speichern und ausgeben, simple Bildbearbeitung wie Schärfen und Weichzeichnen durchführen und vertikale und horizontale Ränder erkennen kann.

Die Forscher gehen davon aus, dass größere Varianten des Chips mit zehntausenden Memristoren komplexere Bildanalyse-Aufgaben erledigen können. Solche Chips wären noch immer klein genug, um sie in tragbare Geräte wie Smartphones einzubauen, wo sie KI-Anwendungen ohne Cloud-Anbindung lokal ausführen können.

Das könnte etwa autonome Autos unabhängiger machen, meint der beteiligter Forscher Jeehwan Kim: "Stellen sie sich vor, sie verbinden ein neuromorphes Gerät mit einer Kamera in ihrem Auto und die erkennt sofort Objekte, ohne eine Verbindung zum Internet herstellen zu müssen."

Via: Eurekalert, Nature, MIT News; Titelbild: Peng Lin, MIT

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.