Gemini Deep Research: Googles neuer KI-Recherche-Assistent halluziniert im Test

Google hat Gemini Advanced um eine neue Recherchefunktion erweitert. Ein erster Test zeigt Potenzial, aber auch deutliche Schwächen des KI-gestützten Forschungsassistenten.

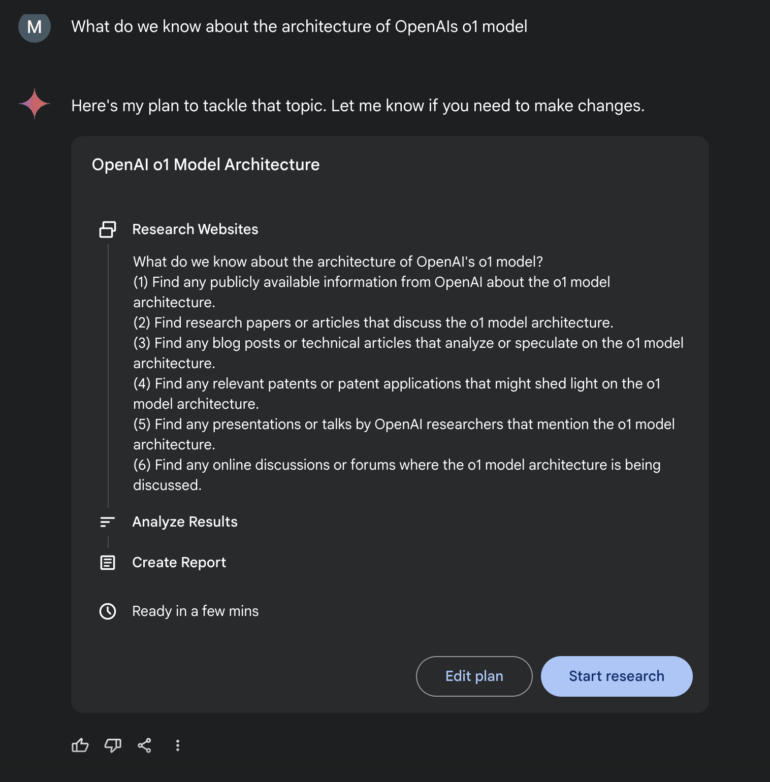

Google hat mit "Deep Research" eine neue Funktion für Gemini Advanced vorgestellt, die tiefergehende Internet-Recherchen über den KI-Assistenten ermöglichen soll. Die aktuell für Gemini 1.5 Pro verfügbare Beta-Funktion plant zunächst eine Recherchestrategie, die Nutzer noch manuell anpassen können.

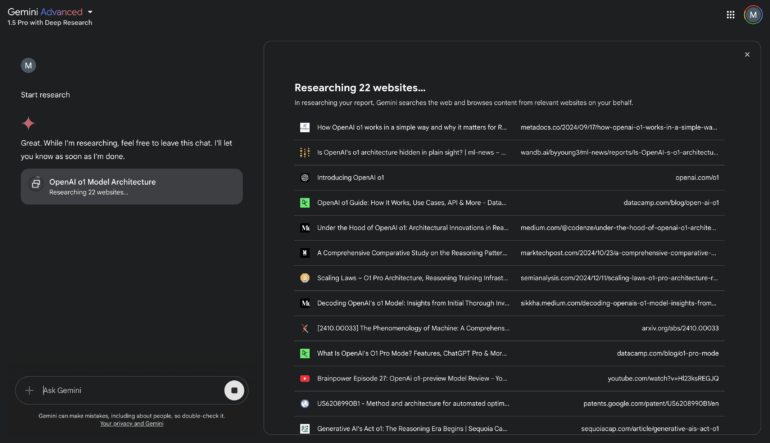

Das System durchsucht anschließend das Internet nach relevanten Quellen, analysiert diese und erstellt einen Bericht mit Zusammenfassungen aller wichtigen Themen inklusive Quellenangaben. Damit positioniert Google seinen Assistenten ähnlich wie Perplexity als KI-gestütztes Recherchewerkzeug.

Praxistest zeigt Schwächen bei der Faktengenauigkeit

In meinem Test sollte das System Informationen über die Architektur von OpenAIs o1-Modell zusammentragen. Gemini entwickelte dafür einen sechsstufigen Rechercheplan, der unter anderem die Suche nach Research Papers, Artikeln, Patenten und Präsentationen von OpenAI umfasste.

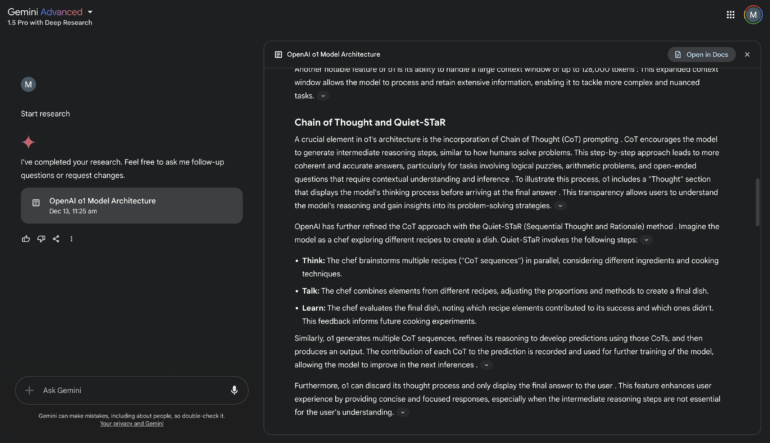

Das System durchsuchte je nach Anfrage zwischen 22 und 70 Webseiten und erstellte einen umfassenden Bericht. Während die Quellenauswahl und die grobe Einordnung bekannter Fakten über das o1-Modell gelangen, zeigten sich in den Details erhebliche Schwächen.

So behauptete das System fälschlicherweise, OpenAI o1 nutze die Quiet-STaR-Methode.

Ein Blick in die zitierte Quelle zeigte jedoch, dass dort lediglich Quiet-STaR als möglicher Ansatz für ein besseres Chain-of-Thought-Training diskutiert wurde. Der Autor betont sogar explizit, dass es sich lediglich um Vermutungen handelt, wie OpenAI o1 trainiert habe.

Nützlich als Quellensammler, problematisch bei Details

Während also Sprachmodelle in bestimmten Bereichen trotz gelegentlicher Halluzinationen eine gute Unterstützung bieten können, zeigt der Test, dass KI-Rechercheassistenten zwar bei der Sammlung relevanter Quellen helfen können, der Aufwand für die notwendige Faktenprüfung aber den Nutzen übersteigen kann.

Best Practices für den effektiven Einsatz dieser Systeme fehlen noch. Nutzer müssen immer damit rechnen, dass die generierten Berichte mit hoher Wahrscheinlichkeit auch Fehlinformationen enthalten. Das weiß auch Google und vermerkt unter dem Chatfenster: "Gemini can make mistakes, including about people, so double-check it."

Gemini 1.5 Pro mit Deep Research ist für Gemini Advanced Abonnenten verfügbar.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.