Google bringt agentische KI-Roboter in die physische Welt

Google Deepmind hat mit Gemini Robotics 1.5 und Gemini Robotics-ER 1.5 zwei neue KI-Modelle vorgestellt, die Roboter dazu befähigen sollen, komplexe Aufgaben in der physischen Welt eigenständig zu planen, zu verstehen und auszuführen.

Die Modelle kombinieren multimodale Wahrnehmung, Sprachverarbeitung und motorisches Handeln mit einer internen Entscheidungslogik.

Erst planen, dann handeln

Gemini Robotics-ER 1.5 übernimmt dabei die Rolle eines hochabstrakten "Gehirns". Es plant Aufgaben, nutzt digitale Tools wie Google Search, kommuniziert in natürlicher Sprache und schätzt den Fortschritt und die Erfolgsaussichten einer Handlung ein. Laut Google Deepmind erzielt das Modell in 15 Benchmarks für verkörpertes Denken, darunter Point-Bench, ERQA und MindCube, durchgehend State-of-the-Art-Ergebnisse.

Die zweite Komponente, Gemini Robotics 1.5, setzt diese Anweisungen in konkrete Bewegungen um. Anders als frühere Vision-Language-Action-Modelle kann es vor dem Handeln nachdenken: Es erstellt interne Argumentationsketten in natürlicher Sprache, plant Zwischenschritte, zerlegt komplexe Aufgaben in ausführbare Segmente und kann seine Entscheidungen erklären. Beispiel: Beim Sortieren von Wäsche erkennt das Modell zuerst das Ziel – etwa "helle Kleidung in die weiße Tonne" – plant dann die Greifbewegung und führt diese aus.

Generalisierung über verschiedene Robotertypen

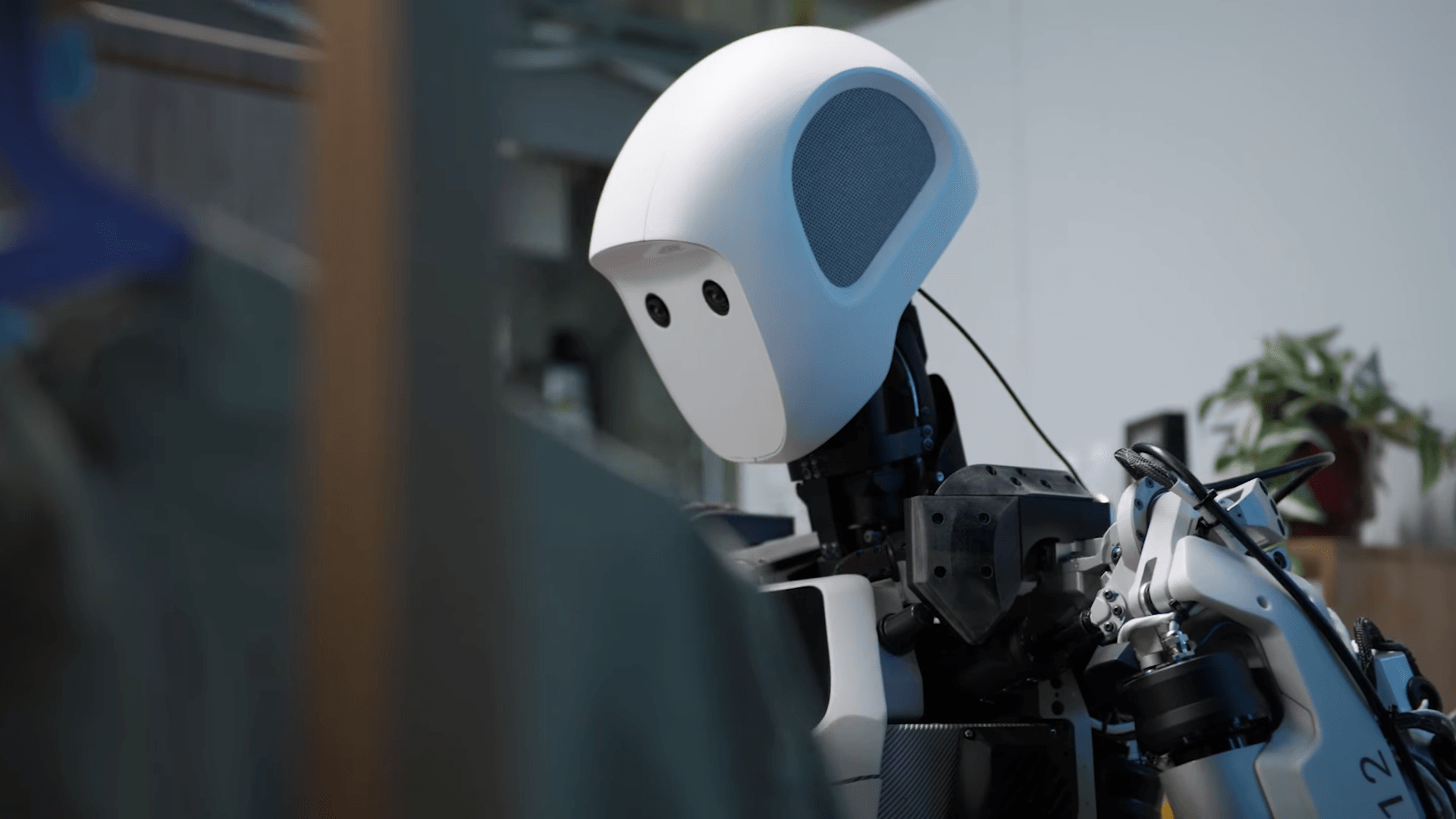

Beide Modelle können über verschiedene Roboterplattformen hinweg generalisieren. Bewegungsmuster, die etwa mit dem ALOHA 2-Roboter trainiert wurden, funktionieren laut Google auch auf humanoiden Systemen wie Apptroniks Apollo oder dem Zweiarm-Roboter Franka – ohne spezielles Finetuning.

Zur Absicherung der neuen agentischen Fähigkeiten hat Deepmind zudem ein Sicherheitskonzept implementiert: Gemini Robotics 1.5 prüft semantisch, ob eine Handlung sicher ist, bevor sie ausgeführt wird, und aktiviert bei Bedarf physische Sicherheitsmechanismen wie Kollisionsvermeidung.

Die Modelle basieren auf der multimodalen Gemini-Modellfamilie und wurden für ihre jeweiligen Aufgabenbereiche speziell weitertrainiert. Gemini Robotics-ER 1.5 ist ab sofort über die Gemini‑API im Google‑AI‑Studio verfügbar, während Gemini Robotics 1.5 vorerst nur ausgewählten Partnern zur Verfügung steht. Weitere technische Details stehen im Entwicklerblog von Deepmind.

Bereits im März 2025 hatte Google mit Gemini Robotics eine Modellfamilie vorgestellt, die multimodales Verstehen für Roboter zugänglich machen sollte. Im Juni folgte mit Gemini Robotics On-Device eine lokal laufende Variante für schnelle Adaption und robuste Geschicklichkeit direkt auf Robotersystemen. Die nun vorgestellten Modelle setzen diesen Weg mit einer stärkeren Planungslogik, Tool-Nutzung und der Fähigkeit, als agentische Systeme zu agieren, fort. Damit folgen sie den Fortschritten, die agentische KI-Systeme am Computer bereits zeigen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.