Google Dreamix: KI-Videoeditor kann eure Teddybären animieren

Der KI-Videoeditor Dreamix von Google kann Videos nach Prompt verändern oder direkt aus einem einzigen Bild neue Videos generieren.

Generative KI-Modelle, die aus Textbeschreibungen Bilder oder Videos generieren, haben im letzten Jahr dank Diffusionsmodellen große Fortschritte gemacht. Nach Bildmodellen wie OpenAIs DALL-E 2, Stable Diffusion und Googles Imagen zeigten die Techriesen Meta und Google wenige Monate später Videomodelle wie Make-A-Video oder Imagen Video.

Doch während neue Methoden wie Prompt-to-Prompt oder InstructPix2Pix etwa Stable Diffusion auch für die Bildbearbeitung einsetzbar machen, sind Videomodelle bisher auf die Synthese beschränkt.

Googles Dreamix ist ein KI-Videoeditor

Forschende von Google zeigen nun Dreamix, einen diffusionsbasierten KI-Videoeditor, der bestehende Videos mit Hilfe von Textbeschreibungen verändern oder neue Videos aus einem Ausgangsbild generieren kann.

Für die Videobearbeitung verrauscht Dreamix die Ausgangsbilder und übergibt sie an ein Video-Diffusionsmodell, das dann aus den verrauschten Ausgangsbildern neue Bilder nach Textvorgabe generiert und zu einem Video zusammensetzt.

Die Ausgangsbilder bieten so eine Art Skizze, die beispielsweise die Form eines Tieres oder seine Bewegungen festhält und gleichzeitig genügend Spielraum für Veränderungen lässt.

Video: Google

Neben der Bearbeitung bestehender Videos kann Dreamix auch neue Videos generieren. Google zeigt zwei Anwendungen: Bei der Videosynthese aus einem Einzelbild werden zunächst durch leichte Veränderungen, z.B. in der Pose des Objektes, weitere Bilder generiert und anschließend auf das Videomodell übertragen.

Video: Google

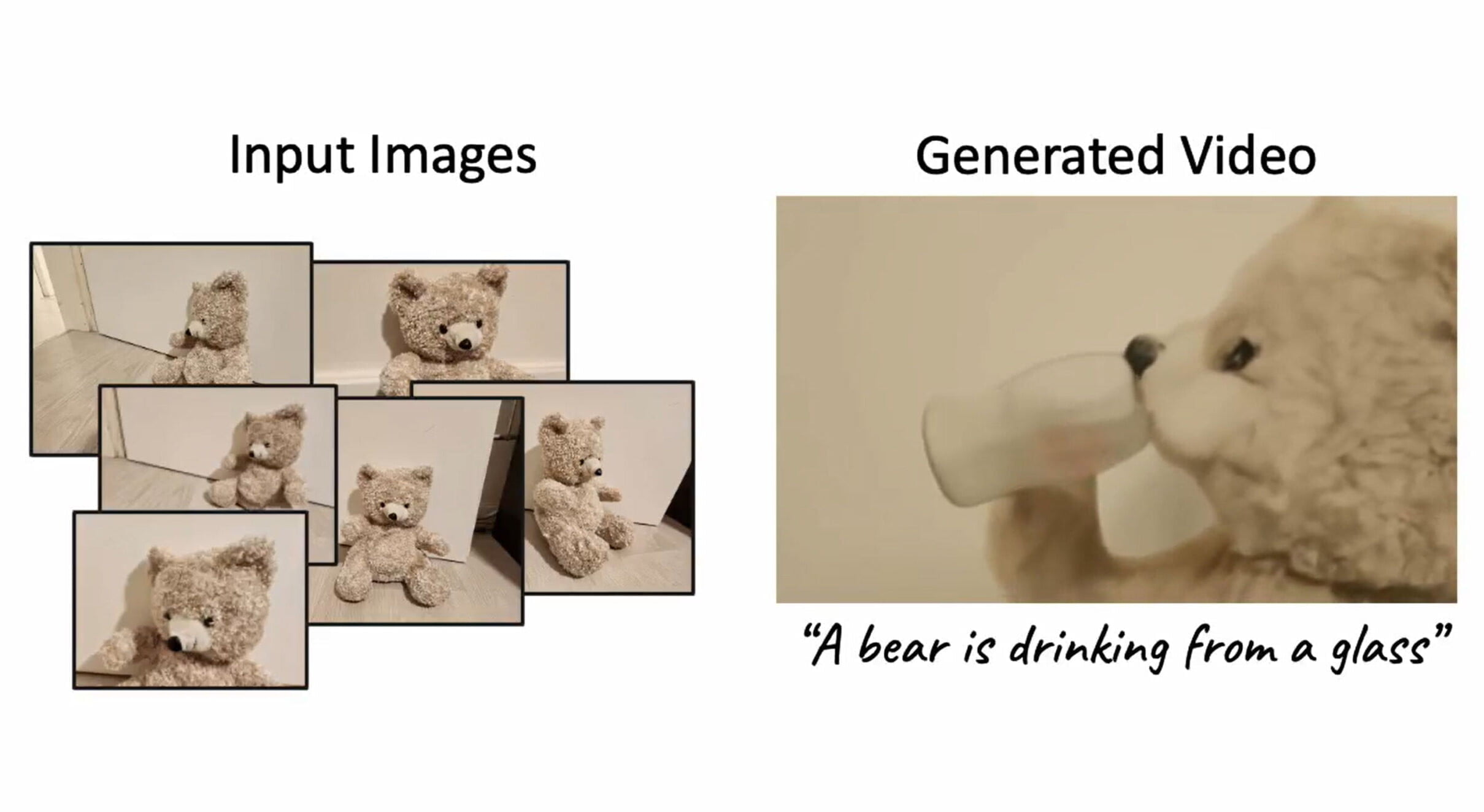

Darüber hinaus kann Dreamix auch subjektbezogene Videos erzeugen, bei denen mehrere Bilder z.B. einer Spielfigur verwendet werden, um ein Video zu erzeugen, in dem die Spielfigur Gewichte hebt.

Video: Google

Google Dreamix legt den Grundstein für ein kommerzielles Produkt

In den Beispielen wird deutlich, dass Dreamix etwa die Themen der Videovorlagen beibehält, eine Straße in einen Fluss verwandelt und diesen realistisch mit den Reifen eines Autos interagieren lässt oder aus mehreren Fotos eines Teddybären ein kurzes Video mit ihm erstellen kann.

Video: Google

Vor allem bei der Modifikation bestehender Videos fällt die durch die Vorlage gewonnene zeitliche Stabilität auf, die bei völlig neu generierten Videos, etwa von Imagen Video, noch ein Problem darstellt.

Neben der zu verbessernden Qualität sieht Google Verbesserungsbedarf bei der benötigten Rechenleistung für die rechenintensiven Videodiffusionsmodelle sowie bei den verwendeten Trainingsdaten und Bewertungsmodellen.

Zentrales Ziel der Arbeit sei es, "die Erforschung von Werkzeugen voranzutreiben, die es den Nutzern ermöglichen, ihre persönlichen Inhalte zu animieren", heißt es in dem Papier.

Durch die Möglichkeit, eigene Videos und Bilder zu verwenden, könnten Nutzer:innen von Dreamix KI-generierte Inhalte trotz der in Diffusionsmodellen vorhandenen Verzerrungen besser an ihren Intentionen ausrichten. Umgekehrt bestünde jedoch auch Potenzial für den Missbrauch solcher Systeme, um Konsument:innen gezielt irrezuführen oder zu belästigen.

Video: Google

Weitere Beispiele gibt es auf der Projektseite von Dreamix. Google plant aktuell keine Veröffentlichung des Modells.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.