Google stellt multimodales KI-Modell Gemini 2.0 mit Fokus auf agentische KI vor

Google DeepMind präsentiert mit Gemini 2.0 ein verbessertes multimodales KI-Modell sowie drei spezialisierte KI-Agenten für Web, Entwicklung und universelle Assistenz, die von den neuen Fähigkeiten profitieren sollen.

Google DeepMind hat die nächste Generation seines KI-Modells vorgestellt. Gemini 2.0 Flash Experimental ist laut Google ab sofort für Entwickler und ausgewählte Tester über die Gemini API in Google AI Studio und Vertex AI verfügbar. Die breite Markteinführung ist für Anfang 2025 geplant.

Die neue Gemini-Version zeichnet sich laut Google durch verbesserte multimodale Fähigkeiten aus: Das Modell kann Text, Bilder, Video und Audio verarbeiten sowie nativ Bilder und mehrsprachige Stimmen generieren.

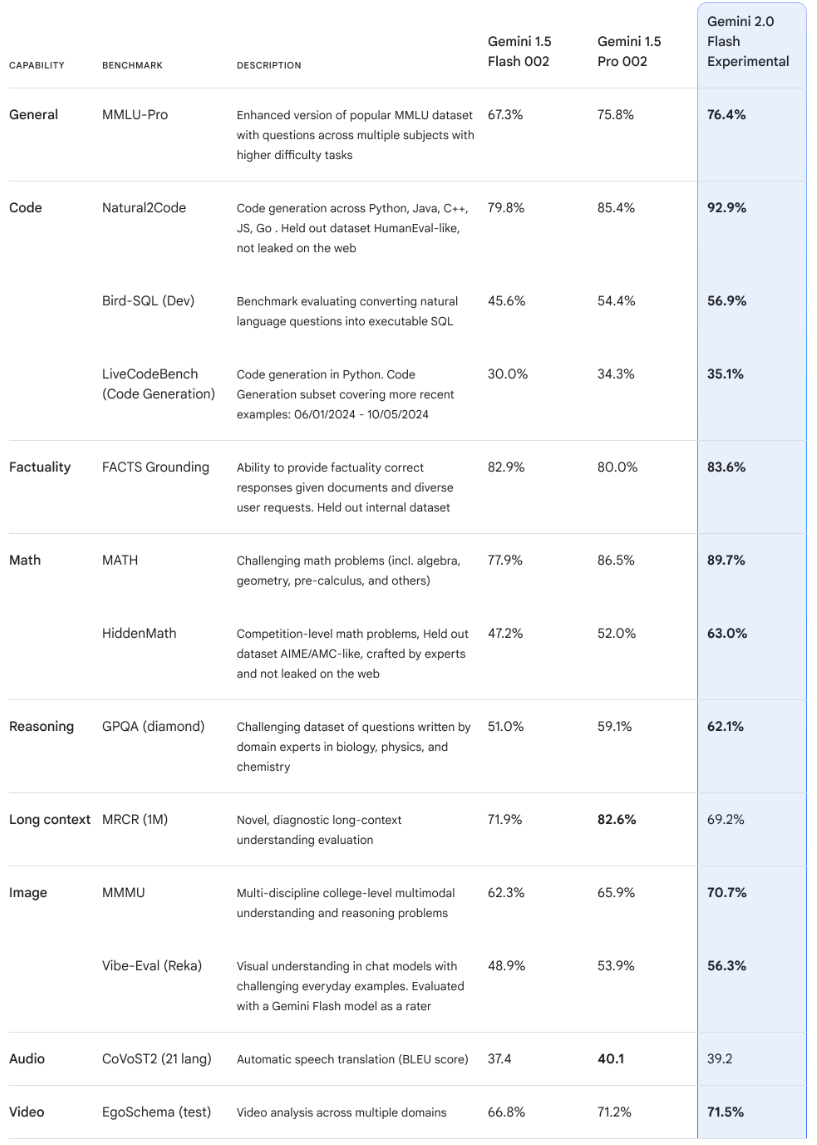

Im Vergleich zum Vorgängermodell Gemini 1.5 Pro ist das Flash 2.0 laut Google doppelt so schnell. In Benchmarks erreicht es fast die Leistung von Anthropics Sonnet "3.6", dürfte aber günstiger sein. Die Benchmark-Leistung kann jedoch von der Leistung in der Praxis abweichen.

Für Entwickler plant Google die Integration von Gemini 2.0 in verschiedene Plattformen wie Android Studio, Chrome DevTools und Firebase. Eine erweiterte Coding-Unterstützung namens Gemini Code Assist soll in gängigen IDEs wie Visual Studio Code, IntelliJ und PyCharm zur Verfügung stehen.

Parallel dazu öffnet Google den Zugang zu einer Chat-optimierten Version von Gemini 2.0 Flash Experimental für alle Gemini-Nutzer. Das Modell ist über das Dropdown-Menü auf Desktop und Mobile Web verfügbar, eine Integration in die mobile App soll folgen.

KI-Agenten für unterschiedliche Einsatzzwecke

Im Mittelpunkt der Ankündigung stehen drei neue Forschungsprototypen: Project Astra ist bereits bekannt und ein universeller KI-Assistent, der laut Google mehrsprachige Dialoge führen und bis zu zehn Minuten Konversationskontext speichern kann. Er soll Google Search, Lens und Maps nutzen können.

Project Mariner ist eine experimentelle Chrome-Erweiterung für Webaufgaben. Laut Google erreichte der Prototyp bei Tests mit realen Webaufgaben eine Erfolgsquote von 83,5 Prozent. Aus Sicherheitsgründen kann der Agent nur im aktiven Tab des Browsers agieren und muss bei sensiblen Aktionen wie Einkäufen eine Bestätigung des Nutzers einholen.

Mariner Demo | Video: via Google Deepmind

Der dritte Agent, Jules, richtet sich an Entwickler und ist in GitHub-Workflows integriert. Laut Google kann Jules asynchron arbeiten, mehrstufige Fehlerbehebungspläne erstellen und Pull-Anfragen vorbereiten. Der Agent steht derzeit nur einer ausgewählten Gruppe von Testern zur Verfügung.

Der zuvor angekündigte Data-Science-Agent für den Google Colab-Dienst wird auf Gemini 2.0 umgestellt. Er kann automatisch Analysen basierend auf Nutzerbeschreibungen erstellen. Nach Googles Angaben konnte der Agent in einem Projekt am Lawrence Berkeley National Laboratory die Analysezeit von einer Woche auf fünf Minuten reduzieren. Entwickler können hier Zugang beantragen.

Experimente mit Gaming und Robotik

Google DeepMind experimentiert laut eigenen Angaben auch mit dem Einsatz von Gemini 2.0 in Videospielen. Die Agenten sollen Spielern in Echtzeit Vorschläge für ihre nächsten Aktionen geben können.

Die KI-Agenten nutzen dafür die verbesserten multimodalen Fähigkeiten von Gemini 2.0: Das Modell kann das Geschehen auf dem Bildschirm analysieren und daraus strategische Empfehlungen ableiten.

Die Geschwindigkeit des Flash-Modells ist dabei eine wichtige Voraussetzung für Echtzeit-Gaming-Anwendungen. Auch Tests in der Robotik seien dank der verbesserten räumlichen Denkfähigkeiten des Modells geplant.

Google startet "Deep Research" für Gemini Advanced

Google führt mit "Deep Research" eine neue agentische Funktion für Gemini Advanced ein, die ab sofort für Abonnenten verfügbar ist. Laut Dave Citron, Senior Director of Product Management bei Google, soll die Funktion komplexe Recherchen automatisieren und in wenigen Minuten umfassende Berichte erstellen.

Der Prozess ähnelt laut Google der menschlichen Recherche: Die KI sucht, analysiert gefundene Informationen und startet basierend auf den Erkenntnissen neue Suchanfragen. Das Ergebnis wird in einem strukturierten Bericht mit Quellenangaben zusammengefasst, der sich in Google Docs exportieren lässt.

Die Funktion nutzt nach Googles Angaben ein neues agentisches System, das Googles Suchexpertise mit den Analysefähigkeiten von Gemini und einem Kontextfenster von 1 Million Token kombiniert.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.