Google veröffentlicht automatische KI-Video-Overviews für NotebookLM

NotebookLM erhält mit den neuen "Video Overviews" ein KI-Feature zur visuellen Aufbereitung komplexer Informationen. Auch das Studio-Panel wird neu organisiert.

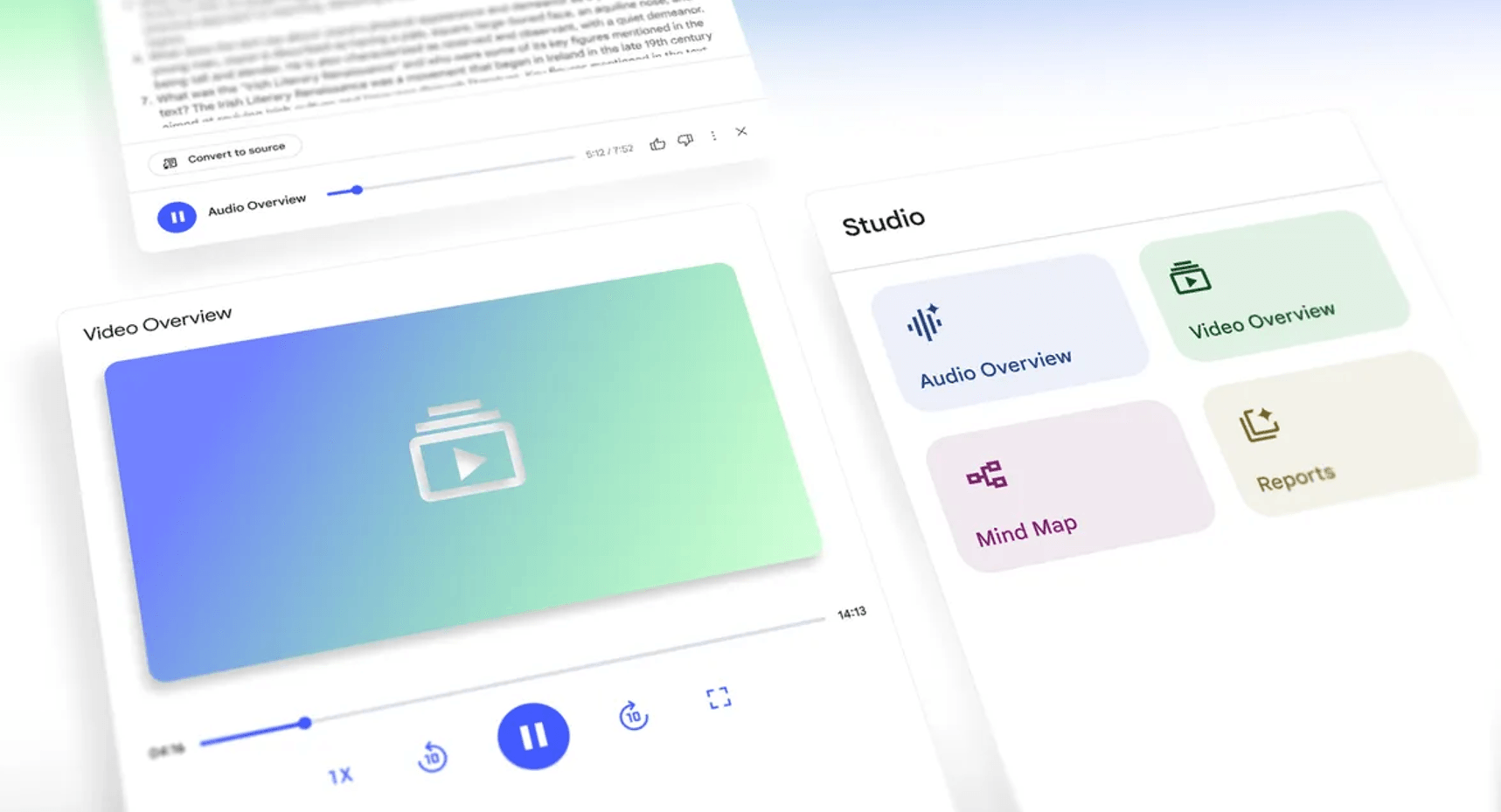

Google erweitert sein KI-gestütztes Recherchetool NotebookLM um eine neue Formatkategorie: Video Overviews. Die erste Version dieses Formats basiert auf automatisch generierten, gesprochenen Präsentationsfolien, die visuelle Elemente wie Bilder, Diagramme, Zitate und Zahlen aus den eigenen Dokumenten einbinden. Ziel ist es, abstrakte Inhalte greifbarer zu machen und komplexe Prozesse anschaulich zu erklären, wie Google im offiziellen NotebookLM-Blog mitteilt.

Video Overviews ergänzen die bestehenden Audio Overviews als visuelle Alternative und lassen sich ähnlich personalisieren. Nutzer können Lernziele, Zielgruppen oder thematische Schwerpunkte angeben. Möglich sind sowohl allgemeine Anfragen wie "Ich kenne mich mit dem Thema nicht aus – helft mir, die Diagramme zu verstehen" als auch präzise Aufgabenstellungen für Fachpublikum.

Die neue Funktion wird ab sofort für alle Nutzer in englischer Sprache ausgerollt. Weitere Sprachversionen sollen folgen.

Studio-Panel mit mehr Flexibilität

Neben den Video Overviews hat Google auch das Studio-Panel in NotebookLM überarbeitet. Nutzer können künftig mehrere Studio-Ausgaben desselben Typs in einem einzigen Notizbuch speichern – bislang war dies auf jeweils eine pro Typ begrenzt. Dies ermöglicht etwa die Erstellung mehrerer Mind Maps oder Video Overviews zu unterschiedlichen Kapiteln eines Kurses oder die gezielte Aufbereitung von Inhalten für verschiedene Rollen in einem Team.

Das neue Studio bietet zudem vier separate Kacheln zur Erstellung von Audio Overviews, Video Overviews, Mindmaps und Reports. Alle erzeugten Inhalte erscheinen gesammelt in einer Liste darunter. Ein weiteres neues Produktivitätsmerkmal: Audio Overviews lassen sich nun im Hintergrund abspielen, während man gleichzeitig an anderen Formaten weiterarbeitet.

Vor kurzem hatte Google NotebookLM um eine Sammlung kuratierter Notizbücher erweitert, etwa mit Inhalten von The Atlantic, The Economist und gemeinnützigen Organisationen. Diese Sammlung bietet Nutzerinnen und Nutzern Zugang zu Originaltexten samt Fragenfunktion, Audio Overviews und Mind Maps. Laut Google wurden seit dem Start über 140.000 öffentliche Notizbücher veröffentlicht.

Wo genau Google mit NotebookLM hin will, ist nicht so ganz klar. Als ChatGPT-Konkurrenten hat Google den Gemini-Chatbot im Programm, in die Suche sind ebenfalls Gemini-Modelle mit Suche-spezifischen Interfaces wie dem AI Mode integriert. NotebookLM läuft moderat erfolgreich nebenher, hat aber einen recht engen Fokus auf die Arbeit mit eigenen Quellen, was sinnvoll, aber voraussetzungsreich ist und wahrscheinlich eher ein Lehr- und Lernpublikum anspricht.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.